что значит disallow index php

Продвинутое использование robots.txt без ошибок — руководство для SEO

1 сентября 2019 года Google прекратит поддержку нескольких директив в robots.txt. В список попали: noindex, crawl-delay и nofollow. Вместо них рекомендуется использовать:

404 и 410 коды ответа сервера. В ряде случаев, 410 отрабатывает значительно быстрей для удаления URL из индекса.

Защита паролем. Страницы, требующие авторизации, также обычно удаляются из индекса (важно — именно страницы, полностью скрытые под логином, а не часть контента).

Временное удаление страницы из индекса с помощью инструмента в Search Console.

Disallow в robots.txt.

Тем не менее, robots.txt по-прежнему остаётся одним из главных файлов для SEO-специалиста. Давайте вспомним самые полезные директивы от простых, до менее очевидных.

robots.txt

Это простой текстовый файл, который содержит инструкции для поисковых краулеров — какие страницы сайта не следует посещать, где лежит наш Sitemap.xml и для каких поисковых роботов распространяются правила.

Файл размещается в корневой директории сайта. Например:

Прежде чем начать сканирование сайта, краулеры проверяют наличие robots.txt и находят правила специфичные для их User-Agent, например Googlebot. Если таких нет — следуют общим инструкциям.

Действующие правила robots.txt

User-Agent

У каждой поисковой системы есть свои «агенты пользователя». По сути, это имя краулера, которое помогает дать определённые указания конкретному ему.

Если брать шире, то User-Agent — клиентское приложение на стороне поисковой системы, в некотором смысле имитирующее браузер или, например, мобильное устройство.

User-agent: * — символ астериск используются для обозначения сразу же всех краулеров.

User-agent: Yandex — основной краулер Яндекс-поиска.

User-agent: Google-Image — робот поиска Google по картинкам.

User-agent: AhrefsBot — краулер сервиса Ahrefs.

Важно: если в файле указаны правила для конкретных User-Agent, то роботы будут следовать только своим инструкциям, игнорируя общие правила.

Disallow

Директива, которая позволяет блокировать от индексации полностью весь сайт или определённые разделы.

Может быть полезно для закрытия от сканирования служебных, динамических или временных страниц (символ # отвечает за комментарии в коде и игнорируется краулерами).

Упростить инструкции помогают операторы:

* — любая последовательность символов в URL. По умолчанию к концу каждого правила, описанного в файле robots.txt, приписывается спецсимвол *.

$ — символ в конце URL-адреса, он используется чтобы отменить использование * на конце правила.

Важно: в robots.txt не нужно закрывать JS и CSS-файлы, они понадобятся поисковым роботом для правильного отображения (рендеринга) контента.

Allow

С помощью этой директивы можно, напротив, разрешить каталог или конкретный адрес к индексации. В некоторых случаях проще запретить к сканированию весь сайт и с помощью Allow открыть нужные разделы.

Также Allow можно использовать для отдельных User-Agent.

Crawl-delay

Директива, теряющая актуальность в случае Goolge, но полезная для работы с другими поисковиками.

Позволяет замедлить сканирование, если сервер бывает перегружен. Устанавливает интервал времени для обхода страниц в секундах (для Яндекса). Чем выше значение, тем медленнее краулер ходит по сайту.

Несмотря на то, что Googlebot игнорирует подобные правила, настроить скорость сканирования можно в Google Search Console проекта.

Интересно, что китайский Baidu также не обращает внимание на Crawl-delay в robots.txt, а Bing воспринимает команду как «временное окно», в рамках которого BingBot будет сканировать сайт только один раз.

Важно: если установлено высокое значение Crawl-delay, убедитесь, что ваш сайт своевременно индексируется. В сутках 86 400 секунд, при Crawl-delay: 30 будет просканировано не более 2880 страниц в день, что мало для крупных сайтов.

Sitemap

Одно из ключевых применений robots.txt в SEO — указание на расположение карты сайты. Обратите внимание, используется полный URL-адрес (их может быть несколько).

Нужно иметь в виду:

Директива Sitemap указывается с заглавной S.

Sitemap не зависит от инструкций User-Agent.

Нельзя использовать относительный адрес карты сайта, только полный URL.

Файл XML-карты сайта должен располагаться на том же домене.

Также убедитесь, что ссылка возвращает статус 200 OK без редиректов. Проверить можно с помощью инструмента, определяющего ответ сервера или анализа XML-карты сайта.

Типичный robots.txt

Ниже представлены простые и распространенные шаблоны команд для поисковых роботов.

Разрешить полный доступ

Обратите внимание, правило для Disallow в этом случае не заполняется.

Полная блокировка доступа к хосту

Запрет конкретного раздела сайта

Запрет сканирования определенного файла

Распространенная ошибка

Установка индивидуальных правил для User-Agent без дублирования инструкций Disallow.

Как мы уже выяснили, при указании директивы User-Agent, соответствующий краулер будет следовать только тем правилам, что установлены именно для него. Не забывайте дублировать общие директивы для всех User-Agent.

В примере ниже — слегка измененный robots.txt сайта IMDB. Общие правила Disallow не будут распространяться на бот ScoutJet. А вот Crawl-delay, напротив, установлена только для него.

Противоречия директив

Список распространенных User-Agent

| User-Agent | # |

|---|---|

| Googlebot | Основной краулер Google |

| Googlebot-Image | Робот поиска по картинкам |

| Bing | |

| Bingbot | Основной краулер Bing |

| MSNBot | Старый, но всё ещё использующийся краулер Bing |

| MSNBot-Media | Краулер Bing для изображений |

| BingPreview | Отдельный краулер Bing для Snapshot-изображений |

| Яндекс | |

| YandexBot | Основной индексирующий бот Яндекса |

| YandexImages | Бот Яндеса для поиска по изображениям |

| Baidu | |

| Baiduspider | Главный поисковый робот Baidu |

| Baiduspider-image | Бот Baidu для картинок |

| Applebot | Краулер для Apple. Используется для Siri поиска и Spotlight |

| SEO-инструменты | |

| AhrefsBot | Краулер сервиса Ahrefs |

| MJ12Bot | Краулер сервиса Majestic |

| rogerbot | Краулер сервиса MOZ |

| PixelTools | Краулер «Пиксель Тулс» |

| Другое | |

| DuckDuckBot | Бот поисковой системы DuckDuckGo |

Советы по использованию операторов

1. Заблокировать определённые типы файлов.

Этот приём активно используется, если у проекта настроено ЧПУ для всех страниц и документы с GET-параметрами точно являются дублями.

Заблокировать результаты поиска, но не саму страницу поиска.

Имеет ли значение регистр?

Определённо да. При указании правил Disallow / Allow, URL адреса могут быть относительными, но обязаны сохранять регистр.

Но сами директивы могут объявляться как с заглавной, так и с прописной: Disallow: или disallow: — без разницы. Исключение — Sitemap: всегда указывается с заглавной.

Как проверить robots.txt?

Есть множество сервисов проверки корректности файлов robots.txt, но, пожалуй, самые надёжные: Google Search Console и Яндекс.Вебмастер.

Для мониторинга изменений, как всегда, незаменим «Модуль ведения проектов»:

Контроль индексации на вкладке «Аудит» — динамика сканирования страниц сайта в Яндексе и Google.

Директивы Disallow и Allow: как использовать совместно и раздельно

В данной статье речь пойдет о самых популярных директивах Dissalow и Allow в файле robots.txt.

Disallow

Disallow – директива, запрещающая индексирование отдельных страниц, групп страниц, их отдельных файлов и разделов сайта(папок). Это наиболее часто используемая директива, которая исключает из индекса:

Примеры директивы Disallow в robots.txt:

Правило Disallow работает с масками, позволяющими проводить операции с группами файлов или папок.

После данной директивы необходимо ставить пробел, а в конце строки пробел недопустим. В одной строке с Disallow через пробел можно написать комментарий после символа “#”.

Allow

В отличие от Disallow, данное указание разрешает индексацию определенных страниц, разделов или файлов сайта. У директивы Allow схожий синтаксис, что и у Disallow.

Хотя окончательное решение о посещении вашего сайта роботами принимает поисковая система, данное правило дополнительно призывает их это делать.

Примеры Allow в robots.txt:

Для директивы применяются аналогичные правила, что и для Disallow.

Совместная интерпретация директив

Поисковые системы используют Allow и Disallow из одного User-agent блока последовательно, сортируя их по длине префикса URL, начиная от меньшего к большему. Если для конкретной страницы веб-сайта подходит применение нескольких правил, поисковый бот выбирает последний из списка. Поэтому порядок написания директив в robots никак не сказывается на их использовании роботами.

На заметку. Если директивы имеют одинаковую длину префиксов и при этом конфликтуют между собой, то предпочтительнее будет Allow.

Пример robots.txt написанный оптимизатором:

Пример отсортированного файл robots.txt поисковой системой:

Пустые Allow и Disallow

Когда в директивах отсутствуют какие-либо параметры, поисковый бот интерпретирует их так:

Специальные символы в директивах

В параметрах запрещающей директивы Disallow и разрешающей директивы Allow можно применять специальные символы “$” и “*”, чтобы задать конкретные регулярные выражения.

Специальный символ “*” разрешает индексировать все страницы с параметром, указанным в директиве. К примеру, параметр /katalog* значит, что для ботов открыты страницы /katalog, /katalog-tovarov, /katalog-1 и прочие. Спецсимвол означает все возможные последовательности символов, даже пустые.

Примеры:

По стандарту в конце любой инструкции, описанной в Robots, указывается специальный символ “*”, но делать это не обязательно.

Пример:

Для отмены данного спецсимвола в конце директивы применяют другой спецсимвол – “$”.

Пример:

На заметку. Символ “$” не запрещает прописанный в конце “*”.

Пример:

Более сложные примеры:

Примеры совместного применения Allow и Disallow

Я всегда стараюсь следить за актуальностью информации на сайте, но могу пропустить ошибки, поэтому буду благодарен, если вы на них укажете. Если вы нашли ошибку или опечатку в тексте, пожалуйста, выделите фрагмент текста и нажмите Ctrl+Enter.

Правильный файл robots.txt для WordPress, Modx, Joomla, Opencart

Стоит учесть, что краулеры поисковых машин игнорируют определенные правила, например:

Директивы

Спецсимвол * означает любую, в том числе и пустую, последовательность символов, например:

Директива Clean-Param необходима, если адреса страниц сайта содержат динамические параметры, которые не влияют на содержимое, например: идентификаторы сессий, пользователей, рефереров и т. п.

Робот Яндекса, используя значения директивы Clean-Param, не будет многократно перезагружать дублирующуюся информацию. Таким образом, увеличится эффективность обхода вашего сайта, снизится нагрузка на сервер.

Например, страницы с таким адресом:

Параметр ref используется только для того, чтобы отследить, с какого ресурса был сделан запрос и не меняет содержимое, по всем трем адресам будет показана одна и та же страница с книгой book_id=123. Тогда, если указать директиву следующим образом:

робот Яндекса сведет все адреса страницы к одному:

Также стоит отметить, что для этой директивы есть несколько вариантов настройки

Кириллические символы в robots.txt

Использование символов русского алфавита запрещено в robots.txt, для этого необходимо использовать Punycode (стандартизированный метод преобразования последовательностей Unicode-символов в так называемые ACE-последовательности)

Рекомендации по тому, что нужно закрывать в файле robots.txt

Ошибки, которые могут быть в robots.txt

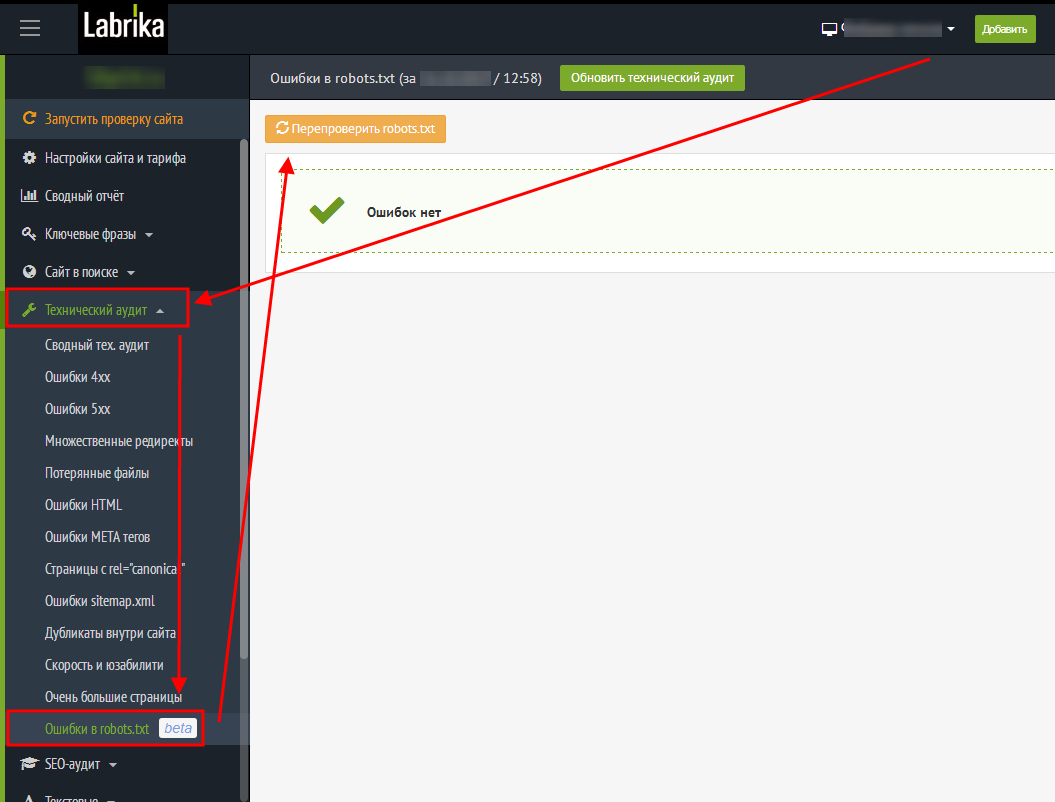

Проверка ошибок в robots.txt c помощью Лабрики

labrika→в левом меню Технический аудит→в выпадающем меню→Ошибки robots.txt→перепроверить robots.txt

Необходимо учесть, что файл размером больше 32кб считывается как полностью разрешающий, вне зависимости от того, что написано.

Что такое файл robots.txt

Директивы robots.txt

Директивы robots.txt — это набор инструкций, которыми руководствуются индексирующие роботы при посещении сайта. С их помощью можно закрыть определенные страницы или разделы от индексации, управлять скоростью обхода, указать ссылку на sitemap и т.д. Каждая директива должна прописываться с новой строки. После указания директивы ставиться двоеточие и далее прописывается её параметр.

Рассмотрим директивы подробнее.

User-agent robots txt

Robots txt disallow

Директива Disallow запрещает веб-краулерам индексировать страницу либо раздел. Наиболее часто используемая инструкция в файле robots.txt. С его помощью можно полностью закрыть сайт от индексации:

User-agent: *

Disallow: /

или от конкретного робота поисковой системы:

User-agent: Googlebot

Disallow: /

В качестве параметра следует использовать относительный путь к директории или странице (без указания доменного имени).

Robots txt allow

Директива Allow в robots.txt является разрешающей инструкцией для веб-краулеров. Очень полезна в случае, когда нам необходимо точечно открыть страницы / подразделы в закрытой директории сайта. Например:

User-agent: *

Disallow: /

Allow: /content

В приведенном примере директива Allow принудительно откроет роботам доступ к индексации страниц, начинающихся с /content, при этом весь остальной сайт будет закрыт от индексации.

Важно! Пустой параметр в директиве Allow запрещает индексацию всего сайта:

User-agent: *

Allow:

Clean-param robots txt

Директива Clean-param в robots.txt позволяет исключить из индексации веб-краулерами страницы с динамически генерируемым параметрами в URL. Использование Clean-param в файле robots.txt поможет исключить из индексации дубли страниц, генерирующиеся для реферальных ссылок, UTM-меток, при записи сессий и параметров пользователя.

К примеру мы имеем сгенерированный УРЛы с динамической записью параметра пользователя:

https://site.com/catalog/index.php?&id=1¶m=2

https://site.com/catalog/index.php?&id=2¶m=2

https://site.com/catalog/index.php?&id=3¶m=3

В данном случае нам необходимо составить правило для исключения получившихся параметров. Запись в файле роботс будет такой:

User-agent: *

Clean-Param: &id¶m /catalog/index.php

В результате такой строки индексироваться будет только страница https://site.com/catalog/index.php

С помощью Clean-param можно закрыть от индексации не только отдельные страницы, но и UTM-метки либо идентификаторы пользователей для всего сайта

Clean-Param: utm_source&utm_medium&utm_campaign

Crawl-delay robots.txt

Директива Crawl-delay в robots.txt позволяет управлять задержками между запросами веб-краулеров к страницам на веб-сервере. В качестве параметров можно указывать целые числа и десятичные дроби (точка в качестве разделителя). Единица измерения — секунды. Директива Crawl-delay поддерживается роботами Яндекс, Mail.Ru, Bing и Yahoo!.

Используется в случае если сервер не выдерживает частоту обращений поисковых роботов. Актуально в случае, когда веб-ресурс состоит из большого числа страниц и слабом веб-сервере.

Рекомендуется начинать применять минимальные параметры, постепенно их увеличивая при необходимости. Для неприоритетных поисковых систем можно изначально задать параметр «с запасом», чтобы исключить их влияние на стабильность сервера.

Пример:

User-agent: Yandex

Crawl-delay: 0.5

User-agent: Mail.Ru

Crawl-delay: 3

Тут мы задали задержку между запросами для Яндекс в пол секунды, а для Мэйл.ру — 3 секунды.

Robots txt sitemap

Директива Sitemap в robots.txt предназначена для указания пути к XML-файлу Sitemap. В качестве параметра необходимо указывать полный (абсолютный) путь к сайтмап. Указание данной директивы сигнализирует поисковым роботам о наличии карты сайта, что позволяет ускорить обнаружение и индексацию новых страниц. Директива не имеет привязки к конкретному юзер-агенту и может быть указана в любой строке файла роботс. Однако хорошим тоном считается указание сайтмап отдельно от всех директив через пустую строку:

User-agent: *

Allow: /

User-agent: Yandex

Allow: /

User-agent: Googlebot

Allow: /

Sitemap: https://site.com/sitemap.xml

Устаревшая директива Host

До 20 марта 2018 года поисковая система Яндекс использовала директиву Host для определения главного зеркала. На данный момент поисковик не учитывает её и рекомендует пользоваться 301 редиректом. Однако в сети интернет по прежнему можно найти массу сайтов у которых директива Host указана.

User-agent: Yandex

Disallow: /catalog/

Allow: /catalog/index.php

Host: https://site.com

Прочие директивы robots.txt

Спецификация файла роботс содержит две дополнительные директивы:

— Request-rate: 1/3 ограничивает скорость загрузки страниц, не более одной за три секунды (параметры можно задать любые);

— Visit-time: 0815-1000 определяет временной интервал по гринвичу, в который веб-краулерам разрешено индексировать страницы ( в примере это промежуток с 08:15 по 10:00).

Однако на данный момент они не поддерживаются ведущими поисковыми системами и их использование не имеет смысла.

Использование регулярных выражений

В файле robots.txt для более гибкой настройки параметров директив часто используются спецсимволы, которые значительно расширяют функционал. К ним относятся:

1. * (звездочка) определяет любую последовательность символов в том месте, где она указана.

В конце строки звездочка не обязательна, т.к. роботы предполагают её наличие по умолчанию.

В качестве примера

User-agent: *

Disallow: /catalog/*

Allow: /catalog/*.css

Allow: /catalog/*.php

Для чего нужен файл robots.txt сайту и как его правильно составить

Файл robots.txt – это обычный текстовый файл, находящийся в корне сайта, в котором находятся некие указания для роботов поисковых систем, что им нужно индексировать, а что нужно исключить. Его используют на любых типах сайтов, а в интернет-магазинах он особенно актуален, т.к. скрывать от индексации есть чего, иначе в поисковой выдаче есть риск увидеть совсем не те страницы, которые вы хотели бы видеть. Отсутствующий или неправильно составленный файл может сказаться на дальнейшем SEO-продвижении не в лучшую сторону, как вы понимаете.

Проверить есть ли у вас этот файл можно в корне вашего сайта используя файловый менеджер в панели управления хостингом, либо подключившись по FTP. А также при помощи добавления в адресную строку названия файла «robots.txt», должно получится что-то вроде – «https://ваш-сайт/robots.txt». Если файл существует, то вы увидите содержимое этого текстового файла с набором так называемых директив, о которых поговорим чуть ниже. Создать файл можно в любом текстовом редакторе, который поддерживает формат UTF-8.

Директивы файла robots.txt

Их в общем не много и разобраться не составит большого труда. Однако у Гугла и Яндекса количество директив различается, у Яндекса их чуть больше:

User-agent. Это обязательная директива, которая указывает для какого робота действуют правила. Часто правила прописывают для всех роботов, тогда вместо их названия используется звездочка – «*». Если же требуется написать правила отдельно для каждой поисковой системы или для конкретного робота в частности, то и это можно сделать, указав после директивы название робота. Их существует огромное количество (несколько сотен), но нам достаточно будет знать всего несколько для поисковых систем Яндекса и Гугла (их список я приведу ниже в этой статье).

Disallow. Эта директива является второй по значимости, она запрещает индексирование разделов или отдельных страниц сайта, а также каких-либо папок или файлов на сервере. Обычно с ее помощью закрывают от индексации административный раздел сайта, кабинет пользователя, корзину, либо иные страницы, которые могут содержать конфиденциальную информацию. Также можно закрыть какие-либо файлы и папки, которые вы храните на сервере для использования вашими сотрудниками или постоянными клиентами. Поисковики помимо индексации HTML страниц еще с легкостью умеют индексировать файлы MS Office (Word, Excel например) или PDF-файлы. Поэтому, не закрыв их от поисковиков, вы покажите тем самым эти файлы всему миру и эти данные будут доступны в результатах выдачи поисковых систем. Однако я не рекомендую хранить файлы с конференциальной информацией на своем сервере незащищенными, т.к. файл robots.txt не скрывает их никак от посторонних глаз, да и поисковая система их прекрасно видит, однако не индексирует, а соответственно эти данные просто не появляются в поисковой выдаче и найти их немного сложнее неподготовленному пользователю.

Allow. Эта директива напротив разрешает сканирование того или иного раздела сайта, отдельной страницы или каких-либо папок и файлов на сервере. Обычно используется для того, чтобы например в уже закрытой папке содержащей внутри огромное количество подпапок, открыть одну или несколько для индексации. Это значительно проще чем указывать для закрытия каждую подпапку в отдельности (ведь их на сервере могут быть десятки или даже сотни).

Sitemap. Эта директива указывает на наличие на сайте файла sitemap.xml. Это некая карта, которая содержит структуру вашего сайта и помогает поисковикам быстрее находить те страницы, которые еще не были проиндексированы или были недавно изменены. Указывается директива в виде полного URL с префиксами HTTP и HTTPS или с элементом WWW и без него.

Clean-param. Данная директива доступна только для робота Яндекса и используется чтобы исключить из индекса страницы, которые содержат в адресе GET-параметры (идентификаторы сессий или пользователей) или UTM-метки, которые не влияют на содержимое страницы. Это нужно для того, чтобы не было дублей, т.к. страницы с этими параметрами и без – это разные страницы для поисковика, даже если их содержимое идентично. А дубли страниц не очень хорошо влияют на SEO-продвижение.

Crawl-delay. Это устаревшая директива Яндекса, которая перестала учитываться 22 февраля 2018 года. Отвечала она за минимальный период времени в секундах, которые должны пройти между окончанием загрузки одной страницы и началом загрузки следующей. Вместо этого Яндекс рекомендует использовать настройку скорости обхода сайта в Яндекс.Вебмастере. Если у вас уже есть файл robots.txt на вашем сервере, и вы видите там эту директиву, то можете смело ее удалять.

В файле robots.txt при написании правил могут использоваться некоторые символы:

Вот один из простых примеров robots.txt:

Роботы Яндекса и Google

Как писал выше, роботов существует огромное множество, но нам интересны только для Яндекса и Гугла, другие поисковые системы занимают очень маленький процент рынка и под них обычно правила не пишут. Делают либо для всех роботов (указывая в User-agent звездочку), либо пишут немного различающиеся правила для Яндекса и Google. Вот список тех, которые вам могут пригодится.