какие игры поддерживают 2 видеокарты

Какие игры поддерживают 2 видеокарты

В сети уже который год популярно мнение о том, что технология Nvidia SLI мертва, никем не поддерживается и безнадёжно устарела. Пользователи считают, что в новых играх уже нет возможности использования двух GPU, ведь проектов с официальной поддержкой SLI с каждым годом всё меньше и меньше.

реклама

Однако подобная точка зрения далека от истины, ведь даже в играх без официальной интеграции технологии SLI таки можно включить благодаря программе Nvidia Profile Inspector. Через неё можно вручную заставить работать SLI даже в тех играх, авторы которых не стали утруждать себя добавлением официальной поддержки технологии. Это убедительно доказали в своих тестах ребята с канала Techno-Kitchen ещё в 2019 году.

Но с тех пор успело выйти ещё одно поколение видеокарт от Nvidia и уже другой энтузиаст с канала TheSpyHood решил сравнить возможности связки из двух GTX 1080 Ti с производительностью флагманской RTX 3090. И оказалось, что два топовых Паскаля почти не отстают от самого мощного Ампера. В большинстве протестированных игр RTX 3090 оказалась быстрее на 5-15%, а вот её цена превосходит стоимость двух 1080 Ti с вторичного рынка в 2 с лишним раза. Цифры FPS в тестах довольно близки к результатам Технокухни. Разве что последние не проводили тестирования в 4К.

Стоит заметить, что для системы с SLI также желательна материнская плата с двумя PCIe х16 разъёмами и более мощный блок питания. К тому же греться такая сборка будет куда сильнее и в идеале потребует водяного охлаждения. А ещё пользователь останется без аппаратной поддержки рейтрейсинга, что тоже не добавляет такому сетапу привлекательности. Наконец, ковыряния в не самой дружелюбной к пользователю программе Nvidia Profile Inspector и поиск идеальной конфигурации SLI придётся по вкусу далеко не каждому. Но всё же потенциал архитектуры Pascal всё равно впечатляет. А уж если у пользователя уже есть одна 1080 Ti, то подобный ход и вовсе можно считать отличным вариантом апгрейда.

Есть ли практическая польза от двух видеокарт в играх

Две видеокарты, установленные на одном компьютере и объединенные при помощи SLI (Scalable Link Interface) от NVIDIA или CrossFire от AMD, дают прирост в производительности 15-30%. Очень редко, в зависимости от оптимизации игр, прирост может достигать 50%. Технология AMD CrossFire оптимизирована заметно хуже, чем SLI от NVIDIA. Если интересно, то более подробно читаем далее ⇒

Дальнейшее развитие параллельного соединения GPU

С выходом нового поколения видеокарт GeForce RTX, NVIDIA анонсировала и новый интерфейс (мост) NVLink для соединения двух графических процессоров для совместной работы. Соединяются они при помощи NVLink Bridge

Судя по моему анализу различных игровых тестов, проведенных с двумя видеокартами последних поколений 2080Ti, новый интерфейс практически во всех современных играх в разрешении 8k (7680 × 4320 точек) дает минимум 40% прирост производительности, по сравнению с работой SLI режима на двух 1080Ti. Ниже на изображении я привел результаты одного из таких тестов.

Мониторы 8k сейчас еще очень дороги и практическая польза такого теста минимальна, но он хорошо показывает перспективы возможного увеличения применения двух видеокарт в недалеком будущем.

Стоит обратить внимание на результаты тестирования двух RTX 2080. Они значительно хуже его старшего собрата. В игре Rise of the Tomb Raider две 2080Ti в 8k выдают 50fps, а 2080 только 37fps. Это сильное падение производительности.

Не думаю, что это связано с недостатком видеопамяти. Скорее всего, драйвера для распараллеливания графических данных лучше оптимизированы под 2080Ti, так как по своим характеристикам она близка к профессиональным решениям NVIDIA для параллельных вычислений, под которые изначально и разрабатывался новый интерфейс. Я надеюсь, что более поздние версии драйверов доведут до ума и они будут оптимизированы значительно лучше.

Кстати, NVLink, в отличие от SLI, поддерживает объединение видеопамяти обоих видеокарт.

Как установить две видеокарты на ПК

В будущем нам придется очень грамотно планировать покупку компьютера. Если разница в потреблении энергии между 2-мя и 4-мя планками оперативной памяти не значительна, то при установке 2 видеокарт или более, нам необходимо будет учитывать их суммарную потребляемую мощность.

На материнской плате должны быть слоты для установки двух видеокарт и с обязательной поддержкой их совместной работы. Чтобы узнать, поддерживает ли материнская плата две видеокарты, перейдите на официальную страницу производителя системной платы и проверьте спецификации. Так же это можно определить по наличию на коробке логотипа Crossfire, SLI или NVLink.

Блок питания также должен обладать достаточной мощностью, чтобы тянуть все железо компа+2 видеокарты. Сейчас для этого необходимо около 900 Вт для 2х топовых видях.

При использовании двух видеокарт, игры становятся процессорозависимыми.

Чем выше разрешение вы используете, и чем больше даете нагрузку на видеокарту(ы), тем меньше это проявляется.

При уменьшении разрешения монитора и уменьшении нагрузки на видеокарт(у)ы, этот эффект уменьшается до его полного исчезновения, так как узким местом становиться видяха, а не центральный процессор.

Для работы с двумя топовыми видеокартами, вам придется раскошелиться и на максимально мощный процессор, иначе все это не имеет смысла.

Должно быть организовано качественное охлаждение всех ваших комплектующих системного блока, так как общее тепловыделение очень высокое.

Связывайте NVLink только видеокарты выполненные на однотипном графическом процессоре. Производитель не важен, но важна частота работы GPU, так как при объединении обе видяхи будут работать на меньшей частоте. Например у нас одна карточка, которая имеет рабочую частоту 1695 Мгц, а другая 1770 Mгц, то в совместном режиме они обе будут работать на 1695 Мгц. Все точно так же, как у оперативной памяти.

Пара графических карт требует вместительного компьютерного корпуса, которого будет достаточно как для их установки, так и дополнительного оборудования.

В панели управления драйвером графического процессора, должна быть включена функция NVLink, SLI или Crossfire.

Выводы и умозаключения

С выходом NVLink, технологию CrossFire от AMD можно смело хоронить. Она и так была хуже по реализации, чем SLI, а теперь вообще не конкурент. AMD срочно нужно что-то новое придумать, так как технологии совместной работы двух и более видеокарт станут намного производительнее, что повлечет за собой их распространение. Это станет еще одним конкурентным преимуществом.

Я думаю, что параллельная работа двух и более видеокарт будет похожа по развитию на многоядерные процессоры. Технологические процессы изготовления чипов уже настолько малы, что выпускать более сложные микросхемы становиться дорого.

Заметьте рост цен на топовые видеокарты. Я помню еще те времена, когда топовый на то время видеоускоритель ATI Radeon 9700pro

стоил 16000 руб (около 500 баксов). Сейчас, даже с учетом роста курса, топовая видяха стоит 1500 долларов.

Сделать многоядерным графический процессор скорее всего не получиться, так как он намного сложнее центрального. Да и с отводом тепла что-то придумывать придется. Проще отладить технологию параллельных вычислений и завести ее качественную поддержку во все игры, а не как сейчас. С выходом следующего поколения видеокарт, будет реально видно, куда будет идти развитие.

Уже можно сказать точно, что поддержки работы двух и более видеокарт не будет в тех моделях, которые по общей стоимости будут равны или дороже топового варианта из их же поколения. Смысла в покупке такого тандема просто не будет (как и сейчас нет). Лучше будет взять одну топовую видяху, чем два середнячка, а через год-два взять еще одну (уже дешевле) и увеличить производительность на 100%. Как раз к этому времени лучшую оптимизацию подвезут и игры новые появятся для такой производительности. Сейчас производители обновляют модельный ряд видеокарт примерно каждые 18 месяцев. Скорее всего эти сроки будут увеличены.

На момент написания статьи положение дел такое, что устанавливать в компьютер две видеокарты имеет смысл, только если у вас разрешение монитора 4k и более. Только тогда вы получите прирост скорости в играх. Для меньших разрешений целесообразно купить одну хорошую видеокарту.

В общем, пока использование двух видеокарт в компьютере, остается уделом богатеньких буратино. И таким останется ближайшие 2-3 года. При примерном подсчете, стоимость игровой системы с двумя современными топовыми видеокартами ушла за 300 тысяч, вместе с монитором на 8k, и чуть дешевле на 4k.

Более приземленных пользователей хочу обрадовать, что сильно расстраиваться пока не о чем, так как на самые ходовые разрешения и мониторы одной, среднего уровня видеокарты, пока более чем достаточно. Об этом подробнее я рассказал в статье о выборе монитора и видеокарты.

Начало Эры Multi-GPU видеокарт или когда две головы лучше одной

реклама

Кто ответит на вопрос «Почему?» Возможно, индийские программисты устали писать код, а возможно коронавирус этому помешал, а может производители игр не хотят заниматься дальнейшей поддержкой этой технологии? Сплошные вопросы, не так ли? Но, наш клуб с экспертами-комментаторами, я уверен, прольет свет и ответит на эти и другие вопросы.

А пока сходим в техническую библиотеку отдела Nvidia. Где-то лет 20 назад, почитаемая компания номер 1 в 3D графике приказала долго жить. И Nvidia купила ее, а заодно все её наработки и патенты. Олдфаги, догадались, что речь идет о 3DFx. 3DFx была первой компанией, которая дала миру SLi!

реклама

Одна вторая «Вуду» тянула лишь 800 на 600. Вот, тогда польза от второй видеокарты была как раз осязаема, реальна нужна. А что сейчас делать с парой RTX 3090? Хороший такой вопрос, но оставим его без ответа, на совесть владельцам RTX 3090, я думаю они появятся в обсуждении и всё нам расскажут. Я пока сижу на встройке и о RTX 3090 могу лишь мечтать, как и 99% всех, кто сюда забрел.

Итак, Nvidia купила 3DFx и получила доступ к технологии SLi. Я рассказываю по-простому, на самом деле технология построения изображения у обоих компаний в корне отличались, но для обывателя они называются одинаково и в обоих случаях обе видеокарты соединяются физически с помощью гибкого мостика, шлейфа или перепаянного куска кабеля от «флоппика». И после этого в недрах самой «зеленой» компании родился «План Б» по захвату всего рынка 3D ускорителей. Пока ATI сидела и курила нервно в сторонке, гибкие мостики окутывали умы инженеров Nvidia и маркетологов. И вот тот день настал!

реклама

А если к этому добавить смену molex коннекторов на специальные 6-pin коннекторы для видеокарт, то и на все 100%. В то время изможденные геймеры, со старыми блоками питания, бродили по компьютерным рынкам в поисках переходников molex-6pin. Тогда еще не было AliExpress и засилья китайским мастеров. Я сам ждал свой коннектор для новой видеокарты 3 дня!

реклама

Местные предприниматели его вытащили из коробки и видимо потом перепродали. В общем, проблем стало у всех как минимум на одну больше. А все из-за 3Dfx, которая протянула неожиданно ноги. Хитрые игроделы, получив допинг от известной компании сразу же заявили, что их игры будут работать быстрее в 2 раза, главное — это купить эту лицензионную игру и вторую видеокарту.

Любители помериться попугаями в тестовых бенчмарках тоже побежали покупать вторую видеокарту, ведь нужно больше золота, очков в итоговом окошке теста. В общем, как ни крути, но вторую видеокарту каждый порядочный энтузиаст был обязан купить. В то время, я был в Швеции и собственноручно видел, как сметали с прилавков магазинов новенькие 6600GT и 6800GT. Сейчас можно вспомнить аналогию очередей за Iphon’ами, хотя это скучно, ведь зачем покупать второй «Айфон»? Звонить самому себе? Я лучше побеседую с Siri.

В день анонса было разбито несколько тысяч бутылок шампанского и детских мечт. Обзорщики плакали и рыдали, ведь им посчастливилось прикоснуться к святому Граалю, квинтэссенции бытия 3D и просто хорошей видеокарте с двумя GPU на борту. Но был, как всегда, один нюанс. О котором не сочли нужным все рассказать и те пользователи, которые купили эту видеокарту, потом остались без ногтей.

Они из загрызли их до дыр. А все потому, что это волшебная видеокарта могла работать только на паре моделей материнских плат Gigabyte. Опять горе и слезы. Но главное ведь продать, а пользователи сами потом разберутся. Естественно, в мануале все было написано, но наши люди сначала делают, а потом читают. Я и сам так иногда делаю, чего скрывать.

В общем все обзорщики похвалили инициативу Gigabyte, пожали руки и разошлись, захватив с собою шампанское. А Pr-отдел гигабайта не сидел сложа руки, в недрах секретной лаборатории кипела работа над двойной 6800 GT! Черт побери, это даже круче чем сейчас одна RTX3090. И они это сделали! Так появилась Gigabyte 3D1 6800GT Dual. Это по истине царская карта взгляните сами.

За эту карту не грех и почку было в то время отдать. Внешний респектабельный вид, радиатор в позолоте, уникальный дизайн и голубой текстолит, все говорило, что к хозяину такой карты без стука лучше не подходить. Если вы проникните в его жилище чтобы хотя бы одним глазком посмотреть на этот шедевр инженерной мысли, если он вас сам не убьёт, то вас точно загрызет его собака. Поэтому нужно сначала стучаться.

Для более простых энтузиастов или младших братьев обладателей Gigabyte 3D1 6800GT Dual, компания Gigabyte выпустила младшую модель на базе двух GPU 6600 без суффикса GT. Ну а что, всё правильно, каждому брату по видеокарте. Называлась такая видеокарта Gigabyte 3D1 XL 6600 Dual.

Алло Асус? Срочно зайдите в ординаторскую, пациенту плохо! У него неизлечимая SLi-зависимость и срочно нужно видеокарто-вмешательство. Да вы не ослышались, чтобы было делать реальным пацанам с мамками не от Gigabyte? Не менять же свой топ и не изменять своему любимому бренду! А таких было много, головные боли не могли излечить даже в Pr-отделах многих компаний. Но, как всегда, нашлись спасители, кошельков и душ страждущих.

Размеры этого монстра приводили всех в шок, таких видеокарт тогда еще не видел никто! Все были в шоке, даже отец одного школьника, которого развели на эту «дуру». Мало того, что она не вмещалась в системный блок, так и старенький блок питания уходил в защиту и ни при каких обстоятельствах не выходил из неё. Пришлось покупать новый корпус и блок питания, ну а что делать, обратного пути уже не было. В комплекте к видеокарте шел специальный SLI переключатель, который позволял этой видеокарте работать, где пожелает её повелитель.

Темный кожух, приставка Extreme, на коробке сам Посейдон или Зевс, ну что еще нужно? Правильно – вторую такую! Но пока еще производители не решили эту проблему, поэтому такая видеокарта стояла в системнике в гордом одиночестве.

Сейчас сюда могут набежать многочисленные Павлики и Кириллы комментаторы, и вставить жестко свои 5 копеек, но я вам отвечу, коли SLi тогда не пробовали, не стоит и сейчас на форуме размазывать. Едем дальше. Прогресс набирал обороты, Nvidia выкатила 7000-ю серию видеокарт. Как же все обрадовались, я помню салюты возле дома. Даже один бомж спросил: «Вадим, а что за праздник?». Я говорю – Володя, это геймеры радуются. Владимир Сергеевич тогда не понял, кто такие эти геймеры, он грязно выругался и полез обратно в коробку из-под холодильника. Вот так у нас встретили новую линейку видеокарт.

В качестве ядерного реактора выступал внешний блок питания видеокарты. Инженеры из ASUS пожалели бедных отцов геймеров, теперь их старые блоки питания не боялись работать в системе с такой видеокартой. Но теперь страх был у мамы. А причем тут мать? Да при том, что чадо требовало купить эту видеокарту, а в ASUS посчитали, что только 2000 геймеров смогут ее получить, так-как она вышла в серии Limited Edition. В Pr-отделе ASUS придумали новую маркетинговую стратегию, которая в последствии еще не раз всем нам аукнется.

Итак, все матери геймеров, сплотились в одну организацию противодействия секте Liminte Edition, но ничего не вышло. Демократия она такая.

Пока они ходили с транспарантами, пара мамаш подсуетилась и купила своим 20-ти летним сыночкам сразу по паре видеокарт. Зачем? А затем, что эти две видеокарты можно было объединять в SLi, хотя соединительного мостика они не имели! Вот сюрприз, так сюрприз, а ведь многие этого и не знали. Хотя за полтос данную инфу продавали бабки в одном переулке.

Когда геймеры видели такой скриншот, они прятались под стол. Ведь такого вообще быть не могло. Но теперь даже вы знаете, что это возможно! Это и есть та магия Voodoo 😉

А результаты от игры в FEAR могли и вовсе сделать не подготовленного геймера очень нервным человеком, я сам даже боюсь смотреть на эти цифры после полуночи, а ведь тогда было еще страшнее.

Кто захочет испытать страх, сможет эту табличку и другие такие найти на THG.ru А потом все проснулись и выключили телевизор. Утром следующего дня Мир был уже не таким, как раньше. В Nvidia подумали, а почему они ходят в магазин, а сливки со сметаной все время достаются соседскому коту? Ну вы поняли, речь идет о своей прибыли. Почесав за ухом и щёлкнув пальцами, на свет была произведена по истине первая реальная DUAL-GPU видеокарт NVIDIA 7900 GX2 от самой основательницы.

Это миф или реальность? Никто не мог понять, что это за такое изделие, похоже на слоеный бутерброд. Это видеокарта – ответила маленькая девочка, ложа в свою сумочку такую же вторую. Да, теперь официально такие видеокарты поддерживали QUAD-SLi.

Если бы тогда был изобретен майнинг, все манеры бы застрелились еще тогда, только от вида таких четырех видеокарт в одной системе, и я бы вам не надоедал со своим анализом стоимости цен на видеокарты RTX 2000 и 3000-й серии. Но история пошла по другому пути.

Потом поняв, что они ошиблись, R&D Nvidia выпустил упрощенную модель NVIDIA 7950 GX2, карта была гораздо короче, что не давало такой статусности новому владельцу. И если основным производителем NVIDIA 7900 GX2 была сама Nvidia, то NVIDIA 7950 GX2 клепали все подряд. И таинства чуда и причастности к волшебству уже никто не получал. Очень жаль.

А далее события развивались по накатанной. После NVIDIA 7950 GX2 была выпущена NVIDIA 9800 GX2. Ну а что делать, деньги то нужны всем. На этот раз бутерброд обрел пластиковый кожух, который мог превращаться в маленький гробик, если геймер не пылесосил этот кирпич два раза в неделю.

Видеокарта было очень горячей, но, к сожалению, после 8800 Ultra, это уже стало нормой. Папа иногда гладил ею свой галстук, а мама могла приготовить на ней горячие пирожки, чтобы дать их собой в школу.

На этом я поставлю жирную точку. Хотя запятая была бы более актуальна, ведь история не закончилась, но я подожду ваших гнилых помидор в свой адрес в комментариях или хвалебных од в свой адрес. И вы мне скажите, что пора завязывать или писать продолжение.

NVIDIA SLI в современных играх: тест двух видеокарт ASUS ROG Strix GTX 1080 в одной системе

У технологии NVIDIA SLI богатая история. Идея распределения нагрузки между несколькими графическими адаптерами родилась в конце 90-х годов во времена популярности видеокарт Voodoo от фирмы 3dfx, и тогда еще не существовало никакого «слая». По-настоящему эффективное распространение GPU-связок произошло в 2000-х, когда аппаратных ограничений для построения систем из 2/3/4 адаптеров стало меньше, плюс появились оптимизированные под это дело игры и программы.

С тем фактом, что большинство игр будут неадекватно воспринимать используемую вами связку NVIDIA SLI, стоит смириться как можно раньше.

Сейчас технология NVIDIA SLI используется в основном энтузиастами и моддерами. Первым дополнительная видеокарта (или несколько видеокарт) необходима для получения рекордного результата в синтетических бенчмарках (именно тестовые приложения адекватнее всего реагируют на бонусные графические мощности в системе), вторым — для эффектной иллюминации внутри ПК, с дополнительными светодиодами и т. д.

Геймеры отдают предпочтение одному адаптеру в системе, что вполне оправдано. Регулярно проводимые тесты NVIDIA SLI в современных играх доказывают, что разработчики весьма неохотно оптимизируют свои проекты под мощные мульти-графические связки из нескольких ускорителей. По сути это и есть главное ограничение на пути развития данной технологии.

Зачастую один мощный графический адаптер уровня high-end оказывается мощнее двух видеокарт более низкого класса. Ко всему прочему, поддержка SLI в последнее время внедряется лишь в самые топовые ускорители (производительности которых и так достаточно для большинства игр), что также негативно сказывается на развитии мульти-графических систем.

Если вы все-таки решились на сборку системы NVIDIA SLI, состоящей из нескольких адаптеров, рекомендуем в первую очередь поразмышлять над следующими техническими тонкостями:

Трудности при сборке и эксплуатации технологии NVIDIA SLI

Без подводных камней обойтись не получится; хотя еще раз повторимся: с ходом времени технология NVIDIA SLI эволюционирует. Слабых мест становится меньше, а процесс сборки и использования мульти-графических связок упрощается.

Ожидать двукратного прироста от дополнительной GeForce GTX 1080 в системе не стоит.

Первое, о чем необходимо позаботиться сразу после сборки системы, — правильное распределение процессорных линий PCI-E между используемыми адаптерами. Поясним. Каждый процессор поддерживает ограниченное количество линий PCI-E (как правило, 16, 28 или 44).

Все ЦП для платформы LGA 1151 не вылезают за рамки 16 линий, а значит две видеокарты способны функционировать лишь в режиме х8+х8 (собственно это убедительный довод в пользу отказа от построения NVIDIA SLI в подобных системах).

А вот процессоры для LGA 2011 и LGA 2066 поддерживают 28 и 44 линии PCI-E (в зависимости от модели), и это уже достаточный арсенал для раскачки двух или трех видеокарт.

К слову, в этом обзоре мы сравним возможности режимов х16+х16 и х16+х8; в этом нам помогут центральные процессоры Intel Core i9-7900X (у него 44 линии) и Core i7-7800X (у него — 28).

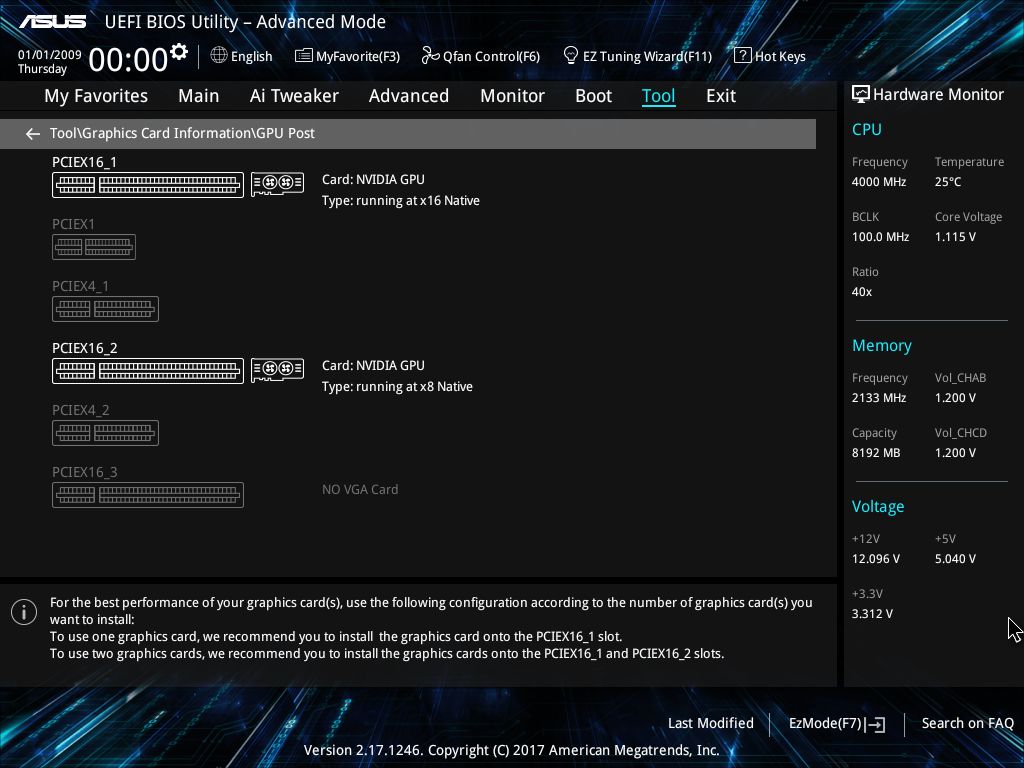

Итак, еще до сборки NVIDIA SLI пользователь должен знать о технических возможностях своего ЦП, а следовательно и о правильном распределении процессорных линий PCI-E. Эту правильность необходимо проверить сразу после первого включения системы. Лучше всего это сделать в UEFI BIOS.

Современные материнские платы делятся подробной технической информацией об установленных в нее комплектующих, в том числе о распределении пресловутых линий PCI-E между адаптерами. Данные можно промониторить и в среде Windows, например, в программах GPU-Z и AIDA64.

Если в вашем распоряжении оказался процессор с 44 линиями PCI-E, а система показывает, что пара видеокарт функционирует в формате х16+х8 (мы лично столкнулись с такой проблемой), придется убедить ПК в том, что он не прав. В нашей ситуации помогла перестановка двух ускорителей; мы просто поменяли их местами, после чего система распределила линии правильно (х16+х16).

В большинстве игр одна GeForce GTX 1080 Ti оказывается не хуже, чем пара GeForce GTX 1080.

Еще одна трудность, которая может возникнуть после сборки NVIDIA SLI, — черный экран или некорректное отображение картинки на мониторе (например, недоступно разрешение 4К, с которым дисплей в принципе работать умеет).

Скорее всего, дело в неверно выбранном коннекторе подключения с обратной стороны ускорителя. Определить правильный поможет, опять же, драйвер (панель управления). Во вкладке SLI отображен требуемый для корректного вывода картинки разъем одной из используемых видеокарт. Впрочем, найти его можно и вручную, банально подрубая провод к каждому графическому интерфейсу.

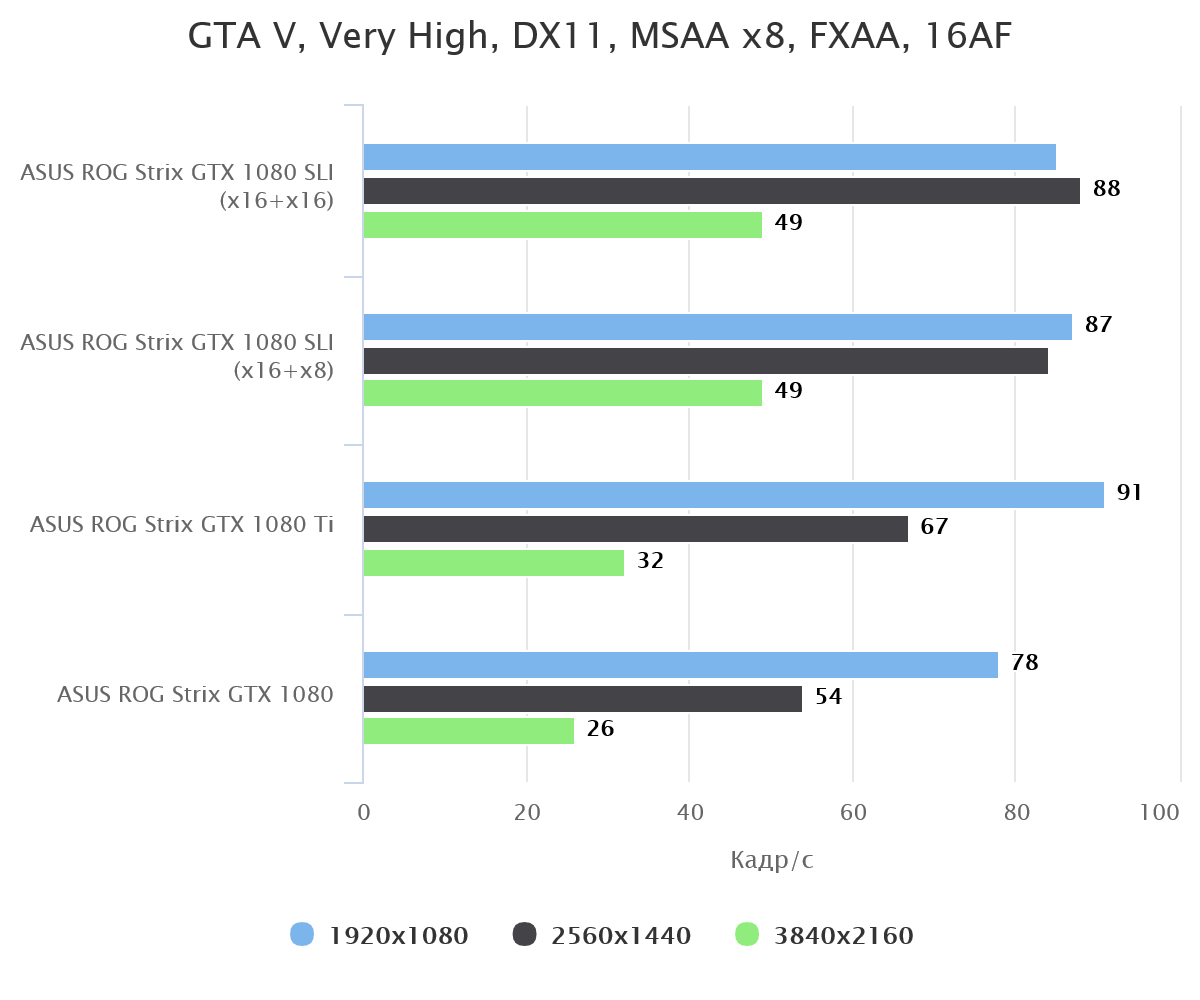

С тем фактом, что большинство игр будут неадекватно воспринимать используемую вами связку NVIDIA SLI, стоит смириться как можно раньше. Это пресловутая оптимизация, а точнее ее отсутствие. Какие-то проекты видят лишь половину графической памяти, какие-то — только одну видеокарту; некоторые отображают правильную информацию, например, GTA V, Ghost Recon Wildlands и Rainbow Six Siege.

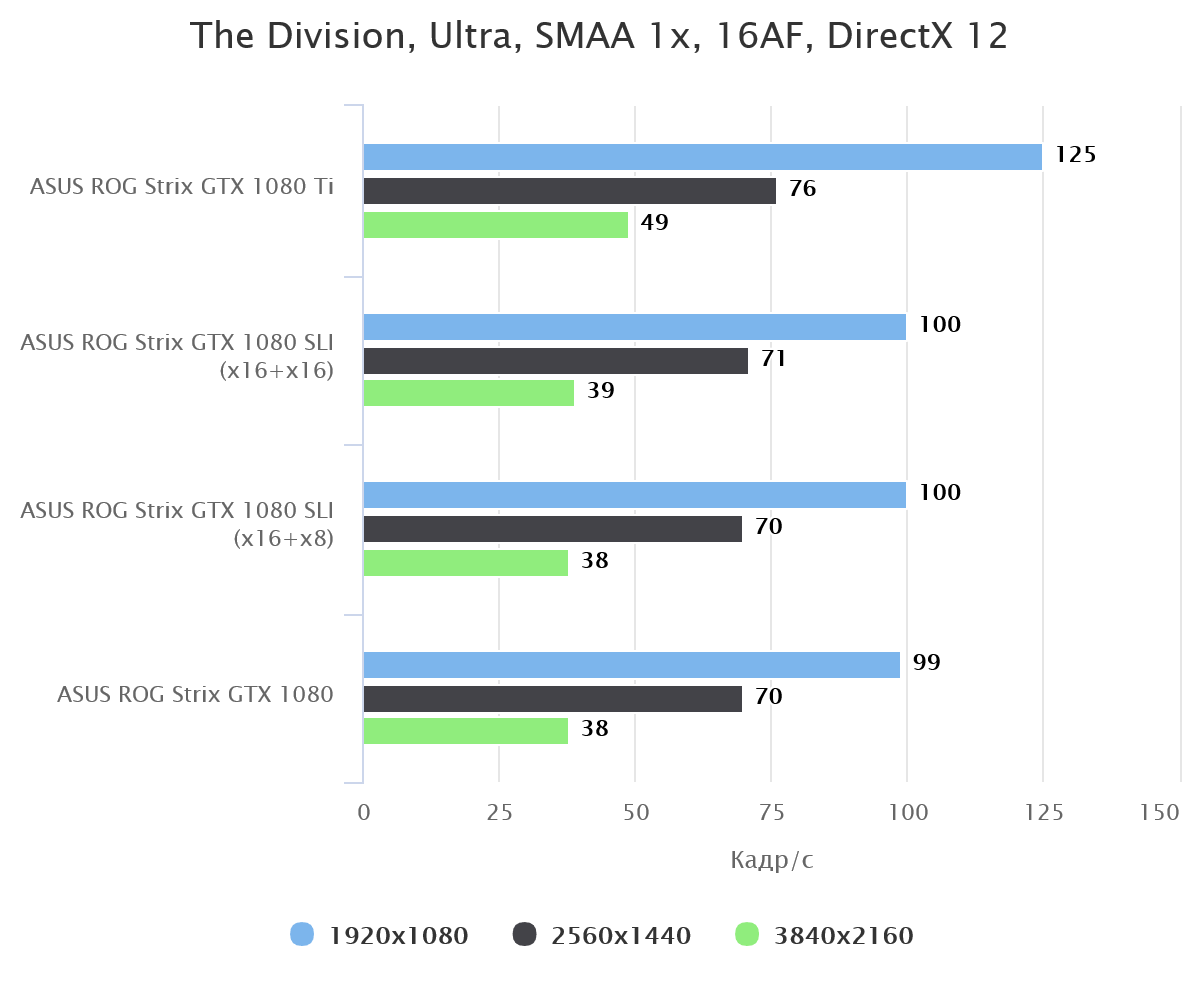

Скажем, Rise of the Tomb Raider безбожно тормозит в системе, где используется технология SLI (особенно в разрешениях 1080р и 1440р), а Warhammer 40,000: Dawn of War III и Total War: Warhammer никак не реагируют на появление в системе второй видеокарты GeForce GTX 1080 (что с одним адаптером, что с двумя, — средний кадр/с одинаковый).

NVIDIA SLI — это лотерея, в которой либо повезет, либо нет; предугадать итог заранее практически невозможно. Можно лишь поискать SLI профиль в драйверах для той или иной игры, а также покопаться в отзывах пользователей, которые уже протестировали мульти-графические связки в различных проектах.

NVIDIA SLI: х16+х16 или x16+x8?

Это один из вопросов, на который мы желали получить ответ в процессе исследования аппаратных возможностей NVIDIA SLI. Стоит ли приобретать дорогой процессор с большим количеством линий PCI-E для полного раскрытия потенциала топовых видеокарт?

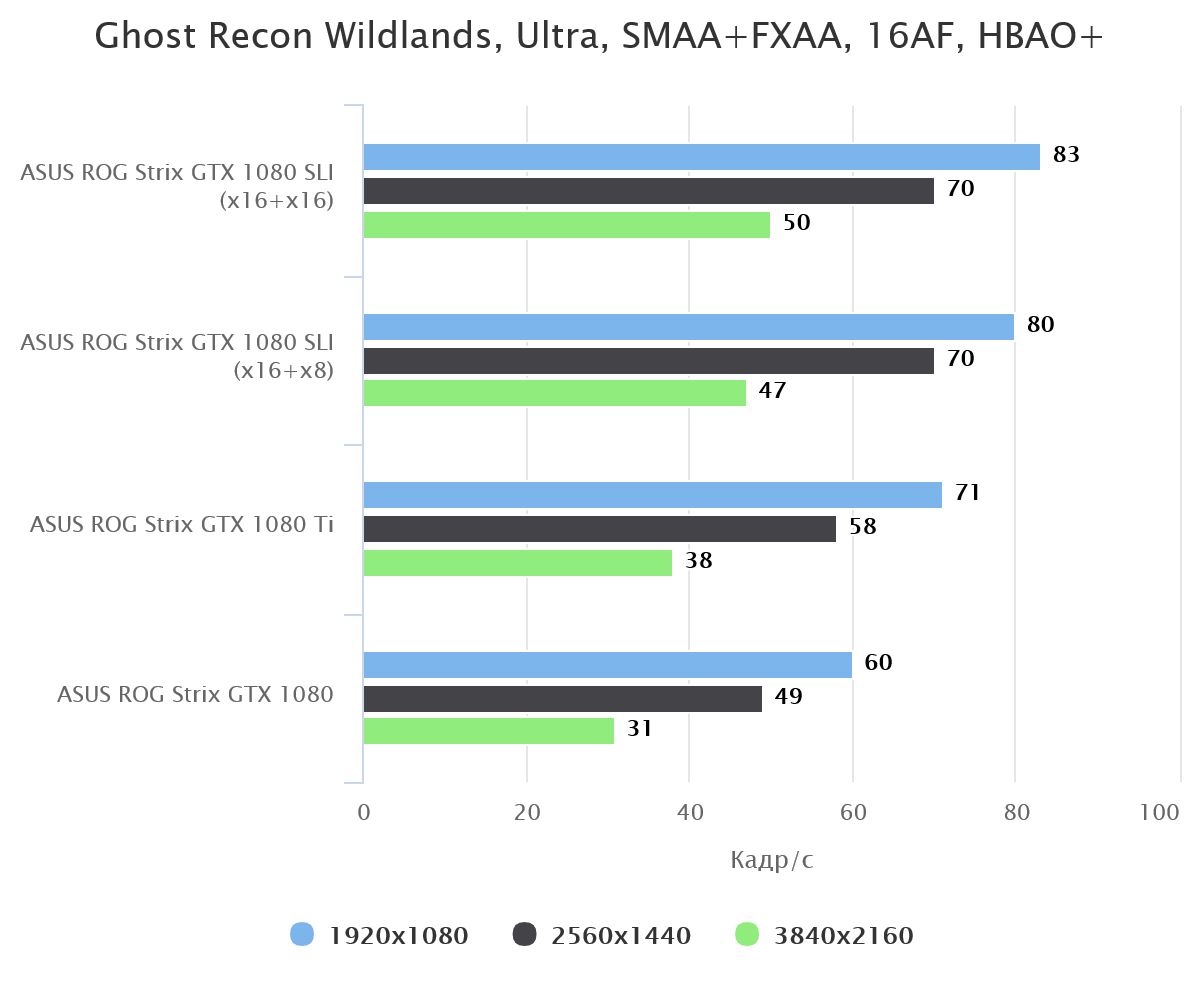

Проведенные тесты доказали, что разница между режимами х16+х16 и х16+х8 существует, однако зачастую она сводится к банальной погрешности (в некоторых играх, не оптимизированных, прироста нет вообще). Согласитесь, что 85 и 90 кадр/с — это не та пропасть, которая требует переплаты в несколько сотен долларов (мы о ЦП с поддержкой не 28, а 44 линий PCI-E)?

Даже синтетический и максимально лояльный к любым дополнительным мощностям 3DMark никак не отреагировал на дополнительную восьмерку процессорных линий PCI-E (а следовательно и большую пропускную способность интерфейса), ровно как и на более производительный ЦП.

Либо вторая видеокарта в системе есть, либо ее нет. На какой скорости она передает данные — неважно. Установлен ли в вашей системе 10-ядерный Intel Core i9-7900X или более доступный Core i7-7800X, также существенного значения не имеет (применительно к NVIDIA SLI).

Тестовый стенд:

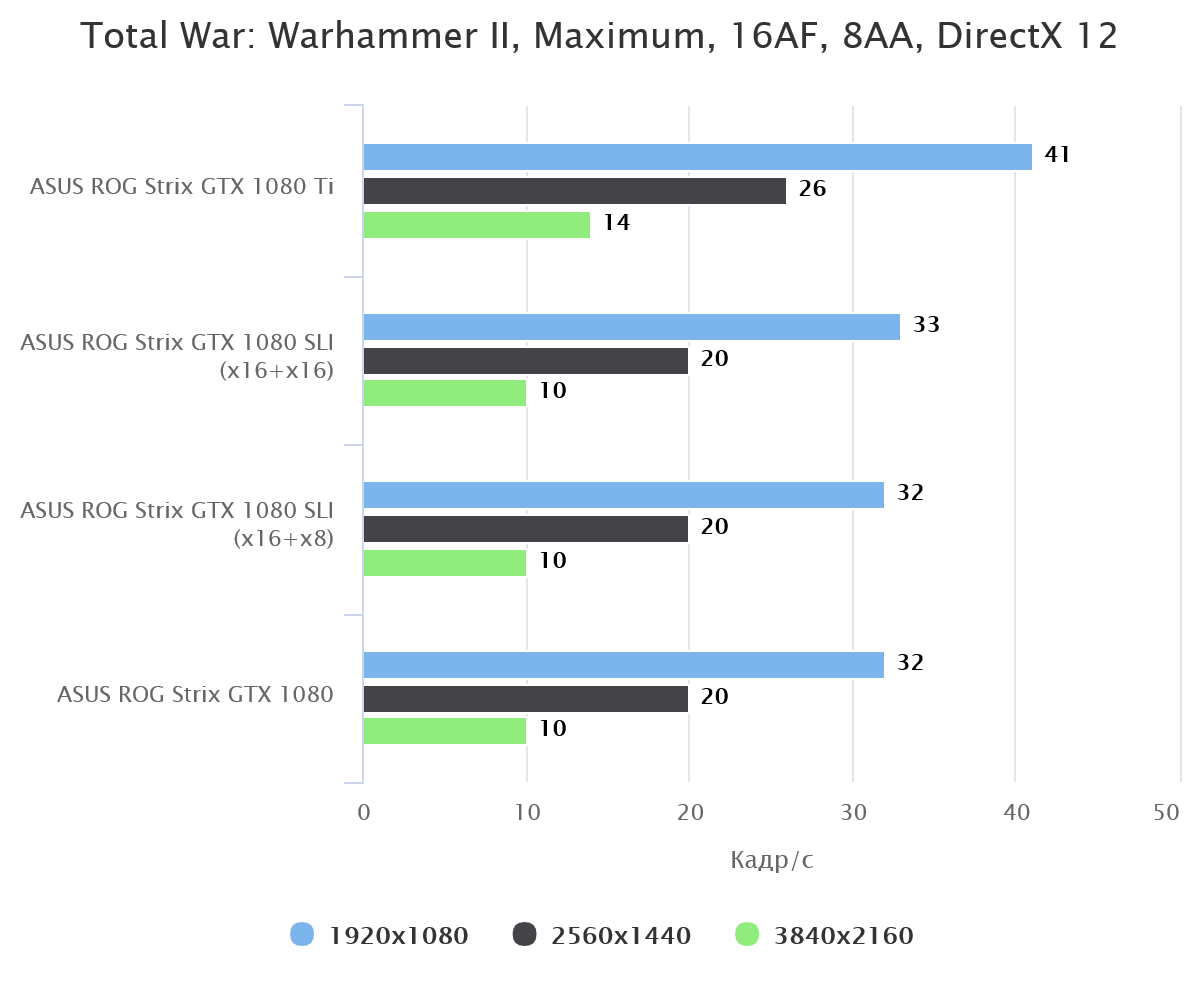

Результаты тестирования

На системе с процессором Intel Core i9-7900X мы протестировали связку SLI из двух ASUS ROG Strix GTX 1080 (в формате x16+x16), а также один ускоритель GeForce GTX 1080 и ASUS ROG Strix GTX 1080 Ti. Процессор Intel Core i7-7800X потребовался для прогона SLI в режиме x16+x8.

Важно заметить, что две видеокарты в одной упряжке не перегреваются (спасибо энергоэффективной архитектуре Pascal); вентиляторы СО вращаются довольно редко, температура каждого чипа не превышает 65-70 градусов в процессе испытаний.

Ожидать двукратного прироста от дополнительной GeForce GTX 1080 в системе не стоит, даже на полных скоростях x16+х16; хотя в некоторых хорошо оптимизированных играх (особенно в высоком разрешении, например, 4К) плюсовая разница стремится именно к такому значению (Rainbow Six Siege, GTA V и Ghost Recon Wildlands).

В большинстве случаев одна GeForce GTX 1080 Ti оказывается не хуже, чем пара GeForce GTX 1080. Вся правда отражена на тестовых графиках.

Выводы

Технология NVIDIA SLI развивается, оптимизированные профили для современных игр в драйверах GeForce также появляются, пусть и не столь стремительными темпами, как этого хотелось бы. Тандем из нескольких графических ускорителей по-прежнему остается уделом энтузиастов и любителей всего самого навороченного.

Бережливый юзер отдаст предпочтение сборке с одним мощным адаптером и 4-ядерным ЦП (а лучше двухъядерным), если ПК необходим в первую очередь для компьютерных игр. И окажется прав.

А мощные камни с поддержкой 44 линий PCI-E лучше приберечь для иных целей, уж точно не для раскрытия потенциала технологии NVIDIA SLI. Главный конек таких процессоров в наличии большого количества физических ядер, которые используются для сложных технических расчетов, а не для обработки картинки в современных играх.

стоил 16000 руб (около 500 баксов). Сейчас, даже с учетом роста курса, топовая видяха стоит 1500 долларов.

стоил 16000 руб (около 500 баксов). Сейчас, даже с учетом роста курса, топовая видяха стоит 1500 долларов.