Praat что за программа

Программное обеспечение PRAAT инструкция на русском

Вы когда-нибудь слышали о фонетике? Это раздел лингвистики, который анализирует звук человеческой речи. Анализ языка жестов также является этой частью, поэтому он имеет большое значение для тех, кто работает в этом направлении.

Теперь люди этой профессии могут выполнять свою работу дома с помощью бесплатного программного обеспечения, известного как Praat.

Как пользоваться Praat для ПК с Windows

Нечего устанавливать ненужно. Просто распакуйте файл и откройте его. Многим нравятся эти типы программ, потому что нам не нужно тратить время на установку чего-либо. Просто скачайте Praat, запускайте и используйте.

Работа со звуком

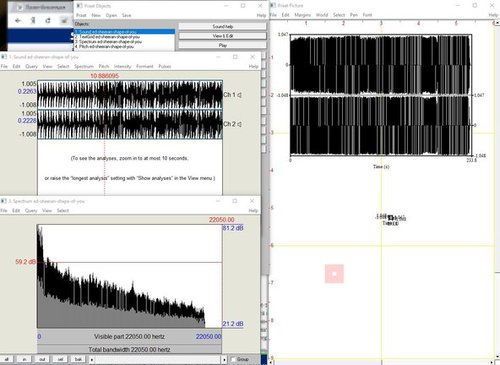

Для анализа речи мы можем использовать свою собственную, используя функцию записи. Имейте в виду, что Praat открывается с двумя окнами, одно из которых называется Praat Object и Praat Picture. Мы начнем с Praat Object.

Нажмите New, и оттуда выберите либо Record mono Sound, либо Record Stereo Sound. После того, как вы приняли решение, вы должны увидеть возможность записать свой собственный голос. Нажмите кнопку записи и запишите свою речь, наконец, нажмите «Save to list & Close».

Визуализация

Анализируя речь, мы можем создать высококачественную Визуализацию для работы. В этом случае, мы собираемся нажать на Draw, затем Draw снова, чтобы создать спектрограмму. Эта вкладка откроется автоматически появится в следующем окне.

В окне визуализации пользователь может сохранить график для дальнейшего использования. Сохранить очень просто: достаточно нажать «File», а затем выбрать один из множества вариантов «Save as…». Также есть возможность просмотра информации об изображении перед сохранением.

Margin

Что касается раздела Margins, пользователи могут многое сделать здесь. Есть возможность нарисовать внутреннее поле на изображении, добавить текст и многое другое.

В общем, если вы фонетик, то мы ожидаем, что вам понравится то, что может предложить Praat. Мы считаем, что вы поймете его особенности больше, чем мы.

Pitch-tracking, или определение частоты основного тона в речи, на примерах алгоритмов Praat, YAAPT и YIN

В сфере распознавания эмоций голос – второй по важности после лица источник эмоциональных данных. Голос можно охарактеризовать по нескольким параметрам. Высота голоса – одна из основных таких характеристик, однако в сфере акустических технологий корректнее называть этот параметр частотой основного тона.

Частота основного тона имеет непосредственное отношение к тому, что мы называем интонацией. А интонация, например, связана с эмоционально-экспрессивными характеристиками голоса.

Тем не менее, определение частоты основного тона является не совсем тривиальной задачей с интересными нюансами. В этой статье мы обсудим особенности алгоритмов для ее определения и сравним существующие решения на примерах конкретных аудиозаписей.

Введение

Для начала вспомним, чем, по сути, является частота основного тона и в каких задачах она может понадобиться. Частота основного тона, которую еще обозначают как ЧОТ, Fundamental Frequency или F0 – это частота колебания голосовых связок при произнесении тоновых звуков (voiced). При произнесении нетоновых звуков (unvoiced), например говорении шепотом или произнесении шипящих и свистящих звуков, связки не колеблются, а значит эта характеристика для них не релевантна.

* Обратите внимание, что деление на тоновые и не тоновые звуки не эквивалентно делению на гласные и согласные.

Вариабельность частоты основного тона довольно велика, причем она может сильно отличаться не только между людьми (для более низких в среднем мужских голосов частота составляет 70-200 Гц, а для женских может достигать 400 Гц), но и для одного человека, особенно в эмоциональной речи.

Определение частоты основного тона применяется для решения широкого спектра задач:

Кстати, помните историю про Laurel и Yanny? Различия в том, какие слова слышат люди при прослушивании одной и той же аудиозаписи, возникли как раз из-за разницы в восприятии F0, на которую влияют много факторов: возраст слушающего, степень усталости, устройство воспроизведения. Так, при прослушивании записи в колонках с качественным воспроизведением низких частот, вы будете слышать Laurel, а в аудиосистемах, где низкие частоты воспроизводятся плохо, Yanny. Эффект перехода можно заметить и на одном устройстве, например здесь. А в этой статье в качестве слушателя выступает нейросеть. В другой статье можно почитать, как объясняется феномен Yanny/Laurel с позиций речеобразования.

Поскольку подробный разбор всех методов определения F0 был бы чересчур объемным, статья носит обзорный характер и может помочь сориентироваться в теме.

Методы определения F0

Методы определения F0 можно разделить на три категории: основанные на временной динамике сигнала, или time-domain; основанные на частотной структуре, или frequency-domain, а также комбинированные методы. Предлагаем ознакомиться с обзорной статьей по теме, где подробно разбираются обозначенные методы выделения F0.

Отметим, что любой из обсуждаемых алгоритмов состоит из 3 основных шагов:

Препроцессинг (фильтрация сигнала, разделение его на фреймы)

Поиск возможных значений F0 (кандидатов)

Трекинг — выбор наиболее вероятной траектории F0 (поскольку для каждого момента времени мы имеем несколько конкурирующих кандидатов, нам необходимо найти среди них наиболее вероятный трек)

Очертим несколько общих моментов. Перед применением методов time-domain сигнал предварительно фильтруют, оставляя только низкие частоты. Задаются пороги – минимальная и максимальная частоты, например от 75 до 500 Гц. Определение F0 производится только для участков с гармонической речью, поскольку для пауз или шумовых звуков это не только бессмысленно, но и может внести ошибки в соседние фреймы при применении интерполяции и/или сглаживании. Длину фрейма выбирают так, чтобы в ней содержалось как минимум три периода.

Основной метод, на базе которого впоследствии появилось целое семейство алгоритмов – автокорреляционный. Подход достаточно прост — необходимо рассчитать автокорреляционную функцию и взять ее первый максимум. Он и будет отображать самую выраженную частотную компоненту в сигнале. В чем может быть сложность в случае использования автокорреляции и почему далеко не всегда первый максимум будет соответствовать нужной частоте? Даже в близких к идеальным условиям на записях высокого качества метод может ошибаться из-за сложной структуры сигнала. В условиях близких к реальным, где помимо прочего мы можем столкнуться с исчезновением нужного пика на шумных записях или записях изначально низкого качества, число ошибок резко возрастает.

Несмотря на ошибки, автокорреляционный метод довольно удобен и привлекателен своей базовой простотой и логичностью, поэтому именно он взят за основу во многих алгоритмах, в том числе в YIN (Инь). Даже само название алгоритма отсылает нас к балансу между удобством и неточностью метода автокорреляции: “The name YIN from ‘‘yin’’ and ‘‘yang’’ of oriental philosophy alludes to the interplay between autocorrelation and cancellation that it involves.” [4]

Создатели YIN попытались исправить слабые места автокорреляционного подхода. Первое изменение – использование функции Cumulative Mean Normalized Difference, которая должна снизить чувствительность к амплитудным модуляциям, сделать пики более явными:

\begin

d’_t(\tau)=

\begin

1, & \tau=0 \\

d_t(\tau) \bigg/ \bigg[ \frac<1> <\tau>\sum\limits_

\end

\end

Также YIN пытается избежать ошибок, возникающих в случаях, когда длина оконной функции не делится нацело на период колебания. Для этого используется параболическая интерполяция минимума. На последнем шаге обработки аудиосигнала выполняется функция Best Local Estimate для предотвращения резких скачков значений (хорошо это или плохо – вопрос спорный).

Если говорить о частотной области, то на первый план выходит гармоническая структура сигнала, то есть наличие спектральных пиков на частотах, кратных F0. “Свернуть” этот периодический паттерн в явный пик можно при помощи кепстрального анализа. Кепстр — преобразование Фурье от логарифма спектра мощности; кепстральный пик соответствует наиболее периодической компоненте спектра (про него можно почитать здесь и здесь).

Гибридные методы определения F0

Следующий алгоритм, на котором стоит остановиться поподробнее, имеет говорящее название YAAPT — Yet Another Algorithm of Pitch Tracking — и фактически является гибридным, потому что использует как частотную, так и временную информацию. Полное описание есть в статье, здесь мы опишем только основные этапы.

Рисунок 1. Схема алгоритма YAAPTalgo (ссылка).

YAAPT состоит из нескольких основных этапов, первым из которых является препроцессинг. На этом этапе значения изначального сигнала возводят в квадрат, получают вторую версию сигнала. Этот шаг преследует ту же цель, что и Cumulative Mean Normalized Difference Function в YIN – усиление и восстановление “затертых” пиков автокорреляции. Обе версии сигнала фильтруют — обычно берут диапазон 50-1500 Гц, иногда 50-900 Гц.

Затем по спектру преобразованного сигнала рассчитывается базовая траектория F0. Кандидаты на F0 определяются с помощью функции Spectral Harmonics Correlation (SHC).

\begin

SHC(t,f) = \sum\limits_

\end

где S(t,f) — магнитудный спектр для фрейма t и частоты f, WL — длина окна в Гц, NH — число гармоник (авторы рекомендуют использовать первые три гармоники). Также по спектральной мощности происходит определение фреймов voiced-unvoiced, после чего ищется наиболее оптимальная траектория, при этом учитывается возможность pitch doubling/pitch halving [3, Section II, C].

Далее, как для изначального сигнала, так и для преобразованного производится определение кандидатов на F0, и вместо автокорреляционной функции здесь используется Normalized Cross Correlation (NCCF).

\begin

NCCF(m) = \frac<\sum\limits_

Подробное описание алгоритма можно найти в статье 1993 года.

Как выглядит результат работы трекера (path-finder) можно посмотреть, нажав ОК и затем просмотрев (View & Edit) получившийся файл Pitch. Видно, что помимо выбранной траектории были еще довольно значимые кандидаты с частотой ниже.

Рисунок 3. PitchPath для первых 1,3 секунд аудиозаписи.

Возьмем две библиотеки, предлагающих питч-трекинг – aubio, в которой алгоритмом по умолчанию является YIN, и библиотеку AMFM_decompsition, в которой есть реализация алгоритма YAAPT. В отдельный файл (файл PraatPitch.txt) вставим значения F0 из Praat (это можно сделать вручную: выбрать звуковой файл, нажать View & Edit, выделить весь файл и выбрать в верхнем меню Pitch-Pitch listing).

Теперь сравним результаты по всем трем алгоритмам (YIN, YAAPT, Praat).

Рисунок 4. Сравнение работы алгоритмов YIN, YAAPT и Praat.

Мы видим, что при заданных по умолчанию параметрах YIN довольно сильно выбивается, получая очень плоскую траекторию с заниженными относительно Praat значениями и полностью теряя переходы между мужским и женским голосом, а также между эмоциональной и не эмоциональной речью.

YAAPT зарезал совсем высокий тон при эмоциональной женской речи, но в целом справился явно лучше. За счет каких своих особенностей YAAPT работает лучше — сразу ответить точно, конечно, нельзя, но можно предположить, что роль играет получение кандидатов из трех источников и более скрупулезный расчет их веса, чем в YIN.

Поскольку вопрос определения частоты основного тона (F0) в том или ином виде встает почти перед каждым, кто работает со звуком, путей для его решения достаточно много. Вопрос необходимой точности и особенности аудиоматериала в каждом конкретном случае определяют, насколько внимательно необходимо подбирать параметры, или в ином случае можно ограничиться базовым решения наподобие YAAPT. Принимая Praat за эталон алгоритма для обработки речи (все же им пользуется огромное количество исследователей), можно сделать вывод о том, что YAAPT в первом приближении надежнее и точнее, чем YIN, хотя и для него наш пример оказался сложноват.

Автор: Ева Казимирова, научный сотрудник Neurodata Lab, специалист по обработке речи.

Программа для анализа речи в фонетике. Поддерживает синтез речи, в том числе артикуляционный синтез.

Свободный программный комплекс для анализа речи в фонетике, который был разрабатывается Паулем Бурсмой и Дэвидом Уининком из Амстердамского университета. Он может работать на широком спектре операционных систем, включая различные версии Unix, Linux, Mac и Microsoft Windows (2000, XP, Vista, 7, 8, 10). Программа поддерживает синтез речи, в том числе артикуляционный синтез.

Praat предлагает широкий набор опций, особенно для редактирования на основе скриптов, при этом собственные скрипты можно легко интегрировать в графический интерфейс. Возможно создание экспериментов и получение результатов также, как и векторное графическое представление результатов. Недостатки Praat включают в себя то, что только один файл может быть прочитан единовременно, длинные звуковые файлы ограничены в редактировании.

Анализ речи:

Синтез речи:

Прослушивание экспериментов:

Маркировка и сегментация:

Речевые манипуляции:

Алгоритм обучения:

Статистика:

Графика:

Программируемость:

Портативность:

Praat предназначен для тех, кто хочет анализировать, синтезировать и манипулировать речью. Кроме того, с помощью этого инструмента можно создавать высококачественные изображения, которые возможно экспортировать и вставлять в научные статьи или личные исследования.

Приложение состоит из двух основных окон, одно из которых позволяет управлять самим проектом, а в другом размещается изображение, которое создается после обработки звука.

Praat позволяет выполнять спектральный анализ, анализ высоты тона, форманта и интенсивности, а также изучать дрожание, мерцание и голосовые разрывы. Praat предназначен для тех, кто по крайней мере знаком с тем, как выглядит звуковая волна и как её можно обрабатывать. Если это не так, приложение предоставляет богатую и сложную документацию, которую можно изучить.

Спектрограмма, связанная с загруженным аудиофайлом, отображается в редакторе, и именно оттуда можно получить доступ к инструментам, необходимым для выполнения вышеупомянутых типов анализа. Хотя дизайн интерфейса является рудиментарным, Praat выигрывает в том, что он ориентирован на цель. Это означает, что функция не должна выглядеть хорошо, но функционировать должным образом и давать точные результаты.

Поскольку Praat работает исключительно с аудиофайлами, вполне уместно, что он предлагает средства для преобразования файлов в различные форматы или улучшение определенных характеристик, которые они имеют. С его помощью можно экспортировать загруженный аудиофайл в формат WAV, AIFF, AIFC, NIST или FLAC, а также в необработанный 16, 24 или 32-разрядный файл raw endian.

Кроме того, трек можно конвертировать в моно или стерео, извлекать все его каналы или один и перепроверять его с другой частотой.