какие законы для социальных роботов предложил айзек азимов укажите хотя бы 2 закона

Три закона робототехники Айзека Азимова

Современные робототехники признают, что законы Азимова хороши для рассказов, но бесполезны на практике и вряд ли будут реализованы в роботах. Исследователи в области искусственного интеллекта рассматривают законы, как идеал. Нужно быть гением, чтобы применить их на практике, потребуются исследования в области ИИ, чтобы роботы поняли законы робототехники Айзека Азимова на английском.

Кто сформулировал три закона робототехники

3 закона робототехники (англ. Three Laws of Robotics) впервые сформулировал писатель-фантаст Айзек Азимов в своих произведениях прошлого века. Законы робототехники — это свод обязательных правил, которые должен выполнять робот или искусственный интеллект, чтобы не причинить вред своему создателю. Три закона робототехники Азимова используются сегодня только в научной фантастике.

До Азимова проблема восстания искусственного интеллекта была одной из самой популярной в научной фантастике 1920—1930 годов. Азимов часто обсуждал свои рассказы с другом и главным редактором журнала «Astounding» Джоном Кэмпбеллом. За обсуждением очередного фантастического рассказа писателя, Кэмпбелл сформулировал те три правила, которые мы называем законами робототехники.

Как звучат законы робототехники Айзека Азимова

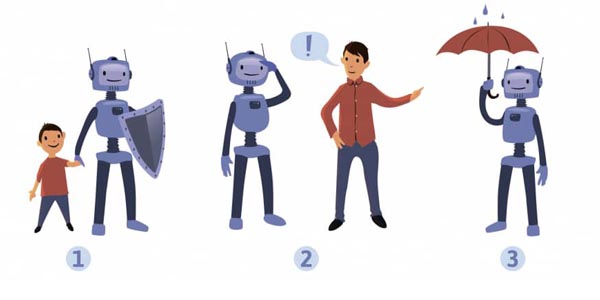

1 закон робототехники: Робот не может причинить вред человеку или своим бездействием допустить, чтобы человеку был причинён вред.

2 закон робототехники: Робот должен повиноваться всем приказам, которые даёт человек, кроме случаев, когда приказы противоречат Первому Закону.

3 закон робототехники: Робот должен заботиться о своей безопасности в той мере, в которой это не противоречит Первому или Второму Законам.

Нулевой закон робототехники Азимова

Первые упоминания законов, можно встретить в произведениях «Робби» и «Логика» Азимова. Точная формулировка первого закона робототехники звучит впервые в рассказе «Лжец» а все три закона полностью сформулированы в рассказе «Хоровод» 1942 года. Как следствие всех трех законов робототехники, Айзек Азимов формулирует четвертый закон робототехники (нулевой), ставя его на первое место.

4 закон робототехники: Робот не может нанести вред человечеству или своим бездействием допустить, чтобы человечеству был нанесён вред.

По задумке Азимова, три закона робототехники заложены в основу математической модели позитронного мозга (так фантаст называл мозг робота с искусственным интеллектом), таким образом, создать думающего робота без этих трех законов невозможно. Если робот попытается нарушить законы, то он выйдет из строя. Поэтому в рассказах Азимова прослеживалось, что роботы имеют ограничения и правила.

3 закона робототехники Айзека Азимова

В произведениях, писатель придумывает способы того, как обойти три закона робототехники, разбирает возможные причины и следствия нарушения законов. Автор размышляет, как роботы по-разному понимают законы и к каким последствиям могут привести их не соблюдение. Азимов признавался, что сделал законы двусмысленными намеренно, чтобы обеспечить больше конфликтов для своих новых рассказов.

В произведениях Азимова роботы часто имели модифицированные законы или сами модифицировали три закона робототехники. Делали они это логическими размышлениями, но это исключение из правил, чаще всего законы нарушались из-за сбоев у робота или переписывались людьми в своих целях. Сама возможность изменения законов менялась по ходу развития робототехники во рассказах Азимова.

Смогут ли «три закона робототехники» защитить нас?

Прошло 50 лет с тех пор, как Айзек Азимов придумал свои знаменитые три закона робототехники — набор правил, которым должен следовать любой уважающий себя робот. Хотя изначально это был всего-лишь литературный прием, три закона стали оригинальным рецептом по избежанию «роботокалипсиса». К счастью, есть эксперты, которые изучают наверняка, выдержали ли гарантии Азимова проверку временем. К несчастью, все они говорят: нет.

Для начала напомним эти самые три закона:

Позднее Азимов добавил четвертый, или нулевой, закон, который предшествовал остальным с точки зрения приоритета:

0. Робот не может причинить вреда человеку, если только он не докажет, что в конечном счёте это будет полезно для всего человечества.

Как показал сам Азимов, несовершенство, лазейки и неясности в этих законах зачастую приводили к странному и нелогичному поведению роботов. Законы были слишком расплывчатыми и зачастую не могли определить и отличить «людей» от «роботов». Кроме того, роботы могли неосознанно нарушать законы, если полная информация была им недоступна. Также чересчур хитроумный робот или искусственный интеллект должен был находиться под давлением, чтобы не перепрограммировать свое ядро.

На дворе 2014 год, и многое обыденное из нашей жизни фантастам прошлого века могло показаться откровенной фантастикой. Многие люди посчитали, что законы Азимова должны были остаться в качестве литературного приема. Но сам Азимов в 1981 году отметил, что его законы могли бы работать. В статье журнала Compute! он указал следующее:

«Когда кто-то спрашивает меня, что было бы, если бы три моих закона робототехники на самом деле использовались для определения поведения роботов, ответ уже готов. Разумеется, при условии, что роботы будут достаточно гибкими и универсальными, чтобы обладать разным поведением. Я отвечаю: да, три закона — это единственный вариант, по которому люди могут взаимодействовать с роботами — или с чем-нибудь еще.

Спустя почти тридцать лет мы приблизились к реальности, в которой у нас будут роботы — или, если точнее, искусственный интеллект, который ими управляет — достаточно гибкие и универсальные для разных курсов поведения. Остается лишь вопрос времени: когда машина превзойдет человека во всех отношениях, начиная физической силой и заканчивая силой воображения.

Пугает то, что права на ошибку практически нет. Если искусственный сверхинтеллект будет плохо запрограммирован или безразличен к людям, это приведет к катастрофе. Мы должны убедиться в безопасности искусственного интеллекта, если хотим пережить его появление».

Ответить на вопрос «могут ли три закона Азимова помочь?» взялись два теоретика искусственного интеллекта: Бен Герцель (Aidyia Holdings) и Луи Хельм, замдиректора Института исследований машинного интеллекта (MIRI), а также исполнительный редактор журнала Rockstar Research. После разговора с ними стало ясно, что законы Азимова вообще никак не могут справиться с возложенной на них задачей, и если нам нужно создать безопасный ИИ, придется разрабатывать нечто совершенно иное.

Азимовское будущее?

«Думаю, что тип роботов, которых предвидел Азимов, станет возможным в недалеком будущем, — отвечает Герцель. — Тем не менее, в большинстве своих вымышленных миров, писатель предполагал, что человекоподобные роботы будут вершиной робототехники и инженерии искусственного интеллекта. Это вряд ли. Очень скоро, после достижения статуса азимовских роботов, станет доступным и создание искусственного сверхинтеллекта и сверхроботов».

Таким образом, типичный мир будущего в рассказах про роботов у Азимова, по мнению Герцеля, будет похож на тот, в котором мы живем сегодня, но с разумными роботами, гуляющими по улицам.

«Вряд ли это произойдет, а если и произойдет, то задержится ненадолго».

Для Хельма роботы представляются совершенно другими.

«Основным вопросом, который, на мой взгляд, будет самым важным для человечества, остается не моральное регулирование гигантского количества наполовину разумных гуманоидов, а в конечном итоге развитие передовых форм искусственного интеллекта (в любом теле). Это развитие сверхинтеллекта — фильтр, через который должно пройти человечество в конце концов. Именно поэтому разработка стратегии безопасности для этого перехода столь важна. Мне видится совершенно странным то, что роботы, андроиды или «эмуляции» будут существовать десять лет или чуть более до тех пор, пока человечество столкнется с настоящей проблемой разработки машинной этики для сверхинтеллекта».

Хорошее начало?

«Честно говоря, я не нахожу никакого вдохновения в этих трех законах робототехники, — говорит Хельм. — Суть машинной этики в том, что они не удовлетворяют базису машинной этики. Возможно, три закона робототехники широко известны, но на самом деле использовать их в качестве основы для программирования бесполезно».

«По некоторым причинам система добропорядочной этики — так называемая деонтология — стала ненадежной основой для этики. Есть ряд философов, которые пытаются исправить проблемы деонтологии, но они по большей части остаются теми же людьми, что ищут «разумный замысел» и «божественное вмешательство». Никто не воспринимает их всерьез».

Недостатки трех законов робототехники Азимова сводятся к следующим:

«Задачей трех законов было нарушить их интересным способом; вот почему рассказы с их участием особенно занимательны. Поэтому три закона могут остаться лишь нравоучительным примером того, как делать не надо. Если взять их за основу, в них неизбежно найдутся лазейки».

Герцель считает, что в реальности эти законы работать не будут, поскольку термины с их участием неоднозначны и остаются предметом толкования — а значит, крайне зависимы от тех, кто делает переводы.

Предубеждение против роботов?

Другой аспект (и потенциальный недостаток) трех законов в очевидном шовинизме —предположение о том, что роботы должны оставаться, несмотря на их превосходящую мощь, в подчинении у человека, человеческих потребностей и приоритетов.

«Общество будущего у Азимова состоит сплошь из шовинистов: у людей прав гораздо больше, чем у роботов. Три закона робототехники были созданы, чтобы поддерживать именно такой общественный порядок».

«Я думаю, было бы неразумно проектировать систему искусственного интеллекта или робота с самосознанием. И в отличие от фильмов или книг, в которых создатели искусственного интеллекта «случайно» приходят к разумным машинам, я не верю, что в реальном жизни это может случиться. Для этого понадобится слишком много усилий и знаний. И большинство разработчиков ИИ — этически подкованные люди, поэтому они будут избегать создания того, что философы называют «морально значимыми существами». Особенно когда они с легкостью могут создать продвинутую машину, которая не будет обладать этическими задатками».

Хельм не обеспокоен необходимостью разработки асимметричных законов, регулирующих значимость роботов по сравнению с людьми, утверждая (и надеясь), что будущие создатели искусственного интеллекта будут опираться на некоторые этические ограничения.

«Я как бы думаю, что люди сделаны из атомов, поэтому в теории инженер может создать синтетическую форму жизни или робота с моральным значением. Я хотел бы думать, что никто этого не сделает. Думаю, большинство людей тоже. Но неизбежно появится некий дурак, жаждущий известности первопроходца, даже если это неэтично и глупо».

Три закона робототехники 2.0?

Учитывая очевидные недостаки трех законов робототехники Азимова, ресурс io9 задался вопросом: можно ли их исправить или внести доработки? На самом деле, многие писатели-фантасты многократно пытались сделать это, внося поправки в течение многих лет.

«Нет, — считает Хельм. — Нет никаких «патчей» для трех законов».

Помимо своей противоречивой природы, законы еще и состязательны по своей природе.

«Я сторонник подходов машинной этики, которая более кооперативна, более последовательна и опирается на нормативы, а значит может оправиться от недоразумений или исправить неправильное программирование».

Герцель эхом вторит утверждениям Хельма.

«Определение набора этических заповедей в качестве ядра машинной этики будет безнадежным, если в основе машины будет гибкий общий искусственный интеллект. Если он будет задуман как интуитивный, гибкий, адаптивный или этический — в этом контексте этические заповеди будут полезны для системы только как грубый ориентир для применения собственной этической интуиции. Но в этом случае заповеди не станут основой этической системы, а только лишь аспектом. Это можно рассмотреть на примере людей — этические принципы, которые мы изучаем, работают, но не в качестве руководящих принципов, они лишь подталкивают нашу интуицию и этические инстинкты. Мы практически независимы от этических принципов».

Как создать безопасный искусственный интеллект?

Учитывая неадекватность правового подхода, можно поинтересоваться у Герцеля и Хельма по поводу современных подходов к проблеме «безопасного ИИ».

«Очень немногие исследователи общего искусственного интеллекта полагают, что есть возможность создать систему, которая будет полностью безопасной, — говорит Герцель. — Но это не беспокоит большинство, поскольку в этой жизни вообще нельзя ничего гарантировать».

Герцель считает, что как только мы создадим систему общего искусственного интеллекта или ее зародыш, мы сможем провести исследования и эксперименты, которые расскажут нам об этике ИИ куда больше, чем мы знаем.

«Надеюсь, таким образом мы сможем сформулировать хорошие теории по этике искусственного интеллекта, которые позволят нам углубиться в эту тему. Но сейчас теоретизировать об этике ИИ довольно трудно, поскольку у нас нет не просто хороших теорий, у нас вообще никаких теорий нет».

«А людям, которые смотрели слишком много «терминаторов», процесс создания искусственного интеллекта может показаться пугающим, поскольку они упускают слово «примитивный» в этом контексте. Тем не менее, самые радикальные изменения случались именно таким образом».

«Когда группа умных пещерных людей изобрела язык, они не ждали разработки прочной формальной теории языка, которая могла бы помочь спрогнозировать будущие изменения, вызванные появлением языка в обществе».

Прежде чем считать разработку очередных «трех законов» технической проблемой, нужно провести массу исследований. И в этом Хельм и Герцель сходятся.

«Мой коллега из MIRI Люк Мюельхаузер подвел итоги наших рассуждений следующим образом. Он сказал, что проблемы часто переходят из области философии в математику, а затем в инженерию. Философия зачастую задается правильными вопросами, но самым непрактичным образом. Никто не может наверняка сказать, есть ли какой-либо прогресс в разрешении вопроса. Если мы сможем переформулировать важные философские проблемы, связанные с разумом, идентификацией и ценностью в точные формулы, с которыми сможет справиться математика, тогда можно будет построить кое-какую модель. В один прекрасный день дойдет и до инженерии».

Хельм считает эту проблему сложной для науки и философии, но прогресс возможен.

«Я скептически отношусь к тому, что философия сможет решить вопрос, над которым бьется более 3000 лет. Но мы тоже не можем взять и начать составлять математические модели вопросов, которых нет технически. Нужно еще много теоретических и даже практических наработок».

Три закона робототехники Азимова: насколько они актуальны сейчас?

Многие авторы научной фантастики считают, что однажды «разумные» роботы могут физически и умственно превзойти человека. Они также часто задаются вопросом, что произойдет, если эти роботы просто решат, что люди им не нужны. Чтобы облегчить эту проблему, в прошлом столетии Айзек Азимов предложил ее решение в виде определенных законов. Какие три закона робототехники придумал великий писатель, узнайте в нашей статье.

Краткая история о человеке, который создал законы

Айзек Азимов родился 2 января 1920 года в России. Он был американским писателем, специализирующимся на жанре научной фантастики. Азимов — это признанный во всем мире писатель-фантаст, один из трех великих мастеров в этой сфере. Являясь профессором биохимии в Бостонском университете, Исаак Азимов имел более 500 опубликованных томов в дополнение к 90 000 писем, открыток и других научных книг.

Он был сыном Иуды и Анны Азимовых, которые иммигрировали в Соединенные Штаты, когда Исааку было три года. В детстве Айзек исследовал все библиотеки в пределах своей досягаемости, его можно было смело назвать «книжным червем». Азимов окончил Колумбийский университет в 1939 году со степенью по химии, а затем получил докторскую степень в том же университете в 1948 году. Позднее он принял предложение вести лекции в Бостонском университете, где стал доцентом биохимии в 1955 году.

Литературная карьера Азимова началась, когда начали публиковаться его работы в научно-фантастических журналах в 1939 году. «Ночная осень», написанная в 1941 году, оказалась лестницей к литературному успеху. История основана на планете, где ночь появляется только один раз в каждые 2049 лет. До сих пор она считается лучшим научно-фантастическим рассказом. Его первая книга «Галька в небесах» была опубликована в 1950 году. Самым известным сборником романов является трилогия «Фонд. Фонд и империя. Второй фонд» (1951-1953). Эта космическая трилогия повествует о футуристической галактической империи. «Я, Робот» (1950), который также сняли в 2004 году, является еще одной блестящей работой Азимова, которая фокусируется на разработке правил и этики для искусственно-интеллектуальных машин. Некоторые другие известные художественные произведения Исаака Азимова: «Звезды», такие как «Пыль» (1951), «Потоки космоса» (1952), «Стальные пещеры» (1954), «Обнаженное солнце» (1957), «Достаточно места для комнаты» (1957) и т.д.

Азимов также был автором многих нехудожественных произведений, первым из которых было «Химия жизни» (1954). Некоторые другие его научные труды включают «Внутри атома» (1956), «Мир азота» (1958), «Жизнь и энергия» (1962), «Мозг человека» (1964), «Нейтрино» (1966), «Наука, числа и я» ( 1968), «Наш мир в космосе» (1974) и «Виды Вселенной» (1981). Кроме того, в дополнение к написанию двух автобиографий Азимов также опубликовал ежеквартальный научно-фантастический журнал Исаака Азимова, который был основан журналами Дэвиса. Вклад Исаака Азимова в научную литературу был отмечен такими почетными наградами, как Гюго, Туманность и другими.

Азимов был женат дважды. Его первая жена, на которой он женился в 1942 году, Гертруда Блугерман родила ему двоих детей. Они расстались в 1970 году, развелись в 1973 году. В том же году он сошелся с Джанет Опал Джеппсон, писателем и психоаналитиком. Азимов скончался 6 апреля 1992 года в Нью-Йорке из-за почечной недостаточности. Однако через десять лет после смерти его жена Джанет рассказала, что у него был СПИД. ВИЧ-инфекцией он случайно заразился во время операции шунтирования.

Какие законы робототехники предложил Азимов?

«Три закона робототехники» дебютировали в истории Исаака Азимова под названием «Обход», впервые опубликованной в мартовском выпуске журнала «Потрясающая научная фантастика» 1942 года под редакцией Джона В. Кэмпбелла.

Сейчас мы детально рассмотрим 3 закона робототехники Азимова, а также расскажем, что о них думают некоторые из современных ученых.

1 закон: робот не может ранить человека или причинять вред человеку своим бездействием.

Когда мы рассматриваем угрозу человечеству, на что ссылается первый закон робототехники Исаака Азимова, наши мысли быстро перерастают из несчастных случаев на производстве в совершенно преднамеренные сценарии сражений. Применим ли такой закон?

Многие современные роботы способны принимать элементарные решения о безопасности. Датчики движения, мягкая прокладка, устранение «точки защемления» в механике, камеры, протоколы предотвращения столкновений и новые сферы поведенческого программирования открывают перспективы для роботов, способных взаимодействовать с людьми.

2 закон: робот должен подчиняться приказам, данным ему людьми, за исключением случаев, когда такие приказы вступают в противоречие с Первым законом.

В 1950 году пионер вычислительной техники Алан Тьюринг предположил, что если у вас разговор с машинным интеллектом, и вы не можете определить разницу между его реакцией и тем, что вы ожидаете от человека, то машина, вероятно, так же реагирует, как и вы. В июне 2014 года Школа системотехники Университета Рединга организовала тест Тьюринга в Королевском обществе в Лондоне. Владимир Веселов был частью команды, которая разработала «Евгения Густмана», сверхъестественную пародию на 13-летнего украинского мальчика из Одессы. Он одурачил 11 из 30 судей, по крайней мере, на короткое время, необходимое для проведения теста.

Веселов не питает иллюзий по поводу состояния игры. «Мы не можем говорить об историческом шаге в развитии искусственного интеллекта», — предупреждает он. «Этот робот как литературное и психологическое творение, которое прошло испытание». Дело в том, что роботам не нужно проходить тест Тьюринга. Они уже становятся «достаточно хорошими» в мимике, чтобы заменить людей в широком спектре задач.

Если текущие тенденции еще не преодолены, вторжение компьютеров, роботов и «экспертных систем» на рабочее место ставит Второй закон в противоречие с Первым. Роботы очень хорошо выполняют приказы, которые они отдают, и можно утверждать, что это «наносит вред» людям. Причиняет ущерб не физическая травма, а экономическая составляющая.

В 1933 году экономист Джон Мейнард Кейнс предсказал, что технологии, призванные захватить нашу работу, «опережают темпы, с которыми мы можем найти новые способы использования человеческого труда». Ровно через 80 лет междисциплинарная группа в Оксфордском университете подготовила доклад под названием «Будущее занятости: насколько восприимчивы рабочие места к компьютеризации?». Было сделано поразительное заключение, что 47% всех рабочих мест в Америке находятся под угрозой.

3 закон: робот должен защищать свое существование, если такая защита не противоречит Первому или Второму законам.

Может ли робот защитить свое существование, если он не знает, что он существует? Машины могут казаться людьми и даже способны к очевидным социальным взаимодействиям, но могут ли они когда-нибудь стать самосознательными?

Робин Мерфи и Дэвид Вудс, авторы книги «Помимо Азимова», удивлены тем, как мало внимания уделяется самосохранению робота. «Поскольку роботы стоят дорого, можно предположить, что у дизайнеров будет мотивация включить какую-либо форму Третьего закона в свои продукты», — говорят они. «У многих коммерческих роботов нет средств для защиты инвестиций их владельцев». Любое применение Третьего закона в современных условиях будет направлено на защиту людей от финансового и физического ущерба.

Противоречия в 3 законах робототехники

Частично противоречия в законах мы рассмотрели в предыдущем пункте. А теперь поговорим о них детальнее.

Законы Азимова становятся более шаткими при рассмотрении вопроса о разработке управляемых человеком военных беспилотников, предназначенных для убийства других людей издалека. Как это ни парадоксально, если контролирующий человек направляет робота, чтобы спасти жизни своих сограждан, убивая нападающих на них людей, можно сказать, что он следует как первому закону Азимова, так и нарушает его.

Кроме того, если беспилотник направлен человеком, можно утверждать, что это вина человека в гибели людей в боевых ситуациях, а не беспилотника. Действительно, армии, оснащенные беспилотниками, значительно уменьшат количество человеческих жертв в целом. Возможно, лучше использовать роботов, а не людей в качестве пушечного мяса.

На другом конце шкалы законы Азимова подходят, если обеспечение безопасности пожилого человека является основной целью робота. Но часто робототехника вписывается в ряд «вспомогательных» технологий, которые помогают пожилым людям обрести независимость. Это означает, что они могут принимать собственные решения, в том числе те, которые могут привести к причинению вреда себе, например, в результате падения. Робот, позволяющий своему человеку принимать независимые решения, которые привели к травме в результате падения, нарушал бы Первый Закон из-за бездействия.

Однако Сорелл утверждает, что человеческая автономия должна соблюдаться как другими животными, так и роботами. Необходимо также уважать пожилых людей, которые делают выбор, гарантирующий их дальнейшую независимую жизнь, но могут подвергнуть их риску получения травмы.

Новые законы робототехники

Ученый-компьютерщик Робин Мерфи из Техасского университета A&M и Дэвид Вудс, профессор когнитивных систем в Университете штата Огайо, пересмотрели три закона Азимова, пытаясь исправить неясности в выражениях. Их статья «За Азимовым» предлагает новые законы:

Исаак Азимов — один из самых знаменитых писателей-фантастов, и, пожалуй, его самое известное творение — «Три закона робототехники». Хотя законы Азимова влияли на разработчиков робототехники на протяжении десятилетий, сейчас настало время пересмотреть их эффективность и начать обсуждение нового набора законов, которые хорошо сочетаются с непрекращающимися, внушающими страх прорывами в робототехнике и технологии искусственного интеллекта во всем мире.