какие значения принимает ковариация

Корреляция, ковариация и девиация (часть 3)

В первой части показано, как на основе матрицы расстояний между элементами получить матрицу Грина. Ее спектр образует собственную систему координат множества, центром которой является центроид набора. Во второй рассмотрены спектры простых геометрических наборов.

В данной статье покажем, что матрица Грина и матрица корреляции — суть одно и то же.

7. Векторизация и нормирование одномерных координат

Пусть значения некой характеристики элементов заданы рядом чисел . Для того, чтобы данный набор можно было сравнивать с другими характеристиками, необходимо его векторизовать и обезразмерить (нормировать).

Для векторизации находим центр (среднее) значений

и строим новый набор как разность между исходными числами и их центроидом (средним):

Получили вектор. Основной признак векторов состоит в том, что сумма их координат равна нулю. Далее нормируем вектор, — приведем сумму квадратов его координат к 1. Для выполнения данной операции нам нужно вычислить эту сумму (точнее среднее):

Теперь можно построить ССК исходного набора как совокупность собственного числа S и нормированных координат вектора:

Квадраты расстояний между точками исходного набора определяются как разности квадратов компонент собственного вектора, умноженные на собственное число. Обратим внимание на то, что собственное число S оказалось равно дисперсии исходного набора (7.3).

Итак, для любого набора чисел можно определить собственную систему координат, то есть выделить значение собственного числа (она же дисперсия) и рассчитать координаты собственного вектора путем векторизации и нормирования исходного набора чисел. Круто.

Упражнение для тех, кто любит «щупать руками». Построить ССК для набора <1, 2, 3, 4>.

8. Векторизация и ортонормирование многомерных координат

Что, если вместо набора чисел нам задан набор векторов — пар, троек и прочих размерностей чисел. То есть точка (узел) задается не одной координатой, а несколькими. Как в этом случае построить ССК? Стандартный путь следующий.

Введем обозначение характеристик (компонент) набора. Нам заданы точки (элементы) и каждой точке соответствует числовое значение характеристики

. Обращаем внимание, что второй индекс

— это номер характеристики (столбцы матрицы), а первый индекс

— номер точки (элемента) набора (строки матрицы).

Далее векторизуем характеристики. То есть для каждой находим центроид (среднее значение) и вычитаем его из значения характеристики:

Получили матрицу координат векторов (МКВ) .

Следующим шагом как будто бы надо вычислить дисперсию для каждой характеристики и их нормировать. Но хотя таким образом мы действительно получим нормированные векторы, нам-то нужно, чтобы эти векторы были независимыми, то есть ортонормированными. Операция нормирования не поворачивает вектора (а лишь меняет их длину), а нам нужно развернуть векторы перпендикулярно друг другу. Как это сделать?

Правильный (но пока бесполезный) ответ — рассчитать собственные вектора и числа (спектр). Бесполезный потому, что мы не построили матрицу, для которой можно считать спектр. Наша матрица координат векторов (МКВ) не является квадратной — для нее собственные числа не рассчитаешь. Соответственно, надо на основе МКВ построить некую квадратную матрицу. Это можно сделать умножением МКВ на саму себя (возвести в квадрат).

Но тут — внимание! Неквадратную матрицу можно возвести в квадрат двумя способами — умножением исходной на транспонированную. И наоборот — умножением транспонированной на исходную. Размерность и смысл двух полученных матриц — разный.

Умножая МКВ на транспонированную, мы получаем матрицу корреляции:

Из данного определения (есть и другие) следует, что элементы матрицы корреляции являются скалярными произведениями векторов (грамиан на векторах). Значения главной диагонали отражают квадрат длины данных векторов. Значения матрицы не нормированы (обычно их нормируют, но для наших целей этого не нужно). Размерность матрицы корреляции совпадает с количеством исходных точек (векторов).

Теперь переставим перемножаемые в (8.1) матрицы местами и получим матрицу ковариации (опять же опускаем множитель 1/(1-n), которым обычно нормируют значения ковариации):

Здесь результат выражен в характеристиках. Соответственно, размерность матрицы ковариации равна количеству исходных характеристик (компонент). Для двух характеристик матрица ковариации имеет размерность 2×2, для трех — 3×3 и т.д.

Почему важна размерность матриц корреляции и ковариации? Фишка в том, что поскольку матрицы корреляции и ковариации происходят из произведения одного и того же набора векторов, то они имеют один и тот же набор собственных чисел, один и тот же ранг (количество независимых размерностей) матрицы. Как правило, количество векторов (точек) намного превышает количество компонент. Поэтому о ранге матриц судят по размерности матрицы ковариации.

Диагональные элементы ковариации отражают дисперсию компонент. Как мы видели выше, дисперсия и собственные числа тесно связаны. Поэтому можно сказать, что в первом приближении собственные числа матрицы ковариации (а значит, и корреляции) равны диагональным элементам (а если межкомпонентная дисперсия отсутствует, то равны в любом приближении).

Если стоит задача найти просто спектр матриц (собственные числа), то удобнее ее решать для матрицы ковариации, поскольку, как правило, их размерность небольшая. Но если нам необходимо найти еще и собственные вектора (определить собственную систему координат) для исходного набора, то необходимо работать с матрицей корреляции, поскольку именно она отражает скалярное произведение векторов.

Отметим, что метод главных компонент как раз и состоит в расчете спектра матрицы ковариации/корреляции для заданного набора векторных данных. Найденные компоненты спектра располагаются вдоль главных осей эллипсоида данных. Из нашего рассмотрения это вытекает потому, что главные оси — это и есть те оси, дисперсия (разброс) данных по которым максимален, а значит, и максимально значение спектра.

Правда, могут быть и отрицательные дисперсии, и тогда аналогия с эллипсоидом уже не очевидна.

9. Матрица Грина — это матрица корреляции векторов

Рассмотрим теперь ситуацию, когда нам известен не набор чисел, характеризующих точки (элементы), а набор расстояний между точками (причем между всеми). Достаточно ли данной информации для определения ССК (собственной системы координат) набора?

Ответ дан в первой части — да, вполне. Здесь же мы покажем, что построенная по формуле (1.3′) матрица Грина и определенная выше матрица корреляции векторов (8.1) — это одна и та же матрица.

Как такое получилось? Сами в шоке. Чтобы в этом убедиться, надо подставить выражение для элемента матрицы квадратов расстояний

в формулу преобразования девиации:

Отметим, что среднее значение матрицы квадратов расстояний отражает дисперсию исходного набора (при условии, что расстояния в наборе — это сумма квадратов компонент):

Подставляя (9.1) и (9.3) в (9.2), после несложных сокращений приходим к выражению для матрицы корреляции (8.1):

Итак, матрица Грина и матрица корреляции векторов — суть одно и то же. Ранг матрицы корреляции совпадает с рангом матрицы ковариации (количеством характеристик — размерностью пространства). Это обстоятельство позволяет строить спектр и собственную систему координат для исходных точек на основе матрицы расстояний.

Для произвольной матрицы расстояний потенциальный ранг (количество измерений) на единицу меньше количества исходных векторов. Расчет спектра (собственной системы координат) позволяет определить основные (главные) компоненты, влияющие на расстояния между точками (векторами).

Таким образом можно строить собственные координаты элементов либо на основании их характеристик, либо на основании расстояний между ними. Например, можно определить собственные координаты городов по матрице расстояний между ними.

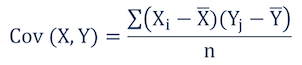

Ковариация и коэффициент корреляции

Ранее была рассмотрена диаграмма разброса, иллюстрирующая распределение двумерных числовых данные (см. последний раздел Изображение двумерных числовых данных заметки Представление числовых данных в виде таблиц и диаграмм). В настоящей заметке мы изучим два количественных показателя, характеризующих силу зависимости между двумя переменными — ковариацию и коэффициент корреляции. [1] Ковариация оценивает силу линейной зависимости между двумя числовыми переменными X и Y. Выборочная ковариация:

Скачать заметку в формате Word или pdf, примеры в формате Excel2013

Рассмотрим пятилетнюю среднегодовую доходность и долю затрат в фондах с очень низким уровнем риска (рис. 1). Для расчета ковариации двух выборок в Excel до 2007 года используется функция =КОВАР(), начиная с версии 2010 – функция КОВАРИВЦИЯ.В().

Рис. 1. Пятилетняя среднегодовая доходность и доля затрат взаимных фондов с очень низким уровнем риска

Любопытно, что ковариация случайной величины с собой равна дисперсии:

Если ковариация положительна, то с ростом значений одной случайной величины, значения второй имеют тенденцию возрастать, а если знак отрицательный — то убывать. Однако только по абсолютному значению ковариации нельзя судить о том, насколько сильно величины взаимосвязаны, так как её масштаб зависит от их дисперсий. Масштаб можно отнормировать, поделив значение ковариации на произведение среднеквадратических отклонений (квадратных корней из дисперсий). При этом получается так называемый коэффициент корреляции Пирсона.

Относительная сила зависимости, или связи, между двумя переменными, образующими двумерную выборку, измеряется коэффициентом корреляции, изменяющимся от –1 для идеальной обратной зависимости до +1 для идеальной прямой зависимости. Коэффициент корреляции обозначается греческой буквой ρ. Линейность корреляции означает, что все точки, изображенные на диаграмме разброса, лежат на прямой (рис 2). На панели А изображена обратная линейная зависимость между переменными X и Y. Таким образом, коэффициент корреляции ρ равен –1, т.е., когда переменная X возрастает, переменная Y убывает. На панели Б показана ситуация, в которой между переменными X и Y нет корреляции. В этом случае коэффициент корреляции ρ равен 0, и, когда переменная X возрастает, переменная Y не проявляет никакой определенной тенденции: она ни убывает, ни возрастает. На панели В изображена линейная прямая зависимость между переменными X и Y. Таким образом, коэффициент корреляции ρ равен +1, и, когда переменная X возрастает, переменная Y также возрастает.

Рис. 2. Три вида зависимости между двумя переменными

Рис. 3. Шесть диаграмм разброса и соответствующие коэффициенты корреляции, полученные с помощью программы Excel

На панели А показана ситуация, в которой выборочный коэффициент корреляции r равен –0,9. Прослеживается четко выраженная тенденция: небольшим значениям переменной X соответствуют очень большие значения переменной Y, и, наоборот, большим значениям переменной X соответствуют малые значения переменной Y. Однако данные не лежат на одной прямой, поэтому зависимость между ними нельзя назвать линейной. На панели Б приведены данные, выборочный коэффициент корреляции между которыми равен –0,6. Небольшим значениям переменной X соответствуют большие значения переменной Y. Обратите внимание на то, что зависимость между переменными X и Y нельзя назвать линейной, как на панели А, и корреляция между ними уже не так велика. Коэффициент корреляции между переменными X и Y, изображенными на панели В, равен –0,3. Прослеживается слабая тенденция, согласно которой большим значениям переменной X, в основном, соответствуют малые значения переменной Y. Панели Г–Е иллюстрируют положительную корреляцию между данными — малым значениям переменной X соответствуют большие значения переменной Y.

Обсуждая рис. 3, мы употребляли термин тенденция, поскольку между переменными X и Y нет причинно-следственных связей. Наличие корреляции не означает наличия причинно-следственных связей между переменными X и Y, т.е. изменение значения одной из переменных не обязательно приводит к изменению значения другой. Сильная корреляция может быть случайной и объясняться третьей переменной, оставшейся за рамками анализа. В таких ситуациях необходимо проводить дополнительное исследование. Таким образом, можно утверждать, что причинно-следственные связи порождают корреляцию, но корреляция не означает наличия причинно-следственных связей.

Выборочный коэффициент корреляции:

В Excel для вычисления коэффициента корреляции используется функция =КОРРЕЛ() (рис. 4).

Рис. 4. Функция КОРРЕЛ в Excel

Итак, коэффициент корреляции свидетельствует о линейной зависимости, или связи, между двумя переменными. Чем ближе коэффициент корреляции к –1 или +1, тем сильнее линейная зависимость между двумя переменными. Знак коэффициента корреляции определяет характер зависимости: прямая (+) и обратная (–). Сильная корреляция не является причинно-следственной зависимостью. Она лишь свидетельствует о наличии тенденции, характерной для данной выборки.

[1] Используются материалы книги Левин и др. Статистика для менеджеров. – М.: Вильямс, 2004. – с. 221–227

Повторение статистики для начала путешествия по науке о данных

Введение

Предположим, у нас есть диаграмма рассеяния, на которой каждая точка — это человек. На одной оси показан его профессиональный опыт в годах, на другой — доход.

В соответствии с диаграммой справа можно заключить, что между опытом и доходом нет никакой связи, то есть определенный опыт оплачивается по-разному.

Слева, наоборот, между признаками существует четкая линейная зависимость.

Ковариация и корреляция показывают, насколько тесно между собой связаны переменные набора данных.

N.B: в приведенном примере представлен двумерный вид данных (с двумя переменными). На практике статистики используют многомерные данные (со множеством переменных).

Ковариация

Ковариация — это мера зависимости между двумя или более случайных переменных.

С английского «covariance» = «co» (совместность/соединение) + «variance» (дисперсия). То есть ковариация похожа на дисперсию, но она применяется для сравнения двух переменных, где вместо суммы квадратов, мы получаем сумму векторного произведения.

Дисперсия показывает, насколько определенная переменная отличается от среднего значения, а ковариация — насколько две переменные отличаются друг от друга. Таким образом, можно утверждать следующее:

Ковариация измеряет дисперсию между двумя переменными.

Ковариация может быть отрицательной, положительной и нулевой: положительное значение показывает, что две переменные изменяются в одном направлении (если одна переменная увеличивается, то и вторая тоже увеличивается); отрицательное значение показывает, что две переменные изменяются в разных направлениях (одна увеличивается, вторая уменьшается); нулевая ковариация означает, что они изменяются независимо друг от друга.

Формула

Формулу сложно объяснить, но важно понять, что она означает:

Предположим, что набор данных со случайными переменными представлен в виде вектора. Тогда в прошлом примере у нас есть два вектора для опыта и дохода. Ниже приведен порядок действий:

На втором этапе измеряется угол между двумя векторами. Если угол острый, то переменные тесно связаны между собой.

Ограниченность

Следует отметить, что несмотря на то, что ковариация измеряет зависимость между направлениями двух переменных, она не показывает тесноту этой зависимости.

На практике самая большая проблема с этой мерой заключается в том, что она зависит от используемой единицы измерения. Например, необходимо перевести годы опыта в месяцы. Тогда ковариация будет в 12 раз больше.

В этом случае на помощь приходит корреляция!

Корреляция

Корреляция — одна из наиболее распространенных мер в статистике, описывающая тесноту взаимосвязи между двумя случайными переменными. Она считается нормализованной версией ковариации. Давайте рассмотрим, почему…

Формула

Корреляция (обозначаемая греческой буквой «ро» — ρ) рассчитывается по следующей формуле:

Обратите внимание, что функциональная связь редко встречается на практике, так как две случайные переменные обычно не сопоставляются друг с другом на основе постоянного значения.

Корреляция, равная 0, означает, что между двумя переменными нет линейной зависимости. Тогда может быть отношение x = y².

Ключевые свойства

Корреляция — безразмерная величина, указывающая не только на направление взаимосвязи, но и на ее тесноту (в зависимости от того, насколько большим является абсолютное значение). Единицы измерения исключены из-за того, что ковариацию разделили на среднеквадратическое отклонение.

Напоследок необходимо запомнить, что корреляция не является причинно-следственной связью. Высокая корреляция между двумя случайными переменными просто означает, что они связаны друг с другом, но их взаимоотношение не обязательно должен иметь причинно-следственный характер. Доказать причинно-следственную связь можно только с помощью контролируемых экспериментов, при которых внешние переменные исключаются и эффекты двух данных переменных изолируются.

Ковариация

Что такое Ковариация?

Ключевые моменты

Понимание ковариации

Ковариация оценивает, как средние значения двух переменных перемещаются вместе. Если доходность акции A увеличивается всякий раз, когда доходность акции B увеличивается, и такая же взаимосвязь обнаруживается, когда доходность каждой акции уменьшается, то считается, что эти акции имеют положительную ковариацию. В финансах ковариации рассчитываются, чтобы помочь диверсифицировать ценные бумаги.

Когда у аналитика есть набор данных, пара значений x и y, ковариация может быть рассчитана с использованием пяти переменных из этих данных. Они есть:

Учитывая эту информацию, формула ковариации: Cov (x, y) = SUM [(x i – x m ) * (y i – y m )] / (n – 1)

Краткая справка

Хотя ковариация действительно измеряет направленную взаимосвязь между двумя активами, она не показывает силу взаимосвязи между двумя активами; коэффициент корреляции является более подходящим показателем этой силы.

Ковариационные приложения

Между тем, теория портфелей использует ковариации для статистического снижения общего риска портфеля за счет защиты от волатильности за счет диверсификации с учетом ковариаций.

Краткая справка

Обладание финансовыми активами с доходностью, имеющей аналогичные ковариации, не обеспечивает большой диверсификации; следовательно, диверсифицированный портфель, вероятно, будет содержать набор финансовых активов с различными ковариациями.

Пример расчета ковариации

Предположим, что у аналитика компании есть набор данных за пять кварталов, который показывает квартальный рост валового внутреннего продукта ( ВВП ) в процентах (x) и рост новой линейки продуктов компании в процентах (y). Набор данных может выглядеть так:

Cov (x, y) = ((2 – 3) x (10 – 14,2) + (3 – 3) x (14 – 14,2) + … (4,1 – 3) x (20 – 14,2)) / 4 = (4,2 + 0 + 0,66 + 0,16 + 6,38) / 4 = 2,85

Рассчитав здесь положительную ковариацию, аналитик может сказать, что рост новой продуктовой линейки компании имеет положительную связь с квартальным ростом ВВП.

Какие значения принимает ковариация

6.5.1 лПЧБТЙБГЙС. лПЬЖЖЙГЙЕОФ ЛПТТЕМСГЙЙ

пЮЕЧЙДОП, ЮФП cov(ξ, η) НПЦОП ОБКФЙ ФПМШЛП Ч ФПН УМХЮБЕ, ЛПЗДБ УХЭЕУФЧХАФ УППФЧЕФУФЧХАЭЙЕ НБФЕНБФЙЮЕУЛЙЕ ПЦЙДБОЙС.

ъбнеюбойе. жПТНХМБ (6.5.1.1) Ч ТБУЮЕФБИ ЙУРПМШЪХЕФУС ТЕДЛП. пРЙТБСУШ ОБ УЧПКУФЧБ НБФЕНБФЙЮЕУЛПЗП ПЦЙДБОЙС Й ДЙУРЕТУЙЙ, НПЦОП РПМХЮЙФШ ВПМЕЕ ХДПВОЩЕ ДМС ТБУЮЕФПЧ ЖПТНХМЩ.

уРТБЧЕДМЙЧПУФШ ХФЧЕТЦДЕОЙК 2-3 УМЕДХЕФ ЙЪ ЖПТНХМЩ (6.5.1.2). дМС ДПЛБЪБФЕМШУФЧБ ПУФБМШОЩИ ЧПУРПМШЪХЕНУС УППФЧЕФУФЧХАЭЙНЙ УЧПКУФЧБНЙ НБФЕНБФЙЮЕУЛПЗП ПЦЙДБОЙС.

уРТБЧЕДМЙЧПУФШ ЧФПТПК ЖПТНХМЩ НПЦОП ДПЛБЪБФШ МЙВП БОБМПЗЙЮОП, МЙВП, ЙУРПМШЪХС УЧПКУФЧП 2.

уРТБЧЕДМЙЧПУФШ ЧФПТПК ЖПТНХМЩ НПЦОП ДПЛБЪБФШ МЙВП БОБМПЗЙЮОП, МЙВП ЙУРПМШЪХС УЧПКУФЧП 2.

умедуфчйе 6.5.1.1

1. cov(ξ, C) = cov(C, ξ) = 0, » C п R.

2. cov(ξ, Aξ + B) = cov(Aξ+B, ξ) = ADξ, » A, B п R.

2) cov(ξ, Aξ + B) = cov(ξ, Aξ) + cov(ξ, B) = Acov(ξ, ξ) + 0 = ADξ.

ъбнеюбойе. уМЕДХЕФ РПНОЙФШ, ЮФП ЙЪ cov(ξ, η) = 0 ОЕ УМЕДХЕФ ОЕЪБЧЙУЙНПУФЙ УМХЮБКОЩИ ЧЕМЙЮЙО ξ, η.

| xk | -2 | -1 | 1 | 2 |

| pk | 1/4 | 1/4 | 1/4 | 1/4 |

Mξ = (1/4)ћ(-2) + (1/4)ћ(-1) + (1/4)ћ2 + (1/4)ћ1 = 0.

тБУУНПФТЙН η = ξ 2 (η Й ξ Ч ФБЛПН УМХЮБЕ ЪБЧЙУЙНЩЕ УМХЮБКОЩЕ ЧЕМЙЮЙОЩ!) ъБЛПО ТБУРТЕДЕМЕОЙС УМХЮБКОПК ЧЕМЙЮЙОЩ η ЙНЕЕФ ЧЙД:

Mη = (1/2)ћ1 + (1/2)ћ4 = 5/2.

уМХЮБКОБС ЧЕМЙЮЙОБ ξ 3 ЙНЕЕФ ЪБЛПО ТБУРТЕДЕМЕОЙС:

| xk | -8 | -1 | 1 | 8 |

| pk | 1/4 | 1/4 | 1/4 | 1/4 |

Mξ 3 = (1/4)ћ(-8) + (1/4)ћ(-1) + (1/4)ћ1 + (1/4)ћ8 = 0. уМЕДПЧБФЕМШОП, cov (ξ, η) = 0, Б УМХЮБКОЩЕ ЧЕМЙЮЙОЩ СЧМСАФУС ЪБЧЙУЙНЩНЙ.

пртедемеойе 6.5.1.2

лПЬЖЖЙГЙЕОФПН лпттемсгйй ДЧХИ УМХЮБКОЩИ ЧЕМЙЮЙО ξ Й η ОБЪЩЧБЕФУС ЮЙУМП, ПРТЕДЕМСЕНПЕ РП ЖПТНХМЕ:

| пвпъобюеойе: |  | (6.5.1.5) |

ъбнеюбойе. пЮЕЧЙДОП, ЮФП ЛПЬЖЖЙГЙЕОФ ЛПТТЕМСГЙЙ ДЧХИ УМХЮБКОЩИ ЧЕМЙЮЙО НПЦОП ПРТЕДЕМЙФШ МЙЫШ Ч ФПН УМХЮБЕ, ЛПЗДБ УХЭЕУФЧХАФ УППФЧЕФУФЧХАЭЙЕ НБФЕНБФЙЮЕУЛЙЕ ПЦЙДБОЙС Й Dξ

пРЙТБСУШ ОБ УЧПКУФЧБ ЛПЧБТЙБГЙЙ Й ДЙУРЕТУЙЙ (6.2.2), НПЦОП РПМХЮЙФШ ЕЭЕ ФТЙ ДПРПМОЙФЕМШОЩЕ ЖПТНХМЩ ДМС ЧЩЮЙУМЕОЙС ЛПЬЖЖЙГЙЕОФБ ЛПТТЕМСГЙЙ.

(уНПФТЙ ЖПТНХМХ 6.5.1.3). уМЕДПЧБФЕМШОП,

уПЧЕТЫЕООП БОБМПЗЙЮОП, ПРЙТБСУШ ОБ ЖПТНХМХ 6.5.1.4, НПЦОП ДПЛБЪБФШ, ЮФП:

уЧПКУФЧБ 1-2 УМЕДХАФ ЙЪ УЧПКУФЧ ЛПЧБТЙБГЙЙ.

5) ( а ) (ОЕПВИПДЙНПУФШ)

Б) ρ(ξ, η) = 1 а ЙЪ ЖПТНХМЩ 6.5.1.8 УМЕДХЕФ, ЮФП

фБЛЙН ПВТБЪПН, η = Aξ + B, ЗДЕ

ъБНЕФЙН, ЮФП

( ш ) η = Aξ + B; A, B п R Й A

умедуфчйе 6.5.1.2

ρ(ξ, ξ) = 1.

ъбнеюбойе. уМЕДХЕФ РПНОЙФШ, ЮФП ЙЪ ρ(ξ, η) = 0 ОЕ УМЕДХЕФ ОЕЪБЧЙУЙНПУФШ УМХЮБКОЩИ ЧЕМЙЮЙО ξ Й η. (фБЛ ЛБЛ ρ(ξ, η) = 0 щ cov(ξ,η)=0; Б ЙЪ cov(ξ,η)=0 ОЕ УМЕДХЕФ, ЮФП ξ Й η ОЕЪБЧЙУЙНЩЕ УМХЮБКОЩЕ ЧЕМЙЮЙОЩ).

пртедемеойе 6.5.1.3

еУМЙ ρ(ξ, η) = 0, ФП УМХЮБКОЩЕ ЧЕМЙЮЙОЩ ξ Й η ОБЪЩЧБАФУС оелпттемйтхенщнй.

ъбнеюбойе. еУМЙ ρ(ξ, η)

еУМЙ ρ(ξ, η)

ьФП РТЙВМЙЦЕОЙЕ СЧМСЕФУС ОБЙМХЮЫЕН Ч УНЩУМЕ:

пртедемеойе 6.5.1.5

пРТЕДЕМЙФЕМШ ЛПЧБТЙБГЙПООПК НБФТЙГЩ ОБЪЩЧБЕФУС пвпвэеоопк дйуретуйек УМХЮБКОПЗП ЧЕЛФПТБ.

уМЕДПЧБФЕМШОП, ЛПТТТЕМСГЙПООБС НБФТЙГБ R СЧМСЕФУС УЙННЕФТЙЮОПК.

ъБРЙЫЙФЕ УБНПУФПСФЕМШОП УППФЧЕФУФЧХАЭЙЕ ЖПТНХМЩ ДМС УМХЮБКОПЗП ЧЕЛФПТБ ДЙУЛТЕФОПЗП ФЙРБ.

ъбдбюб 6.5.1.1 йЪЧЕУФОП, ЮФП Mξ = 1, Dξ = 2; η = 5ξ + 7. оБКФЙ cov(ξ, η).

cov(ξ, η) = cov(ξ, 5ξ + 7) = 5Dξ = 10.

ъбдбюб 6.5.1.3 дБО ЪБЛПО ТБУРТЕДЕМЕОЙС УМХЮБКОПЗП ЧЕЛФПТБ (ξ1, ξ2) ДЙУЛТЕФОПЗП ФЙРБ:

| 5 | 6 | 7 |

|---|---|---|---|

| 0 | 0,2 | 0 | 0 |

| 0,1 | 0,1 | 0,15 | 0 |

| 0,2 | 0,05 | 0,15 | 0,1 |

| 0,3 | 0,05 | 0,1 | 0,1 |

оБКФЙ: ЛПЧБТЙБГЙПООХА Й ЛПТТЕМСГЙПООХА НБФТЙГЩ УМХЮБКОПЗП ЧЕЛФПТБ (ξ1, ξ2).

1) рТЕЦДЕ ЧУЕЗП ОБКДЕН ЪБЛПО ТБУРТЕДЕМЕОЙС ЛБЦДПК ЛПНРПОЕОФЩ (БМЗПТЙФН УНПФТЙ 4.4.2)

| ξ1 | 5 | 6 | 7 |

|---|---|---|---|

| 0,4 | 0,4 | 0,2 |

Mξ1 2 = 25ћ0,4 + 36ћ0,4 + 49ћ0,2 = 34,2;

| ξ2 | 0 | 0,1 | 0,2 | 0,3 |

|---|---|---|---|---|

| 0,2 | 0,25 | 0,3 | 0,25 |

Mξ2 = 0ћ0,2 + 0,1ћ0,25 + 0,2ћ0,3 + 0,3ћ0,25 = 0,16;

Mξ2 2 = 0ћ0,1 + 0,01ћ0,25 + 0,04ћ0,3 + 0,09ћ0,25 = 0,037;

ъБНЕФЙН, ЮФП УМХЮБКОБС ЧЕМЙЮЙОБ ξ1ћξ2 РТЙОЙНБЕФ УМЕДХАЭЙЕ ЪОБЮЕОЙС Ч ЪБЧЙУЙНПУФЙ ПФ ЪОБЮЕОЙК ЛПНРПОЕОФ:

| 5 | 6 | 7 |

|---|---|---|---|

| 0 | 0 | 0 | 0 |

| 0,1 | 0,5 | 0,6 | 0,7 |

| 0,2 | 1 | 1,2 | 1,4 |

| 0,3 | 1,5 | 1,8 | 2,1 |

уМЕДПЧБФЕМШОП, ЪБЛПО ТБУРТЕДЕМЕОЙС УМХЮБКОПК ЧЕМЙЮЙОЩ ξ1ћξ2 ЙНЕЕФ УМЕДХАЭЙК ЧЙД:

| xk | 0 | 0,5 | 0,6 | 0,7 | 1 | 1,2 | 1,4 | 1,5 | 1,8 | 2,1 |

| pk | 0,2 | 0,1 | 0,15 | 0 | 0,05 | 0,15 | 0,1 | 0,05 | 0,1 | 0,1 |

M(ξ1ξ2) = 0ћ0,2 + 0,1ћ0,5 + 0,6ћ0,15 + 0,7ћ0 + 0,05ћ1 + 0,15ћ1,2 +

+ 1,4ћ0,1 + 1,5ћ0,05 + 0,1ћ1,8 + 0,1ћ2,1 = 0,975.

Dξ1Dξ2 = 0,56ћ0,0114 = 0,006384 а ρ12 = ρ21 =

ъбдбюб 6.5.1.4 йЪЧЕУФЕО ЪБЛПО ТБУРТЕДЕМЕОЙС УМХЮБКОПЗП ЧЕЛФПТБ:

| 0 | 1 |

|---|---|---|

| -1 | 0,1 | 0,2 |

| 0 | 0,2 | 0,3 |

| 1 | 0 | 0,2 |

оБКФЙ НБФЕНБФЙЮЕУЛПЕ ПЦЙДБОЙЕ Й ДЙУРЕТУЙА УМХЮБКОПК ЧЕМЙЮЙОЩ q = 2ξ1 + ξ 2 2.

уМЕДПЧБФЕМШОП, РТЕЦДЕ ЧУЕЗП ПРТЕДЕМЙН ЪБЛПОЩ ТБУРТЕДЕМЕОЙС ξ1 Й ξ2.

| ξ1 | xk | 0 | 1 |

|---|---|---|---|

| pk | 0,3 | 0,7 |

| ξ2 | xk | -1 | 0 | 1 |

|---|---|---|---|---|

| pk | 0,3 | 0,5 | 0,2 |

| ξ2 2 | xk | 0 | 1 |

|---|---|---|---|

| pk | 0,5 | 0,5 |

| ξ1ξ2 2 | xk | 0 | 1 |

|---|---|---|---|

| pk | 0,6 | 0,4 |

D q = 4ћ0,21 + 0,25 + 2ћ0,05 = 0,84 + 0,25 + 0,1 = 1,29.

ъбдбюб 6.5.1.5 йЪЧЕУФОБ РМПФОПУФШ ТБУРТЕДЕМЕОЙС УМХЮБКОПЗП ЧЕЛФПТБ (ξ, η):

оБКФЙ ЛПЧБТЙБГЙА УМХЮБКОЩИ ЧЕМЙЮЙО ξ, η.

(чУЕ ЧЩЮЙУМЕОЙС РТПЧЕТШФЕ!)

ъБДБЮЙ ДМС УБНПУФПСФЕМШОПЗП ТЕЫЕОЙС.

ъбдбюб 6.5.1.1(у) дБО ЪБЛПО ТБУРТЕДЕМЕОЙС УМХЮБКОПЗП ЧЕЛФПТБ (ξ1, ξ2):

| 0 | 2 | 5 |

|---|---|---|---|

| 1 | 0,1 | 0 | 0,2 |

| 2 | 0 | 0,3 | 0 |

| 4 | 0,1 | 0,3 | 0 |

уПУФБЧЙФШ ЛПЧБТЙБГЙПООХА Й ЛПТТЕМСГЙПООХА НБФТЙГЩ.

ъбдбюб 6.5.1.3(у) йЪЧЕУФОБ РМПФОПУФШ ТБУРТЕДЕМЕОЙС УМХЮБКОПЗП ЧЕЛФПТБ (ξ, η):

© гЕОФТ ДЙУФБОГЙПООПЗП ПВТБЪПЧБОЙС пзх, 2000-2002