примеры страниц которые содержат одинаковый контент и различаются только get параметрами в url

Ссылки с разными get параметрами это дубли?

Я бы не считал это дублем. Параметр может влиять на формирование результата. Только лишь на основании не особо удачного названия параметра со словом ‘fake’ я бы не стал делать выводов о том как он влияет на результат.

Другими словами, я бы спросил себя : Влияет ли на результат параметр? Если да, то это не дубли

Если ПС добавить оба эти URL в свою базу, и по ним показывается один и тот же контент (а раз параметр фейковый, то и контент будет одинаковый), то да, она посчитает эти страницы дублями.

canonical действительно поможет этого избежать.

Еще есть директивы в robots.txt у Яндекса: https://yandex.ru/support/webmaster/controlling-ro.

но гугл их вроде не поддерживает.

А вообще используйте Sitemap и будет вам счастье

каждый из данных вариантов имеет минусы, так что выбирать нужно под сайт индивидуально

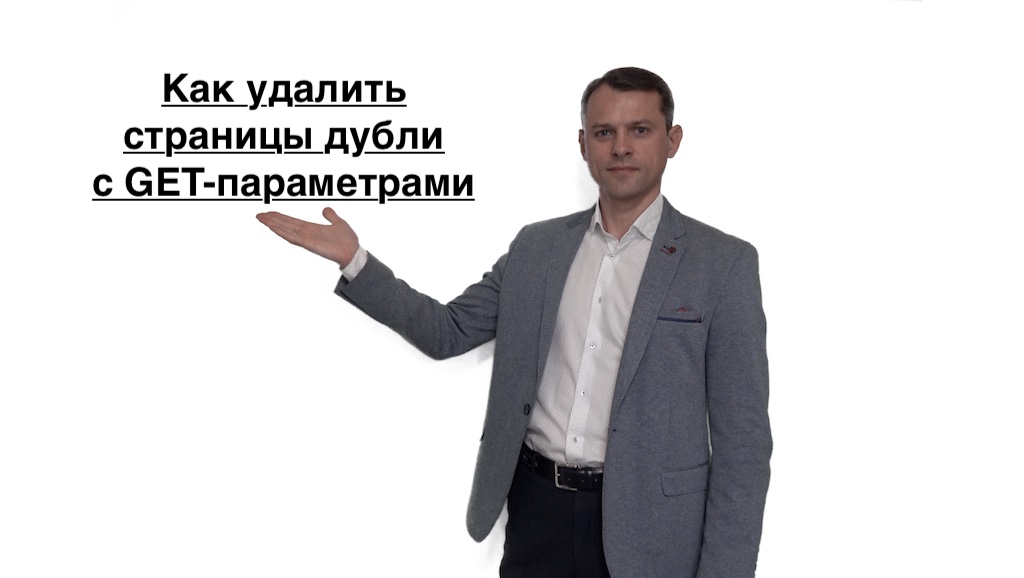

Ошибка Я. Вебмастера: найдены страницы дубли с GET-параметрами — что делать

Дубли страниц могут приводить к потери позиций в поисковой выдаче и снижать скорость индексации. Стоит понимать, что у поискового робота есть определенный лимит запросов к домену в день. Поэтому существует вероятность того, что он потратит все лимиты на сканирование мусорных страниц и не доберется до страниц с уникальным контентом.

О наличии проблемы с дублированным контентом свидетельствует сообщение в панели Вебмастера: «Найдены страницы дубли с GET параметрами». В своем сообщении Яндекс информирует вебмастера о том, что на некоторых страницах сайта размещен одинаковый контент, различающийся только гет-параметрами.

Что такое get-параметры на сайте

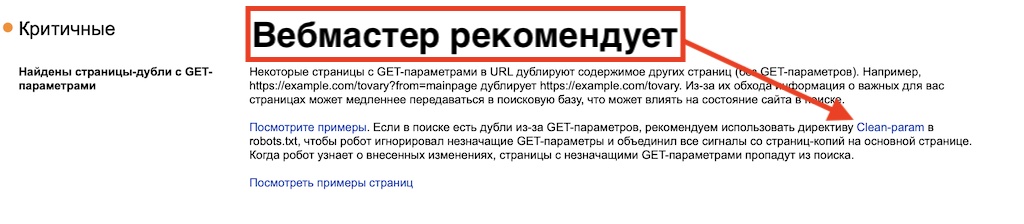

Если в поиске есть дублированные страницы из-за гет-параметров, Яндекс предлагает воспользоваться правилом Clean-param в robots.txt (правило действительно только для Яндекс, Google его не воспринимает).

В результате использования Clean-param поисковый робот Яндекса объединяет сигналы с дублированных страниц на основной. После того, как краулер узнает обо всех произошедших изменениях, страницы с не имеющими значение гет-параметрами исчезнут из поисковой выдачи.

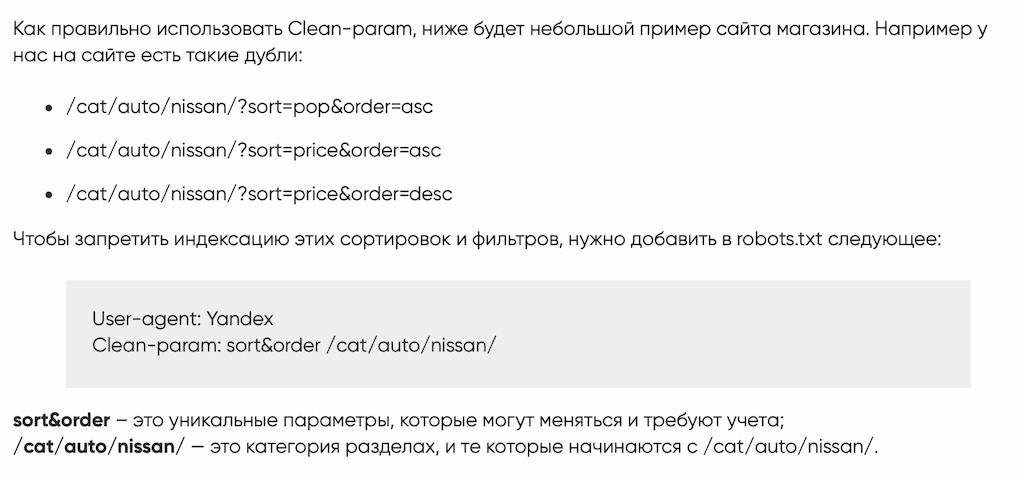

Как использовать Clean-param

Для понимания того, как используется Clean-param, стоит привести простой пример. Существуют дубли страницы со следующими гет-параметрами:

Чтобы в результатах поиска учитывалась только основная страница http://mysite.ru/cat/auto/nissan/, нужно задать правило Clean-param в файле robots.txt:

User-agent: Yandex

Clean-param: sort&order /cat/auto/nissan/

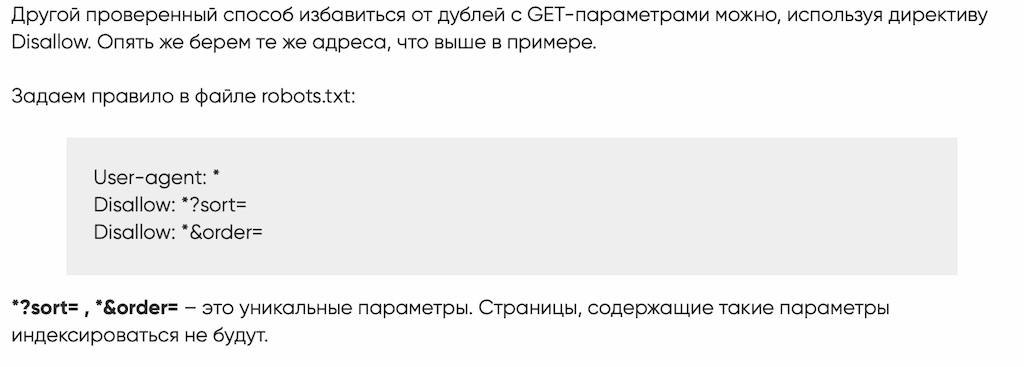

Как использовать Disallow

Избавиться от страниц-дублей с GET-параметрами можно, используя директиву Disallow. Для примера возьмем те же страницы-дубли:

Чтобы в результатах поиска учитывалась только основная страница http://mysite.ru/cat/auto/nissan/, нужно задать правило в файле robots.txt:

User-agent: *

Disallow: *?sort=

Disallow: *&order=

Также можно закрыть от индексации ВСЕ Get-параметры одним правилом?

User-agent: *

Disallow: *?

Будьте осторожны! Используйте директиву Disallow очень внимательно, чтобы случайно не закрыть от индексации нужные страницы (например, не используйте правило, если карточки товара или категории в обязательном порядке содержат get-параметр в url).

Как найти дубли страниц с незначащими GET-параметрами

Дубли страниц на сайте могут появиться в поиске вместо ценных страниц сайта или замедлить их обход и индексирование.

Вообще, дубли — это страницы сайта, содержание текста в которых полностью или практически совпадает. Страницы с GET-параметрами в URL тоже могут быть дублями. Если GET-параметр влияет на содержание страницы — это не дубль. А если GET-параметр не меняет контент страницы, то этот параметр называют незначащим и страницу стоит скрыть от поиска.

Расскажем подробнее, что такое незначащие GET-параметры, как найти дубли с такими параметрами и убрать их.

Что такое дубли страниц с незначащими GET-параметрами

GET-параметр — это параметр, который передается серверу в URL страницы. Он начинается с вопросительного знака. Если URL содержит более одного параметра, то эти параметры разделяются знаком «&». Самый частый случай появления дублей из-за незначащих параметров — метки для задач веб-аналитики. Например, utm_source, utm_medium, from. Такими метками владельцы сайтов привыкли помечать трафик. Фактически эти URL одинаковые, на них опубликован одинаковый контент. Но формально адреса разные, так как различаются GET-параметрами в URL. Соответственно, и поиск тоже может посчитать их разными. Такие страницы и называются дублями с незначащими GET-параметрами.

Наличие дублей страниц с незначащими GET-параметрами не приносит пользы и может негативно сказаться на взаимодействии сайта с поисковой системой.

Зачем отслеживать дубли

1) Скорость обхода. Когда на сайте много дублей, роботы тратят больше времени и ресурсов на их обход, вместо того, чтобы обходить ценный контент. А значит, ценные страницы вашего сайта будут медленнее попадать в поиск.

2) Неуправляемость. Так как поисковой робот произвольно выбирает, какой из дублей показывать в поиске, то на поиск могут попасть не те страницы, которые вам нужны.

3) Влияние на поиск. Если незначащие параметры не добавлены в clean-param, робот может обходить эти страницы и считать их разными, не объединяя их в поиске. Тогда поисковый робот будет получать разные неагрегируемые сигналы по каждой из них. Если бы все сигналы получала одна страница, то она имела бы шансы показываться выше в поиске.

4) Нагрузка на сайт. Лишний обход роботом также дает нагрузку на сайт.

Например, на сайте по продаже билетов есть форма заявки на обратный звонок. При ее заполнении в url передается GET-параметр?form=show1, — он сообщает информацию о том, какой спектакль с этой страницы выбрал пользователь в заявке, хотя контент самой страницы никак не меняется. Таким образом, поисковой робот будет тратить время на обход множества одинаковых страниц, различающихся только GET-параметрами в URL, а до ценных страниц сайта доберется значительно позже.

Для интернет-магазинов типичный пример — страницы с фильтрами. Например, если пользователь выбирает товары в дорогом ценовом диапазоне, изменяя значения в фильтре «Цена», то в большинстве случаев ему будет показана страница с одними и теми же товарами. Таким образом, поиск будет получать сигналы о множестве одинаковых страниц, отличающихся только GET-параметром price= в URL.

Как обнаружить дубли

Теперь находить одинаковые страницы стало проще: в разделе «Диагностика» появилось специальное уведомление, которое расскажет про дубли из-за GET-параметров. Алерт появляется с небольшой задержкой в 2-3 дня, поэтому если вы увидели в нем исправленные страницы, не пугайтесь — это может быть связано с задержкой обработки данных. Дубли с параметром amp, даже если они у вас есть, мы не сможем показать в алерте.

Подписываться на оповещения не нужно, уведомление появится само. Если вы обнаружили дубли:

1. Перейдите в Вебмастер, откройте раздел Страницы в поиске, в таблице выберите Исключенные страницы.

2. Загрузите архив (подходящий формат можно выбрать внизу страницы) и просмотрите скачанный файл: у страниц-дублей будет статус DUPLICATE.

Как оставить в поиске нужную страницу

1. Добавьте в файл robots.txt директиву Clean-param, чтобы робот не учитывал незначащие GET-параметры в URL. Робот Яндекса, используя эту директиву, не будет много раз обходить повторяющийся контент. Значит, эффективность обхода повысится, а нагрузка на сайт снизится.

2. Если вы не можете добавить директиву Clean-param, укажите канонический адрес страницы, который будет участвовать в поиске. Это не уменьшит нагрузку на сайт: роботу Яндекса всё равно придётся обойти страницу, чтобы узнать о rel=canonical. Поэтому мы рекомендуем использовать Сlean-param как основной способ.

3. Если по каким-то причинам предыдущие пункты вам не подходят, закройте дубли от индексации при помощи директивы Disallow. Но в таком случае поиск Яндекса не будет получать никаких сигналов с запрещенных страниц. Поэтому мы рекомендуем использовать Сlean-param как основной способ.

Найдены страницы дубли с GET-параметрами | Что это такое и что с ними делать

Добрейшего всем денечка! С вами Кузнецов Анатолий и сегодня я затрону очень важную тему и боль интернет-магазинов, на которых в вебмастере Яндекс высветилась надпись: “найдены страницы дубли с GET-параметрами“. Эти дубли действительно сильно портят жизнь сайтам и ухудшают их ранжирование в поисковой системе Яндекс.

Чем опасны страницы дубли с GET-параметрами для SEO

Любые возникающие дубли страниц на сайте могут попасть в индекс вместо главных (рабочих и продающих) страниц, а также замедлить обход и индексацию роботами скроллерами. Если объяснять по простому, то дубли страниц – это практически полностью похожие друг на друга страницы сайта с одинаковым содержимым. Когда поисковые роботы видят такие дубли, они не могут понять, какая страница наиболее релевантна и могут исключить из индекса обе, либо проиндексировать не ту которая нужна вам. Это и является основной болью.

Страницы с GET-параметрами влияющие на содержание не являются дублями. А если в свою очередь GET параметр не изменяет контент (URL) на конкретной странице, то он является дублирующим и его необходимо скрыть от индексации поисковыми роботами.

Что такое страницы дубли с GET-параметрами

GET-параметр — это параметр, который передается серверу в URL страницы. Он начинается с вопросительного знака. Если URL содержит более одного параметра, то эти параметры разделяются знаком «&». Самый частый случай появления дублей из-за незначащих параметров — метки для задач веб-аналитики. Например, utm_source, utm_medium, from. Такими метками владельцы сайтов привыкли помечать трафик. Фактически эти URL одинаковые, на них опубликован одинаковый контент. Но формально адреса разные, так как различаются GET-параметрами в URL. Соответственно, и поиск тоже может посчитать их разными. Такие страницы и называются дублями с незначащими GET-параметрами.

Зачем нужно постоянно отслеживать страницы дубли с GET-параметрами

Как удалить страницы дубли с GET-параметрами

Самый простой и рабочий метод удаления дублей страниц, это внести изменения в файл Robots.txt, через директорию и правила Clean-param или Disallow. Собственно это предлагает сделать и сам Яндекс в Вебмастере:

Что такое деректива clean-param

Как использовать Clean-param

Если у вас нет позможности добавить на сайт дерективу Clean-param, то необходимо прописать для каждой дублированной страницы канонические параметры. Но этот метод не уменьшит нагрузку на сайт, так как роботы Яндекса будут обрашаться к команде rel=canonical и обходить страницы дублей.

Если оба способа вам не подходят, то можно жестко перекрыть доступ роботам к таким страницам, выключив их из индекса дерективой Disallow. В таком случае поисковик не будет получать никаких сигналов от этих страниц.

Как использовать директиву Disallow

Бесплатная проверка сайта на SEO ошибки

Специально для читателей моего блога я разработал бесплатный сервис проверки сайта на наличие технических и SEO ошибок, которые сдерживают его продвижение в поисковых системах Яндекс и Google. Устранив эти проблемы, ваш сайт вздохнет полной грудью и оставит конкурентов позади! Посмотрите короткое видео о работе сервиса и проверяйте свой WEB ресурс:

Заключение

Вы получили печальный опыт блокировки за накрутку, испробовали уже все методы продвижения, а толку нет? Разочаровались в Яндекс Директ и Google Adwords. Пора прекращать верить в сказки и доброго волшебника в голубом вертолете, который спасёт ваш бизнес. Пора заняться действительно качественной и проверенной временем SEO работой – начать продвижение интернет магазина или сайта статьями! Не хочу вас уговаривать, да если честно и смысла нет, так как очередь на продвижение у меня уже растянулась минимум на три месяца вперед (подробнее мои SEO кейсы). Я информирую Вас лишь для того, чтобы Вы впервые выбрали для себя правильный путь развития бизнеса и наконец-то получили результат. И не важно, я буду в этом вам помогать или Дядя Ваня. Но все же, если Вы хотите выбрать меня, то жмите кнопку ниже (пишите, звоните) и мы скорее всего договоримся и я спустя какое-то время возьмусь за ваш WEB проект и вдохну в него жизнь в виде действительно продающих текстов!

Сколько GET-параметров должно быть в URL

Передача GET-параметров осуществляется каждый раз, когда происходит запрос к серверу. Не рекомендуется использовать в URL слишком много параметров, так как при росте их числа сложно установить контроль над ними со стороны веб-браузера и сервера. Если же такое произойдет, то поисковые системы начнут воспринимать разные страницы ресурса как дубли.

Как не столкнуться с такими проблемами и что такое GET-параметры – поговорим в сегодняшней статье.

Что такое GET-параметр

Прежде чем перейти к определению GET-параметра, поговорим о том, как происходит связь клиента и сервера в интернете. Выполняется это через HTTP-протокол – протокол передачи гипертекста. Благодаря ему обмен данными может осуществляться по принципу «запрос-ответ»: когда пользователь получает URL-адрес через веб-браузер, выполняется запрос на сервер, и в качестве ответа предоставляется HTML-страница, загруженная браузером. Для такого рода связи используются такие параметры, как GET и POST. Нас интересуют лишь GET-запросы – остановимся на них поподробнее.

Когда выполняется метод GET, клиент использует HTTP-протокол на веб-сервере для запроса необходимого ресурса, затем он отправляет серверу определенные параметры GET через запрошенный URL. Страница, созданная данным методом, может быть открыта повторно множество раз, кэширована браузером, проиндексирована поисковыми системами и добавлена в закладки пользователем.

GET-параметры представляют собой пары и соответствующие им значения, так называемые пары «имя-значение». Они всегда начинаются с вопросительного знака «?». За ним следует имя переменной и соответствующее значение, разделенные знаком «=». Если URL-адрес содержит более одного параметра, то они разделяются амперсандом «&».

Thing – первый GET-параметр, section – второй.

В коде прописывается следующим образом:

Чаще всего необходимость в таких запросах возникает, когда нужно отфильтровать страницу по каким-либо параметрам. Например, чтобы отобразить список определенных машин на сайте по продаже авто, открыть каталог смартфонов белого цвета с 32 Гб памяти и т.п.

Таким образом, мы можем прописывать параметры в URL и изменять с их помощью содержимого страницы.

Для чего нужен параметр GET

URL-адреса с GET-параметрами называются динамическими – их изменение приводит к смене адреса и содержимого страницы. Например, если интернет-магазин только что добавил продукты на страницу категории, а пользователь в этот момент открывает эту страницу в браузере, то новые продукты также будут отображаться, так как адрес страницы запрашивает измененный контент с помощью параметра GET. Также в данном методе происходит подстраивание заголовков под запрос пользователей, благодаря чему можно увеличить конверсию сайта. GET-параметры необходимы при создании динамических сайтов – интернет-магазинов, форумов, сайтов-отзовиков и т.п.

Стоит также понимать, что при передаче личной информации не рекомендуется использовать GET-параметры, так как они совершенно не подходят для конфиденциальной информации. Связано это с тем, что информация в адресной строке открыта каждому. Если вы хотите использовать в URL конфиденциальную информацию, то лучше воспользоваться POST-запросами.

Оптимальное количество GET-параметров

Как мы уже выяснили, один запрос включает в себя один или несколько GET-параметров. HTTP-протокол может использовать неограниченное количество таких запросов, но в этом нет никакой необходимости. Напротив, при использовании большого количества параметров могут возникнуть проблемы с рейтингом сайта в поисковых системах. Связано это с тем, что лимиты все-таки присутствуют, но со стороны сервера и браузера. Если длина будет превышена, то запрос попросту урежется.

Однако никто не сможет назвать идеальное количество параметров. Для разных серверов это число может колебаться – для одного 32 Кб, для другого – 1024 Кб. Золотая середина – 512 Кб. Рекомендуется использовать не более 5 параметров, иначе их будет сложно контролировать со стороны сервера и браузера. Если необходимо отправить большое количество данных, то лучше использовать POST-запросы.

Заключение

Мы разобрали один из методов отправки данных на сервер под названием GET. Он передает информацию в URL через специальные GET-параметры, количество которых должно соответствовать типу сервера. Если лимит будет превышен, то запросы сократятся до нужного размера. Использование таких опций полезно на динамических сайтах, где контент адаптируется под определенного пользователя и его запросы.