проиндексировано несмотря на блокировку в файле robots txt как исправить

Проиндексировано, несмотря на блокировку в файле robots.txt

Дата вопроса: 05.11.2018, 19:01

В новой версии инструментов для вебмастеров от гугла есть раздел «Проиндексировано, несмотря на блокировку в файле robots.txt» и там указано более 500 страниц.

Всем этим страницам мы заблокировали индексирование в robots.txt, почему они проиндексированы, ведь правила индексирования указаны? стоит ли обращать внимание на этот отчет?

Рекомендуйте нас друзьям

4 комментария

Дата сообщения: 30.01.2019, 10:05

Добрый день, ARSales.

В данном случае необходимо удалить из файла Robots.txt директивы:

Disallow: /?s=

Disallow: /*?

А на всех мусорных страницах, которые Вы закрывали при помощи данной директивы прописать мета тег meta name=»robots» content=»noindex, follow».

Дата сообщения: 01.02.2019, 16:32

Добрый день.Выдает «Проиндексировано, несмотря на блокировку в файле robots.txt» в блоггере.Что с этим делать?

Дата сообщения: 15.04.2019, 09:41

Добрый день, Татьяна! Если проиндексирована страница, закрытая в robots.txt (а мы не хотим, чтобы она индексировалась), то верным решением будет прописать в её (страницы) коде meta name=»robots» content=»noindex,follow» или meta name=»robots» content=»noindex,nofollow». Однако в вашем случае это невозможно, т.к. в блоггере нет доступа к правке кода страниц. Поэтому не остаётся ничего другого, как философски отнестись к «непослушанию» поискового робота. 🙂

Дата сообщения: 14.05.2019, 18:54

Добрый вечер, спасибо за интересный вопрос.

Дело в том, что для поисковой системы Google в файле Robots.txt прописываются правила сканирования ресурса, но не индексирования. Т.е. сканирование может быть запрещено, но поисковая система может добавить в индекс данный url-адрес, так как может найти его другими способами.

Поисковая система Яндекса, в отличие от Google, использует файл Robots.txt как правила сканирования и индексирования. Яндекс всегда следует директивам в файле Robots.txt.

Справки поисковых систем Google и Яндекс по работе с файлом Robots.txt.

В новой Search Console появился очень интересный и полезный отчет «Проиндексировано, несмотря на блокировку в файле robots.txt», который содержит все url-адреса сайта, которые добавлены в индекс, хотя и заблокированы в файле Robots.txt.

Это является проблемой, так как проиндексированы некачественные документы. Некачественные документы в индексе поисковой системы негативно влияют на ранжирование сайта.

Следовательно данную проблему необходимо решить следующим образом:

Исходя из нашего опыта, если таких страниц в индексе очень много, то решение данной проблемы приведет к существенному улучшению ранжирования сайта в поисковой системе Google.

Как устранить проблему “Проиндексировано, несмотря на блокировку в файле robots.txt” в GSC

Share this article

В большинстве случаев, если вы заблокировали сканирование в своем файле robots.txt, это является очевидной проблемой. Но есть несколько дополнительных условий, которые могут вызвать эту проблему, поэтому давайте рассмотрим следующий процесс устранения неполадок, который поможет выявлять и исправлять существующие проблемы как можно более эффективно.

Как видите, первым делом нужно спросить себя, хотите ли вы, чтобы Google индексировал URL-адрес.

Если вы не хотите, чтобы URL-адрес индексировался…

Просто добавьте атрибут noindex в метатег robots и убедитесь, что сканирование разрешено, если адрес каноничный.

Если вы заблокируете сканирование страницы, Google все равно сможет проиндексировать ее, потому что сканирование и индексирование — это разные процессы. Если Google не может сканировать страницу, они не увидят атрибут noindex в метатеге и все равно смогут проиндексировать страницу, если на ней есть ссылки.

Если URL-адрес каноникализируется на другую страницу, не добавляйте атрибут noindex в метатег robots. Просто убедитесь, что настроены правильные сигналы каноникализации, включая атрибут canonical на канонической странице, и разрешите сканирование, чтобы сигналы проходили и консолидировались правильно.

Если вы хотите, чтобы URL-адрес индексировался…

Вам нужно выяснить, почему Google не может просканировать URL-адрес и снять блокировку.

Наиболее вероятная причина — блокировка сканирования в robots.txt. Но есть несколько других сценариев, которые могут вызывать предупреждение о том, что вы заблокированы. Давайте рассмотрим их в том порядке, в котором вам, вероятно, стоит их искать.

Проверьте наличие блокировки сканирования в robots.txt

Директива может блокировать какой-то конкретный или все user-agent. Если ваш сайт новый или был запущен недавно, вы можете поискать:

Возможно, кто-то опередил вас и уже устранил блокировку robots.txt, чем и решил проблему. Это наилучший сценарий. Однако, если проблема выглядит исправленной, но появляется снова спустя какое-то время, возможно, вы испытываете проблемы из-за периодической блокировки.

Как это исправить

Вам нужно удалить директиву disallow, вызывающую блокировку. Способ исправления проблемы зависит от используемой вами технологии.

WordPress

Если проблема затрагивает весь ваш веб-сайт, наиболее вероятная причина в том, что вы включили параметр в WordPress, отвечающий за запрет индексации. Эта ошибка часто встречается на новых веб-сайтах и после проведения миграции. Выполните следующие действия, чтобы проверить это.

WordPress с Yoast

WordPress с Rank Math

Как и Yoast, Rank Math позволяет напрямую редактировать файл robots.txt.

FTP или хостинг

Если у вас есть FTP-доступ к сайту, вы можете напрямую отредактировать файл robots.txt, чтобы удалить директиву disallow, вызывающий проблему. Ваш хостинг-провайдер также может предоставлять вам доступ к файловому менеджеру, с помощью которого вы можете напрямую обращаться к файлу robots.txt.

Проверьте наличие периодической блокировки

Периодические проблемы труднее устранить, поскольку условия, вызывающие блокировку, могут не присутствовать в момент проверки.

Я рекомендую проверить историю вашего файла robots.txt. Например, в средстве проверки robots.txt в GSC хранятся предыдущие версии файлов. Вы можете нажать на раскрывающийся список, выбрать версию и посмотреть ее содержимое.

У The Wayback Machine на archive.org также хранится история файлов robots.txt для веб-сайтов, которые они сканируют. Вы можете щелкнуть любую дату, по которой у них есть данные, и посмотреть, как выглядел файл в этот конкретный день.

Вы также можете воспользоваться бета-версией отчета “Изменения” (Changes), который позволяет легко просматривать изменения содержимого между двумя разными версиями файлов.

Как это исправить

Проверьте наличие блокировки по user-agent

Блокировка по user-agent — это блокировка, при которой сайт блокирует определенный user-agent, такого как Googlebot или AhrefsBot. Другими словами, сайт определяет конкретного бота и блокирует соответствующий user-agent.

Если вы можете просматривать страницу в своем обычном браузере, но блокируетесь после смены user-agent, это означает, что используемый вами user-agent заблокирован.

Вы можете задать конкретный user-agent с помощью инструментов разработчика Chrome. Еще один вариант — использовать расширение браузера для смены user-agent, подобное этому.

Кроме того, вы можете проверить блокировку по user-agent с помощью команды cURL. Вот как это сделать в Windows.

Как это исправить

Проверьте наличие блокировки по IP-адресу

Если вы подтвердили, что не заблокированы файлом robots.txt, и исключили блокировку по user-agent, то, скорее всего, это блокировка по IP-адресу.

Как это исправить

Блокировку по IP-адресу сложно отследить. Как и в случае с блокировкой по user-agent, лучше всего будет обратиться к вашему хостинг-провайдеру или CDN и спросить их, откуда происходит блокировка и как вы можете устранить ее.

Проиндексировано несмотря на блокировку в файле robots txt как исправить

Вы перечитайте, поймите суть проблемы.

Часто просто мы не сталкиваемся с не типичными проблемами где логики вообще нет.

Вот пример. Живет сайтик, была когда-то у него рубрика. Ну решили мы что нам она не нужна. Грохаем ее и естественно у нас все те страницы что были в рубрике теперь 404. Ну нет их больше же. Логично. Сайт живет, все норм. И скорее всего не ощутит ни каких проблем.

Но решили домен поменять, ну обычное дело, ничего криминального, клеим. УПС. На старый раздел было много ссылок из другого раздела и третьего раздела да и еще внешние ссылки имеются на удаленный раздел и попрежнему прекрасно ссылаются на него и гугл это видит.

Оформлено все по уму 404 как полагается, на ней все рекомендации гугла учтены, все как по книжке. Ну нет теперь у нас этого документа, а тот документ что ссылается говорит что было когда-то или думает что есть.

И тут начинается бред. Перечитываете хелп все что находите это смена кода ответа сервера с 404 на 410, а сама страница остается такой же.

Ну что? поможет? Если бы, на одном сайте год был фильтр. Как? Блин, за что? Где логика? Почему не убирает фильтр?

Не мучайтесь. 301 с битых ставьте на главную и пропингуйте гуглом. 7-10 дней и фильтра нет.

Что-то еще не нравиться? Ваши проблемы..

Вот он индексирует. Это не его проблема, это уже моя проблема. Он Титлы присвоил уже таким страницам. Типичный Титл который использует в ротации для сайта сейчас. А вот это уже серьезно.

Проиндексировано, несмотря на блокировку в файле robots.txt Есть решение

Google уже надоел всякими ошибками и предупреждениями. Теперь он выводит в вебмастере около 1000 страниц с предупреждением «Проиндексировано, несмотря на блокировку в файле robots.txt»

Все эти 1000 страниц мусора такого типа:

В роботсе запрещены страницы. Все эти страницы имеют

Но его это не останавливает и он продолжает их индексировать и выводить это предупреждение.

Кто нибудь знает, как решить такую проблему?

5 ответов

Возможно, этот совет поможет. Видимо, потребуется какой-то плагин для выполнения такой работы.

На самом деле в этом весь Гугл. Никакого уважения к robots.txt. Как вариант кроме robots.txt можно в index.html ввести что-то типа

Таким образом закроете сортировки в категориях. Для Yandex, кстати, лучше не закрывать, а сделать по Clean-param: sort&order.

Спасибо за помощь, поставил ваш код. Метатег появился на страницах с сортировкой.

Было бы странно, если бы не появился, но суть не в этом. Вы можете конкретизировать этот тег, заточив его под Гугл, изменив robots на указание для конкретного бота.

А уже для Yandex использовать в robots.txt более мягкий Clean-param (читайте документацию на Yandex) способ для sort&order. Из robots.txt всякие конструкции типа

можно будет убрать.

Про яндекс не совсем понятно. Во первых зачем такие страницы яндексу в поиске? Ну и он на данный момент не берет их в поиск, из за тега, который ссылается на основную категорию.

Проиндексировано, несмотря на блокировку в файле robots.txt

Публикация в группе : Warehouse

В консоле вебмастера google есть пункт меню «Основные интернет-показатели», в нем показываются ошибки и предупреждения разные, о них вы можете прочитать в помощи.

Последнее время google меняет правила очень кардинально и robots.txt уже не защитит сайт от дублей при некоторых условиях. Вот ссылочка о конкретно описываемой ситуации когда страницы будут проиндексированы, несмотря на запрет в robots.txt.

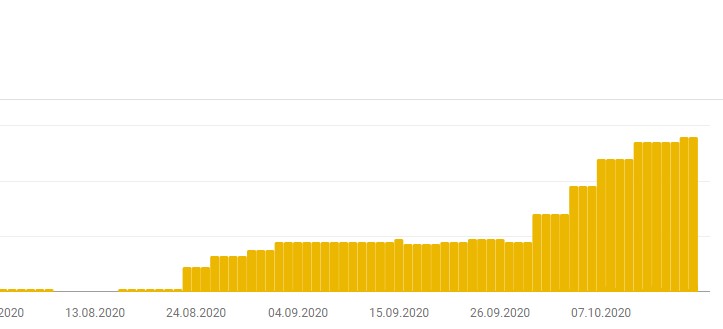

Если вы посмотрите в этот пункт меню консоли(открыв соответствующий отчет), вы можете увидеть такую картинку, конечно если ваш сайт уже продвинулся немного.

Название предупреждения: Проиндексировано, несмотря на блокировку в файле robots.txt

Растут такие страницы просто с дикой скоростью, в моем случаи большая часть ссылок имеет параметр ?action-rcl=login. Есть конечно и другие, но на этом параметре покажу пример, как избавится от таких дублей, так как и канонический урл в данном случаи не работает(маны гугла).

В файл функций вашей темы сайта надо добавить:

Возможны вариации конечно, можно вообще оставить только «?», но это уже по необходимости, как и добавить другие варианты ссылок от дополнений или плагинов.

В итоге, исходя из рекомендаций google, мы закрываем все дубли. После проделанной операции с добавлением кода, обязательно проверить, что все гладко и запрет появляется только на нужных страницах. Далее нажать на кнопку перепроверки в консоле и ошибки исчезнут со временем, придет оповещение на почту.

Таким образом индекс сайта будет чистым и не только для гугла, но и для яндекса. Единственная защита на сегодняшний день от дублей: