что такое графический чип

Графические процессоры в решении современных IT-задач

Графические процессоры (graphics processing unit, GPU) — яркий пример того, как технология, спроектированная для задач графической обработки, распространилась на несвязанную область высокопроизводительных вычислений. Современные GPU являются сердцем множества сложнейших проектов в сфере машинного обучения и анализа данных. В нашей обзорной статье мы расскажем, как клиенты Selectel используют оборудование с GPU, и подумаем о будущем науки о данных и вычислительных устройств вместе с преподавателями Школы анализа данных Яндекс.

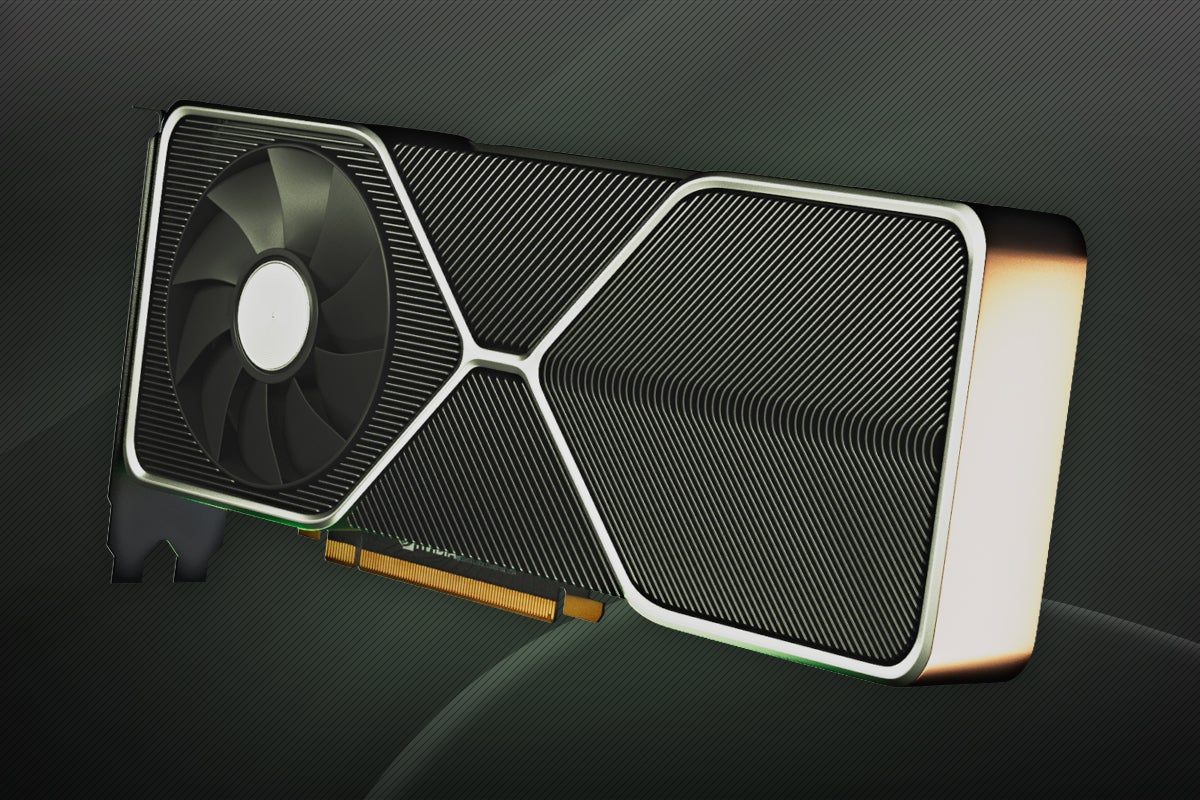

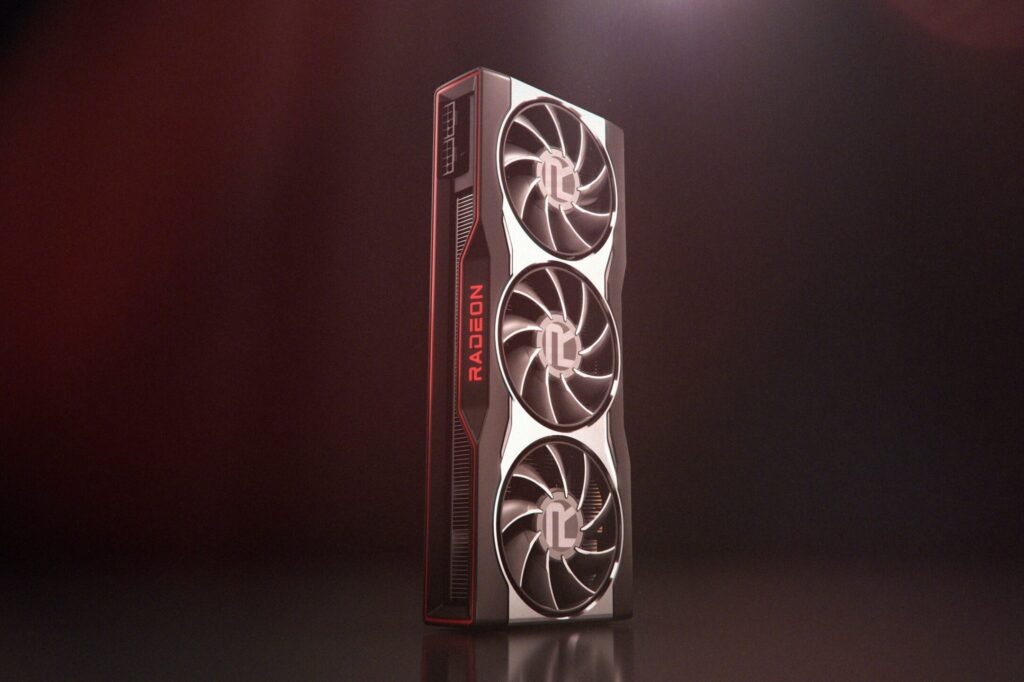

Графические процессоры за последние десять лет сильно изменились. Помимо колоссального прироста производительности, произошло разделение устройств по типу использования. Так, в отдельное направление выделяются видеокарты для домашних игровых систем и установок виртуальной реальности. Появляются мощные узкоспециализированные устройства: для серверных систем одним из ведущих ускорителей является NVIDIA Tesla P100, разработанный именно для промышленного использования в дата-центрах. Помимо GPU активно ведутся исследования в сфере создания нового типа процессоров, имитирующих работу головного мозга. Примером может служить однокристальная платформа Kirin 970 с собственным нейроморфным процессором для задач, связанных с нейронными сетями и распознаванием образов.

Подобная ситуация заставляет задуматься над следующими вопросами:

Эпоха GPU

Для начала вспомним, что же такое GPU. Graphics Processing Unit — это графический процессор широко используемый в настольных и серверных системах. Отличительной особенностью этого устройства является ориентированность на массовые параллельные вычисления. В отличие от графических процессоров архитектура другого вычислительного модуля CPU (Central Processor Unit) предназначена для последовательной обработки данных. Если количество ядер в обычном CPU измеряется десятками, то в GPU их счет идет на тысячи, что накладывает ограничения на типы выполняемых команд, однако обеспечивает высокую вычислительную производительность в задачах, включающих параллелизм.

Первые шаги

Развитие видеопроцессоров на ранних этапах было тесно связано с нарастающей потребностью в отдельном вычислительном устройстве для обработки двух и трехмерной графики. До появления отдельных схем видеоконтроллеров в 70-х годах вывод изображения осуществлялся через использование дискретной логики, что сказывалось на увеличенном энергопотреблении и больших размерах печатных плат. Специализированные микросхемы позволили выделить разработку устройств, предназначенных для работы с графикой, в отдельное направление.

Следующим революционным событием стало появление нового класса более сложных и многофункциональных устройств — видеопроцессоров. В 1996 году компания 3dfx Interactive выпустила чипсет Voodoo Graphics, который быстро занял 85% рынка специализированных видеоустройств и стал лидером в области 3D графики того времени. После серии неудачных решений менеджмента компании, среди которых была покупка производителя видеокарт STB, 3dfx уступила первенство NVIDIA и ATI (позднее AMD), а в 2002 объявила о своем банкротстве.

Общие вычисления на GPU

В 2006 году NVIDIA объявила о выпуске линейки продуктов GeForce 8 series, которая положила начало новому классу устройств, предназначенных для общих вычислений на графических процессорах (GPGPU). В ходе разработки NVIDIA пришла к пониманию, что большее число ядер, работающих на меньшей частоте, более эффективны для параллельных нагрузок, чем малое число более производительных ядер. Видеопроцессоры нового поколения обеспечили поддержку параллельных вычислений не только для обработки видеопотоков, но также для проблем, связанных с машинным обучением, линейной алгеброй, статистикой и другими научными или коммерческими задачами.

Признанный лидер

Различия в изначальной постановке задач перед CPU и GPU привели к значительным расхождениям в архитектуре устройств — высокая частота против многоядерности. Для графических процессоров это заложило вычислительный потенциал, который в полной мере реализуется в настоящее время. Видеопроцессоры с внушительным количеством более слабых вычислительных ядер отлично справляются с параллельными вычислениями. Центральный же процессор, исторически спроектированный для работы с последовательными задачами, остается лучшим в своей области.

Для примера сравним значения в производительности центрального и графического процессора на выполнении распространенной задачи в нейронных сетях — перемножении матриц высокого порядка. Выберем следующие устройства для тестирования:

В коде выше мы измеряем время, которое потребовалось на вычисление матриц одинакового порядка на центральном или графическом процессоре («Время выполнения»). Данные можно представить в виде графика, на котором горизонтальная ось отображает порядок перемножаемых матриц, а вертикальная — Время выполнения в секундах:

Линия графика, выделенная оранжевым, показывает время, которое требуется для создания данных в обычном ОЗУ, передачу их в память GPU и последующие вычисления. Зеленая линия показывает время, которое требуется на вычисление данных, которые были сгенерированы уже в памяти видеокарты (без передачи из ОЗУ). Синяя отображает время подсчета на центральном процессоре. Матрицы порядка менее 1000 элементов перемножаются на GPU и CPU почти за одинаковое время. Разница в производительности хорошо проявляется с матрицами размерами более 2000 на 2000, когда время вычислений на CPU подскакивает до 1 секунды, а GPU остается близким к нулю.

Более сложные и практические задачи эффективнее решаются на устройстве с графическими процессорами, чем без них. Поскольку проблемы, которые решают наши клиенты на оборудовании с GPU, очень разнообразны, мы решили выяснить, какие самые популярные сценарии использования существуют.

Кому в Selectel жить хорошо с GPU?

Первый вариант, который сразу приходит на ум и оказывается правильной догадкой — это майнинг, однако любопытно отметить, что некоторые применяют его как вспомогательный способ загрузить оборудование на «максимум». В случае аренды выделенного сервера с видеокартами, время свободное от рабочих нагрузок используется для добычи криптовалют, не требующих специализированных установок (ферм) для своего получения.

Ставшие уже в какой-то степени классическими, задачи, связанные с графической обработкой и рендерингом, неизменно находят свое место на серверах Selectel с графическими ускорителями. Использование высокопроизводительного оборудования для таких задач позволяет получить более эффективное решение, чем организация выделенных рабочих мест с видеокартами.

В ходе разговора с нашими клиентами мы также познакомились с представителями Школы анализа данных Яндекс, которая использует мощности Selectel для организации тестовых учебных сред. Мы решили узнать побольше о том, чем занимаются студенты и преподаватели, какие направления машинного обучения сейчас популярны и какое будущее ожидает индустрию, после того как молодые специалисты пополнят ряды сотрудников ведущих организаций или запустят свои стартапы.

Наука о данных

Пожалуй, среди наших читателей не найдется тех, кто не слышал бы словосочетания «нейронные сети» или «машинное обучение». Отбросив маркетинговые вариации на тему этих слов, получается сухой остаток в виде зарождающейся и перспективной науки о данных.

Современный подход к работе с данными включает в себя несколько основных направлений:

Граница между данными направления постепенно стирается: основные инструменты для работы с большими данным (Hadoop, Spark) внедряют поддержку вычислений на GPU, а задачи машинного обучения охватывают новые сферы и требуют бо́льших объемов данных. Разобраться подробнее нам помогут преподаватели и студенты Школы анализа данных.

Трудно переоценить важность грамотной работы с данными и уместного внедрения продвинутых аналитических инструментов. Речь идёт даже не о больших данных, их «озерах» или «реках», а именно об интеллектуальном взаимодействии с информацией. Происходящее сейчас представляет собой уникальную ситуацию: мы можем собирать самую разнообразную информацию и использовать продвинутые инструменты и сервисы для глубокого анализа. Бизнес внедряет подобные технологии не только для получения продвинутой аналитики, но и для создания уникального продукта в любой отрасли. Именно последний пункт во многом формирует и стимулирует рост индустрии анализа данных.

Новое направление

Повсюду нас окружает информация: от логов интернет-компаний и банковских операций до показаний в экспериментах на Большом адронном коллайдере. Умение работать с этими данными может принести миллионные прибыли и дать ответы на фундаментальные вопросы о строении Вселенной. Поэтому анализ данных стал отдельным направлением исследований среди бизнес и научного сообщества.

Школа анализа данных готовит лучших профильных специалистов и ученых, которые в будущем станут основным источником научных и индустриальных разработок в данной сфере. Развитие отрасли сказывается и на нас как на инфраструктурном провайдере — все больше клиентов запрашивают конфигурации серверов для задач анализа данных.

От специфики задач, стоящих перед нашими клиентами, зависит то, какое оборудование мы должны предлагать заказчикам и в каком направлении следует развивать нашу продуктовую линейку. Совместно со Станиславом Федотовым и Олегом Ивченко мы опросили студентов и преподавателей Школы анализа данных и выяснили, какие технологии они используют для решения практических задач.

Технологии анализа данных

За время обучения слушатели от основ (базовой высшей математики, алгоритмов и программирования) доходят до самых передовых областей машинного обучения. Мы собирали информацию по тем, в которых используются серверы с GPU:

Представленные инструменты обладают разной поддержкой от создателей, но тем не менее, продолжают активно использоваться в учебных и рабочих целях. Многие из них требуют производительного оборудования для обработки задач в адекватные сроки.

Дальнейшее развитие и проекты

Как и любая наука, направление анализа данных будет изменяться. Опыт, который получают студенты сегодня, несомненно войдет в основу будущих разработок. Поэтому отдельно стоит отметить высокую практическую направленность программы — некоторые студенты во время учебы или после начинают стажироваться в Яндексе и применять свои знания уже на реальных сервисах и службах (поиск, компьютерное зрение, распознавание речи и другие).

О будущем анализа данных мы поговорили с преподавателями Школы анализа данных, которые поделились с нами своим видением развития науки о данных.

По мнению Влада Шахуро, преподавателя курса «Анализ изображений и видео», самые интересные задачи в компьютерном зрении — обеспечение безопасности в местах массового скопления людей, управление беспилотным автомобилем и создание приложение с использованием дополненной реальности. Для решения этих задач необходимо уметь качественно анализировать видеоданные и развивать в первую очередь алгоритмы детектирования и слежения за объектами, распознавания человека по лицу и трехмерной реконструкции наблюдаемой сцены. Преподаватель Виктор Лемпицкий, ведущий курс «Глубинное обучение», отдельно выделяет в своем направлении автокодировщики, а также генеративные и состязательные сети.

Один из наставников Школы анализа данных делится своим мнением касательно распространения и начала массового использования машинного обучения:

«Машинное обучение из удела немногих одержимых исследователей превращается в ещё один инструмент рядового разработчика. Раньше (например в 2012) люди писали низкоуровневый код для обучения сверточных сетей на паре видеокарт. Сейчас, кто угодно может за считанные часы:

По мнению Ивченко Олега, администратора серверной инфраструктуры ШАД, для стандартных задач глубокого обучения на стандартных наборах данных (например, CIFAR, MNIST) требуются такие ресурсы:

Возможности для новичков

Изучение анализа данных ограничивается высокими требованиями к обучающимся: обширные познания в области математики и алгоритмики, умение программировать. По-настоящему серьезные задачи машинного обучения требуют уже наличия специализированного оборудования. А для желающих побольше узнать о теоретической составляющей науки о данных Школой анализа данных совместно с Высшей Школой Экономики был запущен онлайн курс «Введение в машинное обучение».

Вместо заключения

Рост рынка графических процессоров обеспечивается возрастающим интересом к возможностям таких устройств. GPU применяется в домашних игровых системах, задачах рендеринга и видеообработки, а также там, где требуются общие высокопроизводительные вычисления. Практическое применение задач интеллектуального анализа данных будет проникать все глубже в нашу повседневную жизнь. И выполнение подобных программ наиболее эффективно осуществляется именно с помощью GPU.

Мы благодарим наших клиентов, а также преподавателей и студентов Школы анализа данных за совместную подготовку материала, и приглашаем наших читателей познакомиться с ними поближе.

А опытным и искушенным в сфере машинного обучения, анализа данных и не только мы предлагаем посмотреть предложения от Selectel по аренде серверного оборудования с графическми ускорителями: от простых GTX 1080 до Tesla P100 и K80 для самых требовательных задач.

Что такое GPU и в чём разница между видеокартой

Для проведения вычислительных операций в каждом современном компьютере предусмотрен не только центральный, но ещё и графический процессор (GPU). Последний преимущественно используется для отрисовки графики.

В этой статье разберёмся, какие бывают графические процессоры, чем они отличаются GPU от видеокарт, а также как узнать, какой именно GPU установлен в ПК или ноутбуке.

Что такое GPU

Что такое GPU в компьютере и для чего он используется

GPU это вспомогательный микрочип, который берёт часть вычислительных операций на себя вместо процессора. И за счёт специализированной архитектуры, GPU лучше подходит для проведения расчётов с плавающей точкой, тогда как CPU больше ориентирован на работу в многопоточном режиме.

То есть видеокарта GPU способна быстро проводить расчёты, где используется одна или схожая формула (например, вычисление точки затенения графики при попадании тени на текстуру). Центральный процессор же ориентирован на проведение расчётов сразу в несколько потоков, когда пользователь работает одновременно с большим количеством приложений.

Графический процессор и видеокарта одно и то же

Многие считают, что графический процессор (GPU) и видеокарта — это синонимы. Но это — ошибочное мнение. Графический процессор (GPU) — это микрочип, который представляет собой кремниевый кристалл. Визуально схож на CPU. Но архитектура GPU кардинально отличается от той, что используется в обычном центральном процессоре. В видео это объясняется простым языком

Видеокарта — это плата, которая включает в себя графический процессор, оперативную память, линию питания, шлюз для обмена информации (по линии PCI Express), а также набор видеовыходов для подключения мониторов.

То есть GPU — это часть видеокарты. С технической стороны, видеоадаптер — это мини-компьютер. Ведь у него есть собственный процессор (графический), ОЗУ, шина данных.

Что такое интегрированный графический процессор

Видеокарты вплоть до 2005 года выпускались в форме отдельной платы, подключаемой к материнской плате компьютера или ноутбука. Но затем графические процессоры (GPU) начали интегрировать в CPU, такие кристаллы принято обозначать как iGPU.

У них нет собственной оперативной памяти или кэша. Соответственно, при отрисовке графики они резервируют часть имеющейся в компьютере ОЗУ.

Также интегрированные GPU менее производительные. И за счет этого — потребляют в десятки раз меньше электроэнергии. Именно поэтому их чаще всего и используют в производстве недорогих ноутбуков, портативной техники.

Что такое графический процессор(GPU), интегрированный в CPU с технической точки зрения? Это отдельный кремниевый микрочип, который находится на одной плате («подложке») с центральным процессором. То есть он работает отдельно, хоть и использует ту же самую линию питания, что и CPU.

Как узнать какой GPU в компьютере

Узнать, какой графический чип установлен в ПК, дискретный или интегрированный можно двумя способами:

Есть нюанс: во многих современных ноутбуках устанавливается одновременно и интегрированная, и дискретная видеокарта. По умолчанию используется iGPU. А дискретный GPU задействуется в тех ситуациях, когда производительности iGPU недостаточно (например, при запуске видеоигры, приложения для видеомонтажа).

Графический процессор GPU при выполнении расчётов довольно сильно нагревается. Это специфика кремниевых кристаллов.

Температура свыше 100 градусов существенно ускоряет деградацию кремниевого кристалла. И именно перегрев — одна из самых распространённых причин выхода из строя видеокарт.

А для тестирования можно воспользоваться бесплатной утилитой Furmark.

Что делать, если температура в нагрузке CPU слишком высокая? Подробно описано здесь

Что такое дискретный графический процессор

Дискретный графический процессор — это тот, который устанавливается отдельно от CPU. Поставляется в форме платы, чаще всего — с портом PCI Express для подключения к материнской плате.

Недостатки встроенного GPU в компьютере

Ключевые недостатки интегрированных графических процессоров (iGPU):

Но есть у iGPU и весомое преимущество. Это малое энергопотребление.

Для сравнения, видеокарта GPU Nvidia Geforce последнего поколения потребляет порядка 300 Вт в нагрузке. Интегрированный графический процессор — порядка 3 – 10 Вт (в зависимости от модели видеокарты). Также следует упомянуть, что в игровых приставках последних поколений (XBOX, PlayStation), а также в портативной игровой консоли Steam Deck используются именно iGPU.

Аналитики вообще считают, что в ближайшие 10 – 20 лет дискретные видеокарты вообще станут невостребованными и их производство вовсе прекратят.

Итого, в каждом ПК или ноутбуке устанавливается два процессора, один из которых — графический( GPU). Интегрированные iGPU отлично подходят для «офисных» ПК, тогда как с дискретными GPU — для игровых компьютеров или так называемых «графических станций». А какая видеокарта установлена в вашем ПК или ноутбуке? Расскажите об этом в комментариях.

Графическое ядро в процессоре: что это такое и зачем оно в компьютере?

GPU переводится как Graphics Processing Unit, по факту это отдельный небольшой компонент компьютера, который несет ответственность за обработку видеографики. GPU на компьютере — это отдельный небольшой микрочип, который может быть:

GPU в компьютере — что это такое?

Не нужно путать GPU в компьютере с видеокартой, потому что GPU — это небольшой микрочип для обрабатывания графики, а видеокарта — это уже полноценное отдельное устройство. GPU является частью видеокарты. Когда GPU в компьютере размещается как отдельный микрочип, тогда его именуют графическим процессором. А если GPU интегрирован в процессор или материнскую плату, то в этом случае его часто называют встроенным или интегрированным графическим ядром.

Графическое ядро в процессоре

Процессор — это небольшой микрочип, который устанавливается на материнскую плату ; это не «весь компьютер», как считают некоторые. Мы уже знаем, что такое GPU в компьютере и как это может быть организовано.

С видеокартой как бы ясно — это отдельное устройство, которое можно купить в магазине и установить в свой ПК. Хорошая видеокарта стоит недешево. Она занимает отдельное место в материнской плате и греется при своей работе.

Графическое ядро в процессоре — это та же видеокарта, только более простая и минимизированная. Оно не занимает отдельного места в материнской плате, так как находится внутри самого процессора. Как правило, такие ядра могут быть менее мощными, чем стационарные видеокарты. Но со своей основной целью — выводить изображение на экран компьютера — они справляются на «отлично». Поэтому такие процессоры рекомендуется применять в офисных компьютерах, где нет больших нагрузок на GPU.

Для чего нужно такое «объединение»?

Такое «объединение» несет в себе 3 задачи:

То есть такая компоновка с центральным процессором существенно разгружает саму материнскую плату. А отсутствие отдельной видеокарты позволяет создавать устройства того же размера, но с увеличенной мощностью.

Недостатки встроенного ГП в компьютере

Встроенный графический процессор обладает рядом собственных недостатков:

Заключение

Мы будем очень благодарны

если под понравившемся материалом Вы нажмёте одну из кнопок социальных сетей и поделитесь с друзьями.

Что такое графический процессор?

Независимо от того, купили ли вы компьютер, консоль или даже смартфон, вы наверняка встречали термин GPU, но что такое графический процессор?

Что такое графический процессор?

Графический процессор (графический процессор) — это компонент, отвечающий за создание изображений для вашего компьютера. Без какого-либо графического процессора, установленного на вашем компьютере, он даже не смог бы отображать ваш домашний экран Windows.

Графические процессоры оснащены не только компьютерами, но и консолями, смартфонами и планшетами. По сути, любое устройство, способное отображать трехмерную графику на экране, скорее всего, будет иметь какой-то графический процессор.

Что делает графический процессор?

Графические процессоры ускоряют рендеринг 3D-графики. Это полезно для многих рабочих нагрузок.

Они, вероятно, наиболее известны в играх, поскольку от них требуется одновременный рендеринг нескольких сложных анимаций. Однако графические процессоры также широко используются в творческих целях, таких как редактирование видео, создание 3D-моделей и многое другое. Мощный графический процессор — это ключевое отличие MacBook Pro от MacBook Air.

Графические процессоры также используются в центрах обработки данных, что позволяет заниматься облачными играми, потоковой передачей видео и кодированием видео. Их также можно использовать для майнинга биткойнов, хотя такие компании, как Nvidia, недавно пытались заблокировать такое использование на своих графических процессорах GeForce.

Вы могли бы…

Что такое iGPU?

Есть два типа графических процессоров. Первый — это iGPU (интегрированный графический процессор), который представляет собой графический процессор, встроенный в процессор.

Как правило, они не очень мощные и предназначены для основных задач рендеринга, а не для игр и 3D-анимации. Тем не менее, AMD и Intel в последние годы улучшают свои iGPU, чтобы повысить производительность для требовательных рабочих нагрузок.

Если вы покупаете настольный процессор без видеокарты, то стоит убедиться, что он действительно оснащен встроенным графическим процессором, так как это не всегда так.

Что такое dGPU?

Второй тип графического процессора — это dGPU (блок обработки дискретной графики). Это компонент, который находится внутри видеокарты для настольных систем или в качестве специального чипа в ноутбуках высокого класса. Дискретный графический процессор обычно значительно мощнее, чем iGPU, и специализируется на рендеринге расширенной графики для игр и создания контента.

Однако у дискретных графических процессоров есть загвоздка, поскольку им требуется специальная система охлаждения, чтобы максимизировать производительность и предотвратить ее перегрев. К сожалению, это означает, что игровые ноутбуки обычно намного тяжелее стандартных ноутбуков только с iGPU. Дискретные графические процессоры также имеют высокое энергопотребление, что значительно сокращает время автономной работы.

Дискретные графические процессоры также повышают стоимость ноутбука, в то время как высокопроизводительные настольные графические процессоры обычно являются самым дорогим компонентом при сборке ПК — самая дешевая видеокарта в последней серии 30 от Nvidia стоит 299 фунтов стерлингов / 329 долларов. Из-за этого дискретный графический процессор рекомендуется только в том случае, если он вам нужен, например, для игр, создания контента или других интенсивных рабочих нагрузок.

Что такое видеокарта?

Существует много путаницы в различиях между графическим процессором и видеокартой, поскольку эти два термина часто используются как синонимы.

Графический процессор — это фактический чип, который выполняет всю тяжелую работу. Графический процессор установлен внутри видеокарты.

Графическая карта — это «карта расширения», которая позволяет графическому процессору подключаться к материнской плате и выводить изображение на ваш монитор. Видеокарты также могут иметь дополнительное оборудование, такое как система охлаждения и собственная выделенная оперативная память.

В то время как AMD и Nvidia производят графические процессоры, сторонние производители, такие как Asus и Gigabyte, продают свои собственные видеокарты, на которых размещены эти графические процессоры, предлагая уникальные конструкции и системы охлаждения.

Графическая карта и графический процессор имеют аналогичное отношение к процессору и материнской плате: первая обеспечивает всю вычислительную мощность, а вторая занимается логистикой.

Почему видеокарт нет в наличии?

Если вы пытались купить видеокарту в 2021 году, вы, вероятно, поняли, что их всех нет в наличии. На это есть несколько причин.

Глобальная цепочка поставок графических процессоров пострадала, когда поразил Covid-19, в результате чего многие фабрики были закрыты, а несколько стран закрыли границы. В то время как производство графических процессоров замедлилось, спрос резко вырос, поскольку во время пандемии резко выросли продажи ноутбуков и видеокарт.

Все это было очень плохим моментом для рынка графических процессоров, поскольку AMD и Nvidia выпустили свое новое поколение видеокарт в 2021 году, а PS5 и Xbox Series X также появятся в магазинах. Это существенно увеличило спрос.

И давайте не будем забывать о майнерах криптовалюты, так как многие люди покупали партии видеокарт, чтобы добывать биткойны в надежде получить прибыль.

Многие люди, известные как скальперы, также воспользовались нехваткой консолей и видеокарт, покупая их оптом, а затем продавая по завышенным ценам с целью получения прибыли. Это еще больше затрудняло покупку видеокарты в те редкие моменты, когда у розничных продавцов появлялись новые запасы.

Есть надежда, что нехватка видеокарт может закончиться до конца года, но при таком большом количестве факторов в этом трудно быть уверенным.

Если вы хотите купить новую видеокарту, ознакомьтесь с нашим списком лучших видеокарт и таблицей всех наших данных о производительности ниже.