Что важнее в видеокарте частота или объем памяти

На что влияет частота памяти видеокарты

Видеопамять — одна из самых главных характеристик видеокарты. Она имеет очень сильное влияние на общую производительность, качество выдаваемой картинки, её разрешение, и главным образом на пропускную способность видеокарты, о которой вы узнаете, прочитав данную статью.

Влияние частоты видеопамяти

Специальная встроенная в видеокарту оперативная память называется видеопамятью и в своей аббревиатуре вдобавок к DDR (удвоенная передача данных) содержит букву G в начале. Это даёт понять, что речь идёт именно о GDDR (графическая удвоенная передача данных), а не о каком-то другом типе оперативной памяти. Данный подтип ОЗУ обладает более высокими частотами по сравнению с обычной оперативной памятью, установленной в любой современный компьютер, и обеспечивает достаточное быстродействие графического чипа в целом, давая ему возможность работать с большими объёмами данных, которые нужно обработать и вывести на экран пользователя.

Пропускная способность памяти

Тактовая частота видеопамяти непосредственно влияет на её пропускную способность (ПСП). В свою очередь, высокие значения ПСП часто помогают добиться лучших результатов в производительности большинства программ, где необходимо участие или работа с 3D-графикой — компьютерные игры и программы для моделирования и создания трёхмерных объектов являются подтверждением данному тезису.

Ширина шины памяти

Тактовая частота видеопамяти и её влияние на производительность видеокарты в целом находится в прямой зависимости от другого, не менее важного компонента графических адаптеров — ширины шины памяти и её частоты. Из этого следует, что при выборе графического чипа для вашего компьютера необходимо обращать внимание и на эти показатели, чтобы не разочароваться в общем уровне производительности своей рабочей или игровой компьютерной станции. При невнимательном подходе легко попасть на удочку маркетологов, установивших в новый продукт своей компании 4 ГБ видеопамяти и 64-битную шину, которая будет очень медленно и неэффективно пропускать через себя такой огромный поток видеоданных.

Необходимо соблюдение баланса между частотой видеопамяти и шириной её шины. Современный стандарт GDDR5 позволяет сделать эффективную частоту видеопамяти в 4 раза большей от её реальной частоты. Можете не переживать, что вам постоянно придётся осуществлять подсчёты эффективной производительности видеокарты в голове и держать эту простую формулу умножения на четыре в уме — производитель изначально указывает умноженную, то есть настоящую частоту памяти видеокарты.

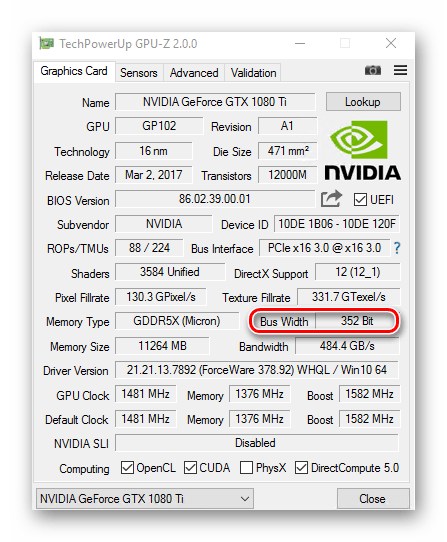

В обычных, не предназначенных для специальных вычислений и научной деятельности графических адаптерах используются шины памяти от 64 до 256 бит шириной. Также в топовых игровых решениях может встретиться шина шириной в 352 бита, но одна только цена подобной видеокарты может составлять стоимость полноценного ПК средне-высокого уровня производительности.

Если вам нужна «затычка» под слот для видеокарты на материнской плате для работы в офисе и решения исключительно офисных задач по типу написания отчёта в Word, создания таблицы в Excel (ведь даже просмотр видео с такими характеристиками будет затруднителен), то вы можете с уверенностью приобретать решение с 64-битной шиной.

В любых других случаях необходимо обращать внимание на 128-битную шину или 192, а лучшим и самым производительным решением будет шина памяти в 256 бит. Такие видеокарты в большинстве своём имеют достаточный запас видеопамяти с высокой её частотой, но бывают и недорогие исключения с 1 ГБ памяти, чего для сегодняшнего геймера уже недостаточно и надо иметь как минимум 2 ГБ карточку для комфортной игры или работы в 3D-приложении, но тут уж можно смело следовать принципу «чем больше, тем лучше».

Расчёт ПСП

К примеру, если у вас есть видеокарта оснащённая памятью GDDR5 с эффективной тактовой частотой памяти 1333 МГц (чтобы узнать реальную частоту памяти GDDR5, необходимо эффективную поделить на 4) и с 256-битной шиной памяти, то она будет быстрее видеокарты с эффективной частотой памяти 1600 Мгц, но с шиной в 128 бит.

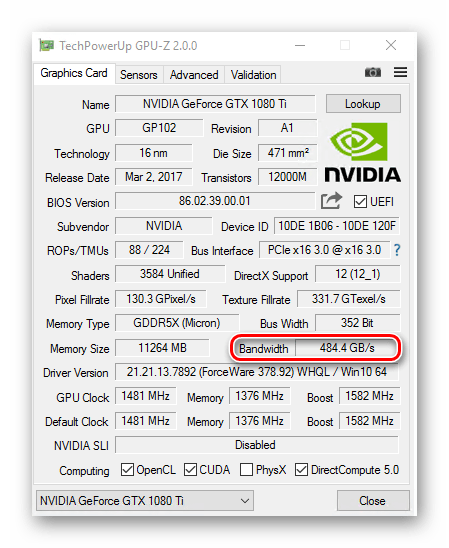

Чтобы рассчитать пропускную способность памяти и затем узнать, насколько производительный у вас видеочип, необходимо прибегнуть к данной формуле: ширину шины памяти умножаем на частоту памяти и полученное число делим на 8, ведь именно столько бит в байте. Полученное число и будет нужным нам значением.

Вернёмся к нашим двум видеокартам из примера выше и рассчитаем их пропускную способность: у первой, лучшей видеокарты, но с меньшим показателем тактовой частоты видеопамяти она будет следующей — (256*1333)/8 = 42,7 ГБ в секунду, а у второй видеокарты всего лишь 25,6 ГБ в секунду.

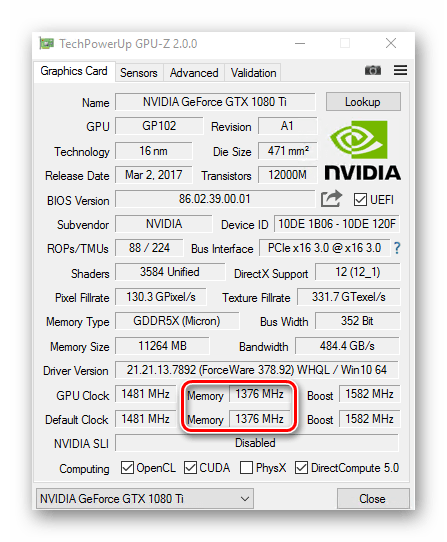

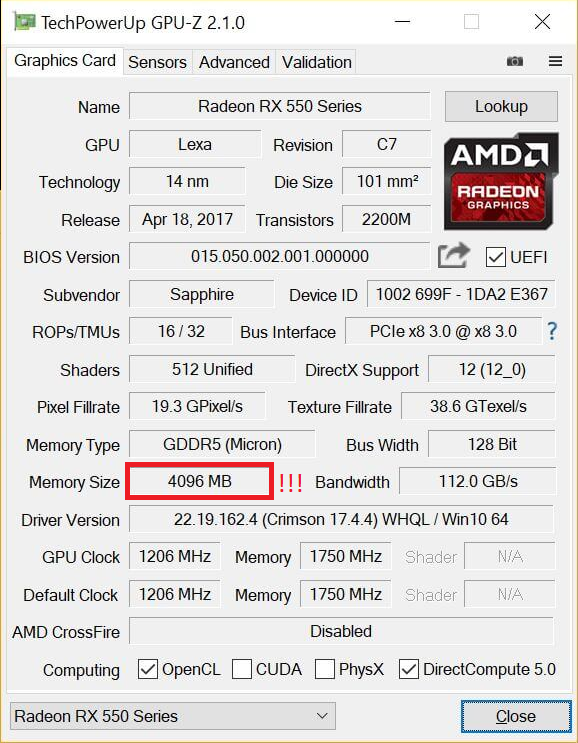

Вы также можете установить программу TechPowerUp GPU-Z, которая способна выводить развёрнутую информацию об установленном в ваш компьютер графическом чипе, в том числе и объём видеопамяти, её частоту, битность шины и пропускную способность.

Вывод

Исходя из информации выше, можно понять, что частота видеопамяти и её влияние на эффективность работы находится в прямой зависимости от ещё одного фактора — ширины памяти, вместе с которой они создают значение пропускной способности памяти. Она и влияет на скорость и количество передаваемых данных в видеокарте. Надеемся, что эта статья помогла вам узнать что-то новое о строении и работе графического чипа и дала ответы на интересующие вопросы.

Помимо этой статьи, на сайте еще 12544 инструкций.

Добавьте сайт Lumpics.ru в закладки (CTRL+D) и мы точно еще пригодимся вам.

Отблагодарите автора, поделитесь статьей в социальных сетях.

Частота или объем памяти — что важнее в видеокарте?

Всем привет! Сегодня обсудим, что важнее в видеокарте — частота или объем памяти, какому параметру отдать предпочтение, если придется выбирать, на что еще обратить внимание. Речь пойдет о дискретной видеокарте. Про влияние частоты GPU еще можно почитать вот тут.

Параметры графического адаптера и взаимосвязь его элементов

Среди людей, которые с компьютером «на Вы», одним из предметом сравнительной фаллометрии является объем видеопамяти на компьютере. Не хочу некого обидеть, но подход это совершенно ламерский.

Гарантирую, что GTX 1060 с 3 Гб видеопамяти намного лучше тянет игры, чем GTX 1050 Ti с 4 Гб. Все дело в характеристиках, в которых начинающий пользвоатель не считает нужным разобраться.

Итак, из чего состоят видеоадаптер:

Его мощность, то есть частота, а также количество ядер CUDA, определяет, насколько быстро он будет рендерить графику и, в конечном итоге, какими будут FPS и качество прорисовок в играх. Самый важный компонент, вокруг которого «танцуют» инженеры, подбирая прочие компоненты при проектировании новой модели.

Хранит все промежуточные данные, которые обрабатывает GPU. От ее скорости зависит, насколько быстро информация будет записана и прочитана графическим процессором. Объем определяет, сколько данных поместится одновременно.

Канал, по которому память и графический чип обмениваются информацией. От его ширины, или так называемой разрядности, в целом зависит эффективность работы компонентов. При прочих неплохих характеристиках, но узком канале, графика будет ненавязчиво лагать.

Прочие компоненты, такие как внешнее питание и система охлаждения, упоминать не буду, так как к рассматриваемой теме они не относятся.

Как себя ведет видеокарта в нештатных ситуациях

Параметры перечисленных выше компонентов косвенно связаны, так как инженеры AMD или Nvidia учитывают их при создании новой модели. Замечен за ними «грешок», когда в силу непонятных мне причин при неплохих GPU и GDDR используется слишком узкая шина данных.

Реализовать свой потенциал деталь толком не может, так как компоненты не успевают обменяться данными. При прочих равных параметрах берите видеоадаптер с шиной большей битности.

Хочу акцентировать ваше внимание, что игровая локация и все ее содержимое, а конкретнее объекты, хранится в оперативной памяти компа, но не видеопамяти. GDDR хранит более примитивные базовые объекты — например, текстуры. Грубо говоря, «краску», которой обработаны прозрачные 3D модели.

Графический чип каждый раз заново рендерит игровой мир, который окружает вашего персонажа. За пределами поля видимости ничего нет.

Если запустить требовательную игру на компе со слабым видеоадаптером, можно заметить, что текстуры построек или НПС не успевают загрузиться из памяти, поэтому с задержкой рисуются графическим адаптером. Процесс загрузки вызывает микро фризы, то есть небольшие рывки. Фактически, не хватает скорости заново «собрать мир», детали для которого хранятся в памяти.

Если же объема видеопамяти мало, те объекты, которые не поместились в видеопамяти, GPU напрямую считывает из ОЗУ, а если их и там нет, то уже с жесткого диска, что занимает чуть больше времени. Однако и лечатся такие лаги элементарно: достаточно снизить качество текстур, и соответственно, их объем, чтобы все поместилось в видеопамяти.

В случае с медленной работой GDDR все немного сложнее: частоту нужно разгонять, если вы хотите поиграть без микрофризов. Как геймер со стажем, гарантирую что лучше, если игра вылетит пару раз за вечер на рабочий стол из-за нехватки GDDR и RAM, чем гробить остатки нервов постоянными лагами игры.

Недостающий объем видеопамяти компьютер при необходимости может задействовать из ОЗУ. В случае нехватки частоты взять дополнительную не от куда — только разгонять видеоадаптер с помощью специального софта.

Поэтому если стоит выбор, рекомендую отдать предпочтение частоте видеопамяти, а не ее объему. Детальнее о том, как устроена вся эта кухня, вы можете почитать в статье «Какие функции выполняет видеокарта в ПК и за что она отвечает?».

Подписывайтесь на меня в социальных сетях, чтобы не пропускать уведомления о новых публикациях в моем блоге. До скорой встречи!

Как правильно подобрать видеокарту для игр

Многие содержат компьютер в топовом или предтоповом состоянии. Каждый геймер подбирает «железо», которое «потянет» новые игры.

На рынке существует два лидера среди производителей видеокарт – Nvidia и AMD/ATI. Сегодня мы разберемся, как правильно подобрать «видюху».

Для положительного игрового опыта требуется хорошая графическая плата, поддерживающая современные технологии. Но что делать, если наших средств недостаточно на топовую видеокарту? Попытаемся разобраться, как выбрать «годный» вариант.

Часть пользователей уверена что дорогая карта – лучшая, но это не так. Вот живой пример:

Ну и как же тогда мне выбрать игровую видеокарту

А делается это по ряду параметров:

Графический процессор

От его мощности зависит скорость перемещения картинок на экране. Соответственно, чем больше, тем лучше.

Shader Model

«Шейдер» – технология обработки графического изображения, применяемая для построения сложных отражений, отблесков и освещения в играх.

Shader Model определяет количество «шейдеров», обрабатываемых процессором. Он чем-то напоминает номер прошивки на айфоне, но обновляется только на аппаратном уровне. То есть, чем новее карта, тем новее параметр. С каждой новой игрой количество «шейдеров» в коде возрастает.

Тип графической памяти

Этим параметром определяется частота работы видеокарты. Он играет важную роль в производительности программ. Всего их 5 типов: DDR, GDDR2, GDDR3, GDDR4 и GDDR5. Чем выше номер, тем быстрее будет происходить чтение/запись данных в плату.

Объём локальной видеопамяти

Это параметр, на котором строится практически вся маркетинговая система в игровой индустрии. Незнающие люди гонятся за бОльшим количеством гигабайт в современных графических платах.

От него зависит количество данных, которые можно хранить в ОЗУ устройства. На примере – качество и размер текстур в играх. Чем больше объём, тем больше деталей сохранится в памяти видеокарты.

Основным же показателем будет выступать частота работы процессора в плате, потому что он отвечает за её производительность. Частенько на дешёвые «видюхи» ставят 2-3 ГБ памяти, чтобы нарисовать красивые цифры на коробках, а на деле показать низкий FPS (Framerate Per Second).

Шина данных

Тут уже определяется скорость обмена информацией между видеопроцессором и памятью. Сейчас ширина шины варьируется: 64 – 512 бит. Чем выше пропускная способность, тем больше информации можно по ней передать. Разделить этот показатель можно на 3 категории:

DirectX

DirectX – набор API для решения задач, связанных с программированием под Windows. Чем выше этот показатель, тем больше современных технологий используется при создании видеоигр. От него же зависит качество и красота «картинки» в них.

Система охлаждения

При выборе платы стоит обратить внимание на количество вентиляторов и на скорость их вращения. Лучшим показателем в последнем случае будет 1200-1500 оборотов в минуту. Кроме того, обязательно необходим радиатор, выводящий тепло наружу.

Как на практике

Рассмотрим несколько вариантов сравнения различных видеокарт.

Пример #1

Начнём с Nvidia GeForce GTX 760 и 960.

FPS в играх на платах 7 и 9 поколений проверялся в 16 играх: Dying Light, Dragon Age: Inquisition, The Crew и прочих. «Фреймрейт» практически не отличается, за исключением нескольких моментов. Почему так? Сравним технические характеристики видеокарт:

GeForce GTX 760 – GeForce GTX 960

Частота графического процессора: 1006 МГц – 1253 МГц

Объём локальной видеопамяти: 2048 Мб – 2048 Мб

Шина данных: 256 бит – 128 бит

Средняя цена: 13 000 рублей – 23 000 рублей

По этим трём показателям уже видно, что переплачивать 4-5 тыс. рублей ради чуть более плавной работы игрушек не стоит. Более низкая частота процессора компенсируется пропускной способностью видеокарты.

Пример #2

Теперь рассмотрим GTX 780 Ti, 970 и 980. Тест на производительность проводился в РПГ «Ведьмак 3: Дикая охота».

И на этот раз мы видим, что разогнанная 780 Ti выдаёт идентичные результаты в FPS-тестах, что и 970 модель. Отличие на 3-4 кадра/сек. А тут что сыграло роль?

GeForce GTX 780 Ti – 970

Частота графического процессора: 1163 МГц – 1178 МГц

Объём локальной видеопамяти: 4 ГБ – 4 ГБ

Шина данных: 256 бит – 256 бит

Частота памяти: 7240 МГц – 7000 МГц

Средняя цена: 15 500 рублей – 21 000 рублей

Удивительно, но характеристики обеих видеоплат почти одинаковые, что и даёт примерно схожие показатели производительности в играх. NVIDIA GeForce GTX 980 выигрывает из-за поддержки бОльших технологий, чем её предшественница.

В грядущих играх ожидается поддержка DirectX 12.0. Разработчики обещают «огромный» прирост FPS за счёт оптимизации ПО. Видеокарты 900 серии уже поддерживают новый стандарт.

Вместо итога

Хотелось бы посоветовать нескольких производителей, зарекомендовавших себя временем. К ним относятся: Asus, GigaByte, Sapphire и MSI. Видеокарты от Nvidia потребляют меньше энергии, чем от AMD/ATI. Они работают тише, холоднее и лучше разгоняются. Но об этом в другой статье.

12 мифов о видеокартах, про которые пора забыть

В предыдущих статьях мы поговорили про мифы о процессорах, оперативной памяти и материнских платах, теперь же перейдем к видеокартам, которые уже давно стали обязательной частью любого компьютера.

Первый миф. Чем больше видеопамяти — тем быстрее видеокарта

Казалось бы, это логично — в более мощные видеокарты ставится больше памяти: так, GTX 1070 с 8 ГБ памяти быстрее, чем GTX 1060 с 6 ГБ, а GTX 1080 Ti с 11 ГБ быстрее GTX 1080 с 8 ГБ. Однако следует понимать, что видеопамять, конечно, важна, но зачастую различное ПО не использует всю имеющуюся у видеокарты память: так, в большинстве случаев GTX 1060 с 3 ГБ медленнее версии с 6 ГБ всего на 5-10%, и разница в основном идет из-за различного числа CUDA-ядер.

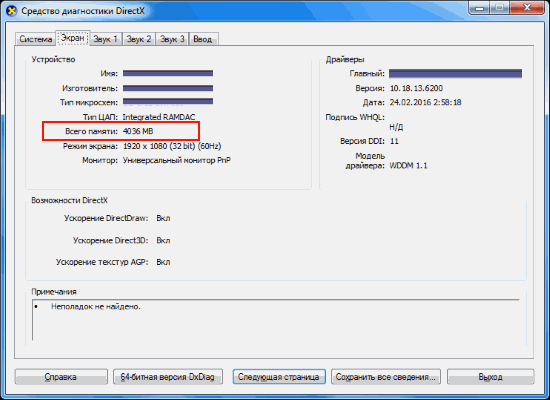

Но есть производители видеокарт, которые решили воспользоваться этим мифом в свою пользу: так, например, на рынке можно найти GT 740 с 4 ГБ GDDR5 памяти. Казалось бы — да у GTX 780 Ti, топовой видеокарты того поколения, всего 3 ГБ памяти — то есть GT 740, получается, лучше? Разумеется нет — на тех настройках графики, где используется столько памяти, эта видеокарта выдает слайд-шоу. Ну а если снизить уровень графики для повышения «играбельности», то окажется, что использовано от силы 1-2 ГБ памяти. Причем такие видеокарты встречаются и в текущих линейках — так, у AMD есть RX 550 с теми же 4 ГБ GDDR5 — с учетом того, что видеокарта выступает приблизительно на уровне GT 1030, очевидно, что использовать столько памяти она сможет в очень немногих задачах:

Так что не стоит судить о производительности видеокарты, опираясь только на объем видеопамяти.

Второй миф. Если видеокарте не хватит видеопамяти в игре, то обязательно будут фризы, вылеты и тому подобное

Опять же, это кажется логичным: если видеокарте памяти не хватило, взять ее больше неоткуда — значит, программы корректно работать не смогут. Однако на деле это, разумеется, не так — любая видеокарта имеет доступ к оперативной памяти, которой обычно куда больше, чем видеопамяти. Конечно, ОЗУ в разы медленнее, а время доступа к ней больше — это может вызвать проблемы с плавностью картинки, но только лишь в том случае, если собственной памяти видеокарте не хватает сильно: например, у нее 2-3 ГБ памяти, а игра требует 4-5 ГБ. Но если не хватает нескольких сотен мегабайт, то обычно это проблем не вызывает: GPU умеют динамически использовать доступные им ресурсы, и в ОЗУ они стараются хранить ту информацию, которая нужна редко или не требует мгновенного отклика.

Третий миф. От разгона видеокарты сгорают

При этом различные производители продают разогнанные с завода версии видеокарт. Разумеется, при разгоне видеокарта может повредиться — но только в том случае, если вы измените «физические» параметры, такие как напряжение. Изменение программных параметров, таких как частоты, никак на «железо» не влияет, так что максимум, что вы получите, это вылет видеодрайвера или BSOD от выставления слишком высокой частоты.

Четвертый миф. SLI/Crossfire увеличивают производительность и объем видеопамяти во столько раз, сколько видеокарт подключено

Насчет производительности это, скорее, не миф, а теоретический результат. Увы — на практике, хотя тому же SLI 20 лет, а Nvidia его использует больше 10 лет, в большинстве игр прирост или околонулевой, или вообще отрицательный. Лишь в единичных проектах можно получить прирост хотя бы 20-30% в сравнении с одной видеокартой, что, конечно, смешно, с учетом двукратного увеличения стоимости и серьезных требований к блоку питания. Что касается вычислительных задач, то тут все сложнее: так, профессиональный софт вполне может использовать несколько GPU эффективно, но это уже не домашнее применение.

Что касается видеопамяти, то тут все просто: при использовании DirectX 11 или ниже в видеопамять каждого используемого GPU записывается одинаковая информация, то есть у связки видеокарт будет по сути тот же объем памяти, что и у одиночной карты. А вот в API DirectX 12 есть возможность более эффективно использовать Split Frame Rendering, когда каждая видеокарта готовит свою часть кадра. В таком случае объемы видеопамяти суммируются — пусть и с оговорками.

Пятый миф. Профессиональные видеокарты лучше игровых

Миф идет от того, что профессиональные видеокарты (такие как Nvidia Quadro или AMD FirePro) стоят обычно сильно дороже пользовательских «игровых» видеокарт — а раз дороже, значит лучше. На практике вопрос только в том — в какой области лучше? С физической точки зрения большая часть профессиональных видеокарт имеют тот же GPU и тот же объем памяти, что и обычные игровые видеокарты, а разница идет только из-за других драйверов, которые больше заточены под профессиональное применение:

С учетом того, что эти драйвера под игры никто специально не адаптирует, то профессиональные видеокарты в играх зачастую будут несколько хуже аналогичных по производительности игровых GPU. С другой стороны, если мы будем сравнивать эти же видеокарты в различных CAD-ах или 3ds Max — перевес будет на стороне профессиональной графики, причем зачастую очень существенный. Так что ответ на миф таков: сравнивать эти видеокарты в лоб не имеет смысла, они «играют» и в разных ценовых сегментах, и в разных сценариях использования.

Шестой миф. Если видеокарта не раскрывается процессором — это плохо

Пожалуй, самый популярный миф, который гласит о том, что если видеокарта не занята на 100% — это плохо. С одной стороны, это кажется логичным: нагрузка ниже 100% означает, что видеокарта частично простаивает и вы недополучаете часть производительности. С другой стороны, многие забывают, что нагрузить GPU на 100% можно практически при любом процессоре. Как так? Очень просто: каждый процессор в каждой игре может подготовить для видеокарты лишь определенное количество кадров в секунду, и чем процессор мощнее — тем больше кадров он может подготовить. Соответственно, чтобы видеокарта была занята на 100%, она должна иметь возможность отрисовать меньше кадров в секунду, чем может дать ей процессор. Как это сделать? Да очень просто: поднять разрешение, поставить более высокие настройки графики, включить тяжелое сглаживание — и вуаля, GTX 1080 Ti в 5К на ультра-настройках графики «пыхтит», выдавая 15-20 кадров в секунду, а поставленный ей в пару двухядерный Intel Pentium едва ли нагружен на половину.

Легко можно получить и обратную ситуацию: взять ту же самую GTX 1080 Ti и запустить на ней игру в HD-разрешении с минимальными настройками графики — и тут даже Core i9-9900K не сможет подготовить для ней столько кадров в секунду, чтобы она была занята на 100%.

Так что тут можно сделать два вывода: во-первых, если видеокарта недогружена несильно, а итоговый fps вас устраивает — всегда можно еще немного увеличить настройки графики, чтобы получить 100% нагрузку на видеокарту с лучшей картинкой и при той же производительности. Во-вторых, собирайте сбалансированные сборки, дабы не было такого, что процессор занят на 100%, а fps в игре 20 кадров.

Седьмой миф. Чем уже шина памяти — тем ниже производительность видеокарты

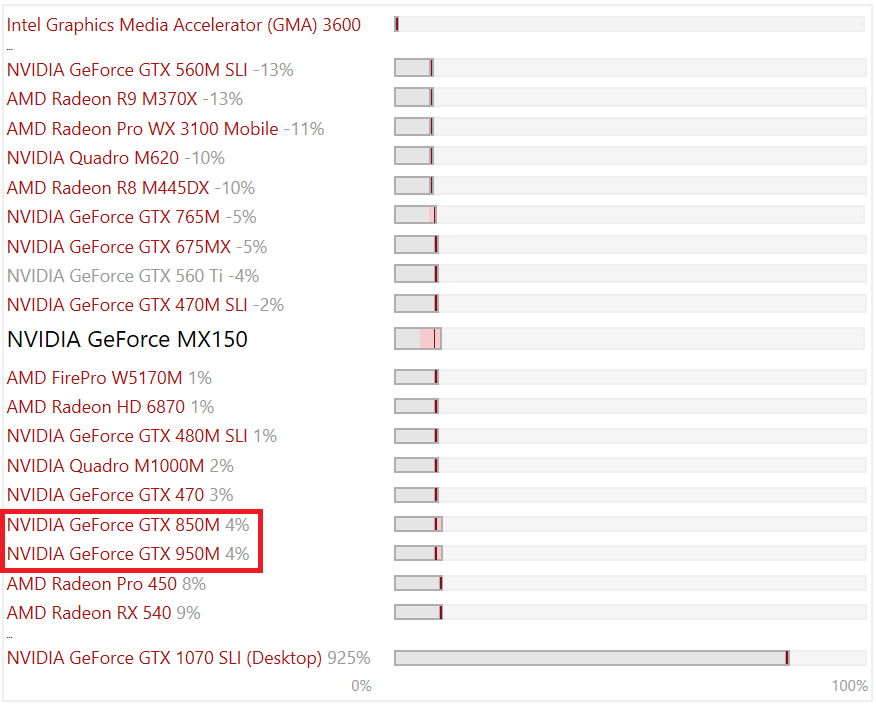

Очень часто на различных форумах можно встретить посты типа «вот, 8 лет назад у GTX 480 шина памяти была 384 бита, а сейчас у GTX 1080 всего 256, Nvidia экономит». Опять кажется, что это логично — чем шире шина, тем больше данных по ней можно «гонять». Но тут следует помнить две вещи: во-первых, не шиной единой: частоты памяти с того времени выросли в разы, во-вторых — производители GPU постоянно улучшают алгоритмы передачи данных по шине, что позволяет использовать ее более эффективно. Все это приводит к тому, что ширину шины можно безболезненно урезать: так, MX150 (она же GT 1030), имея шину всего в 64 бита (как один канал ОЗУ), способна при этом выдавать производительность уровня GTX 950M со 128-битной шиной, которая еще пару-тройку лет назад считалась среднеуровневой мобильной игровой видеокартой:

Восьмой миф. Если видеокарта не перегревается, то она работает на максимально возможной для нее частоте в рамках ее теплопакета

Увы — аналогия с процессорами тут не работает: если те действительно удерживают максимальные частоты в рамках TDP вплоть до температуры, с которой начинается троттлинг из-за перегрева, то видеокарты работают хитрее: так, у Nvidia есть технология GPU Boost, которая, с одной стороны, является аналогом Turbo Boost для процессоров — позволяет поднимать частоту выше базовой — а с другой стороны имеет больше ограничений.

Возьмем, для примера, GTX 1080 Ti. Она имеет родную частоту в 1480 МГц, а Boost — 1580. Но стоит нагрузить видеокарту, как частота может подскочить до 1800-1850 МГц — то есть выше Boost: это и есть работа технологии GPU Boost. Дальше — интереснее: критические температуры у видеокарт поколения Pascal составляют порядка 95 градусов — но уже при 85 можно заметить, что частоты снижаются ближе к уровню Boost. Почему так? Потому что Nvidia ввела еще одну опорную температуру, которую называет целевой: при ее достижении видеокарта старается ее не превышать, а для этого сбрасывает частоты. Так что если у вас мощная видеокарта, да и еще с референсным турбинным охлаждением — внимательно следите за температурами, ибо от них в прямом смысле зависит производительность.

Девятый миф. Видеокарты без дополнительного питания хуже аналогов с ним

В продаже можно встретить видеокарты уровня GTX 1050, 1050 Ti и AMD RX 550 без дополнительного питания — то есть, как в старые добрые времена, достаточно поставить их в слот PCIe и они готовы к работе. При этом также есть версии 1050 и 1050 Ti с дополнительным питанием 6 pin, из-за чего некоторые пользователи делают вывод, что раз дополнительное питание есть — значит с ним видеокарты будут работать лучше.

На деле это не совсем так: слот PCIe способен дать видеокарте до 75 Вт, и этого вполне хватает, чтобы даже 1050 Ti работала на указанных на официальном сайте Nvidia частотах. Но если вы нацелены на разгон — да, тут питания от PCIe видеокарте может уже не хватить, так что дополнительные 6 pin от блока питания позволят достичь больших частот, однако разница в любом случае не превысит 10%.

Десятый миф. Не стоит ставить современные PCIe 3.0 видеокарты на старые платы со слотами PCIe 2.0 или 1.0

Все опять же логично — так, пропускная способность PCIe 2.0 x16 вдвое ниже, чем у 3.0 x16, а, значит, современные видеокарты через более старую шину PCIe будут работать медленнее. На деле это опять же не так — пропускная способность PCI Express 3.0 x16 даже для топовых современных видеокарт оказывается избыточной:

Хорошо видно, что разница между 3.0 x16 и 2.0 x16 составляет всего 1%, то есть погрешность, и даже если спуститься до PCIe 1.1 — то есть к материнским платам почти десятилетней давности — падение производительности оказывается всего лишь 6%. Так что вердикт тут прост — версия PCIe практически не влияет на производительность видеокарты, соответственно можно смело к Xeon с PCI Express 2.0 брать GTX 1080.

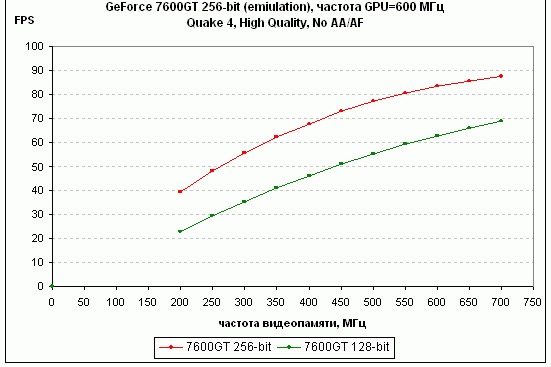

Одиннадцатый миф. Разгон видеопамяти не имеет смысла

Конечно, наибольший прирост дает разгон ядра видеокарты — тут прирост производительности близок к линейному (то есть увеличили частоту на 10% — получили прирост производительности на 10%). Однако не стоит сбрасывать со счетов видеопамять, особенно в слабых видеокартах: зачастую в них ставят те же чипы памяти, что и в более мощные решения, но при этом сильно снижают частоту. Это дает возможность ее достаточно сильно разогнать, зачастую на 20-40%, что может прибавить к общей производительности графики еще 10-15% — для слабых видеокарт это лишним, разумеется, не будет:

Двенадцатый миф. С выходом каждой новой линейки видеокарт производители урезают производительность старой

Достаточно популярный миф, основанный обычно на том, что на одних (обычно более старых) версиях драйверов видеокарта работает лучше, чем на других (обычно более новых). Разумеется, никакого реального основания он не имеет: если бы Nvidia и AMD на самом деле хотели заставить пользователей обновить видеокарты, они бы прекращали их поддержку как производители смартфонов на Android, через пару лет после выхода. Однако на деле даже решения 600-ой линейки от Nvidia, вышедшей более 6 лет назад, до сих пор получают новые драйвера наравне с более новыми видеокартами, причем со всеми программными «плюшками» типа DirectX 12.

Но почему тогда есть разница в производительности между драйверами? Потому что ничто в нашем мире не идеально, и какие-то драйвера, улучшая производительность в новых играх, могут испортить производительность в более старых или привести к различным ошибкам. Обычно через некоторые время выходят исправленные драйвера, и все возвращается на круги своя.

Если вы знаете еще какие-либо мифы — делитесь ими в комментариях.